Одна из теорем Шеннона свидетельствует об уменьшении информационной энтропии множества АВ, образованного в результате взаимодействий двух исходных упорядоченных множеств Либ.

| H (A,B) ≤ H(A) + H(B)

| (3.1)

|

В этом соотношении знак равенства относится к случаю отсутствия взаимодействий между множествами А и В.

В случае взаимодействий происходит уменьшение энтропии на величину:

D H = Н(А) + Н(В) - Н(А,В) (3.2)

Согласно негэнтропийному принципу информации (3.4) получаем:

D IS =Н(А) +Н(В) - Н(А,В) (3.3)

Распространяя рассмотренные Шенноном взаимодействия абстрактных математических множеств на случаи взаимодействий реальных физических систем, можно сделать следующие выводы:

1. Соотношения (3.1), (3.2) и (3.3) можно распространить на случаи взаимодействий упорядоченных физических систем, в частности на взаимодействия физических сред с различными видами полей.

При этом необходимо осуществлять переход от информационной энтропии Н к термодинамическай энтропии S, используя соотношение (1.4) Приложений 1.

2. Знак равенства в соотношении (3.1) соответствует случаю отсутствия взаимодействия между рассматриваемыми физическими системами (например, случай воздействия магнитного поля на не обладающую магнитными свойствами среду).

3. Во всех остальных случаях в соответствии с соотношением (3.3) происходит накопление структурной информации D IS, характеризующей увеличение упорядоченности структуры вновь образующейся системы (формирование и ориентация магнитных доменов под воздействием магнитного поля, структуализация под воздействием электрического поля поляризуемых сред и т.п.).

С помощью вероятностной функции энтропии можно описать формальным математическим языком процесс адапации системы к внешним воздействиям, понимая процесс адаптации как обучение оптимальному поведению в заданных условиях внешней среды.

Рассмотрим систему, обладающую возможностью выбора одного из N возможных ответов (реакций) на внешние воздействия. До прохождения обучения система способна отвечать на любые воздействия лишь выбранной наугад реакцией i, причем i может принимать любые значения от i = 1 до i = N, т.е.:

i=1,2,3,... N, (3.4)

При этом условии вероятности всех ответов равны друг другу, т.е.:

Р1= Р2 = … =PН=1/N (3.5)

Как было показано ранее, при этом условии реальная энтропия Н r равна максимальной энтропии Hmax, т.е.:

| Hr = -

| i = N

| pi log pi = log N = Hmax

| (3.6)

|

| S

|

| i = 1

|

В результате обучения возникают различия вероятностей разных реакций.

В соответствии с рассмотренными ранее свойствами функции

реальная энтропия Hr уменьшается на величину

С точки зрения теории вероятностей начальный алфавит с заданным числом букв представляет собой полную группу событий.

Для полной группы событий при любом распределении вероятностей сумма их всегда равна 1, согласно известному из теории вероятности условию нормировки:

| i = N

| pi = 1

| (3.6)

|

| S

|

| i = 1

|

Смысл условия нормировки заключается в том, что сумма вероятностей выпадения всех 6-ти граней игральной кости равна вероятности выпадения любой грани, т.е.:

Р1 + Р2 + … Р6 = 1/6 + 1/6 + … + 1/6 = 1

6 раз

В рассматриваемом нами процессе обучения, приводящем к дифференцировке значений вероятностей реакций Pi, составляющих полную группу N, условие (3.8) свидетельствует о том, что увеличение вероятностей каких -то реакций может происходить только за счет уменьшения всех остальных вероятностей (чтобы сумма была по-прежнему равна 1, см. рис. 1, случай б ).

В предельном случае одна из N вероятностей может возрасти до 1, тогда все остальные вероятности станут равны 0 (рис. 1).

В случае текста предельному случаю дифференцировки соответствует вероятность одной буквы (например, «е»), равная 1. Вероятности всех остальных букв при этом равна нулю. Это значит, что текст вырождается в повторение одной буквы

е е е е е...

Этот случай соответствует жесткой детерминации (незатухающий строго периодический процесс).

Соответствующее жесткой детерминации распределение вероятностей, при котором некая вероятность Рк равна 1, а все остальные - равны 0, в общем виде запишется как

Рк=1 (3.9)

Р1 = Р2 =...= Рк-1 = Рк+1=...= 0 (3.10)

| Равномерное распределение вероятностей

Нr = Hmax

Дифференцировка вероятностей при соблюдении условия

i=N

S pi = 1

i=1

Hmax > Hr > 0

Предельный случай дифференцировки вероятностей

Н r = 0

|

При подстановке этих значений в функцию энтропии:

| Hr =

| i = N

| pi log pi

| (3.11)

|

| S

|

| i = 1

|

получаем:

Hr=0 (3.12)

Подставляя (3.9) в (3.4), получаем:

D IS = Hmax (3.13)

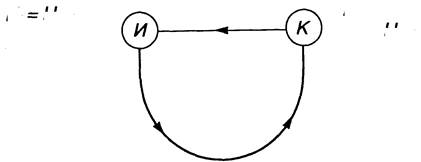

Все стадии перехода от состояния максимальной энтропии, описываемого условиями

(3.4), (3.5), (3.6), к состоянию жесткой детерминации, которому соответствуют условия

(3.9) + (3.13) можно представить в виде дуги, соединяющей исходное состояние

Н с конечным состоянием

К (рис. 2).

На рис.3 изображена расширяющаяяся иерархическая спираль, которая может служить моделью формирования иерархических упорядоченных структур.

Пусть нижний уровень этой спирали (п = 0) соответствует начальному алфавиту, состоящему из N0 различных элементов (букв, атомов, нуклеотидов и др.).

рис. 3

Тогда на уровне N = 1 из этого алфавита можно составить N1 «слов». Если каждое слово состоит из K1 букв, то из N0 букв можно составить число слов, равное:

N1 = N0K1 (3.14)

Соответственно, на уровне п = 2 из N 1 «слов» можно составить количество «фраз», равное:

N2=N 1 K 2 =N 0 K 1 K 2 (3.15)

где Кг - число входящих в каждую «фразу» «слов»

Для упрощения математических выражений мы уже приняли одно допущение, сказав, что все слова содержат одинаковое количество букв (К1), а все фразы содержат одинаковое количество слов (К2). Очевидно, что в реальных системах (например, в письменных текстах) эти условия не соблюдаются. Однако для выполнения общих свойств нашей информационно -энтропийной модели подобные упрощения вполне допустимы, поэтому мы введем еще одно допущение:

K 1 = К 2 = К (3.16)

Подставив (3.16) в (3.15), мы получим:

N2=N0K 2 (3.17)

Проводя аналогичные операции для любой (п-ой) ступени при условии:

K1 = K2 = … = Кп = К,

получим:

Nn = N0K 2 (3.18)

Рассмотрим пример, иллюстрирующий увеличение разнообразия (числа различимых элементов) с переходом на более высокие уровни изображенной на рис. 3.3 спирали в соответствии с формулами (3.14) + (3.18).

Если алфавит (уровень п = 0) содержит 30 букв (N0 = 30), а каждое «слово» искусственного текста состоит из 6 букв (К = 6), то общее число таких «слов» составит:

N1 = N0K1 = 306 = 729 ·106

Среди указанного количества «слов» большинство составят бессмысленные или даже непроизносимые «слова» (из 6-ти гласных, 6-ти согласных и т.п.).

Но если хотя бы 0,01% от общего числа буквенных комбинаций составят осмысленные слова, общий лексикон составит 72 900 слов.

Еще более прогрессивно возрастает число комбинаций с переходами на более высокие уровни n = 2, п = 3 и т.д.

Для определения возрастания информационной емкости по мере перехода на более высокие уровни изображенной на информационно-энтропийной спирали напомним, что максимальное количество структурной информации A/s' накапливается при переходе от Н r ′ = Н max к Н r ′′ = 0, т.е. равно:

D IS = Нr′ – Нr′′ = Hmax

Величина максимальной энтропии для п - ой ступени определяется как:

Нпmax = log Nn = Кn log N0 (3.19)

Сопоставляя величину Нпгнх с величиной энтропии ступени n = О

H 0max = log N0 (3.20)

убеждаемся, что в результате перехода с уровня n = 0 на уровень n, максимальная энтропия возросла в К n раз:

Н п max =К n Н 0max (3.21)

При переходе от исходного состояния Н в конечное состояние К энтропия уменьшается от Н r = Н max до Н r = 0, а величина накапливаемой системой информации соответственно возрастает от I =0 до D IS = Н max (см. рис 1).

При переходе с уровня n = О на уровень n в соответствии с увеличением энтропии в К n раз увеличивается значение D I Smax то есть возрастает потенциальная емкость:

(D I Smax)0 = Kn(D I Smax)0 (3.22)

В качестве примера подсчитаем с помощью формулы (3.22), как будут возрастать размеры витков спирали по мере увеличения номера ступени п.

Приняв условно диаметр витка при n = 0 за 1 см., получим размеры вышележащих витков, сведенные в таблицу 2.

Таблица 2

| п

| 1

| 2

| 3

| 4

| 5

| 6

|

| Диаметры витков в см.

| 1

| 6

| 36

| 216

| 1296

| 7776

|

Таблица 2 дает наглядное представление о степени прогрессивности роста информационной емкости по мере перехода на вышележащие витки. Нетрудно заметить, что при n = 3, размеры витка (36 см.) близки к размерам раскрытой книжки, при n = 5 – кразмерам довольно просторной залы (с диаметром 12,96 м), а при п = 6 – к размерам городской площади (с диаметром 77,76 м).

Вследствие роста информационной емкости система, поднимаясь в процессе развития на все более высокие уровни иерархической спирали и постоянно стремясь к состоянию жесткой детерминации, оказывается тем дальше от этого состояния (в смысле потенциальной возможности накопления информации), чем больше витков в этой спирали ей удается пройти.

Как уже отмечалось, системы в своем развитии, как правило, не достигают состояния жесткой детерминации. Условием их динамичного равновесия оказывается сочетание частично детерминированных, а частично вариабельных (вероятностых) внутренних связей. Соотношение степени детерминации и вариабельности внутренних связей может быть выражено количественно как отношение величины остаточной энтропии Н r к количеству накопленной и сохраняемой структурной информации D IS:

где G – коэффициент стохастичности (вариабельности, гибкости) внутренних связей.

Оптимальным соотношением жесткости и гибкости внутренних связей Gopt оказывается такое соотношение, которое соответствует степени вариабельности условий внешней среды.

Результаты исследований статистических свойств письменных текстов дали близкие результаты для всех европейских языков:

G @ ¼

Очевидно, эта величина G является для языка оптимальной, так как она характеризует соотношение, возникшее в результате эволюционного развития языка. Будучи величиной статистической, она может варьироваться в зависимости от характера текста: для служебных бумаг и инструкций G < G opt, для поэтических текстов G > Gopt.

Чем больше величина G, тем менее избыточным будет текст. Избыточность текста характеризуется коэффициентом избыточности R, определяемым как:

| R =

| Hmax - Hr

| =

| D IS

|

| (3.24)

|

| Hmax

| Hmax

|

Сопоставляя (3.23) и (3.24). можно выразить величину G через R как:

ИНФОРМАЦИЯ И ЭНЕРГИЯ

Для выявления взаимосвязи структурной информации с внутренней энергией систем воспользуемся уравнением Гельмгольца:

U=F+ST (4.1)

где: U - внутренняя энергия;

F - свободная часть внутренней энергии;

ST - связанная (энтропийная) часть внутренней энергии;

S - физическая энтропия;

Т - абсолютная температура.

В состоянии термодинамического равновесия вся внутренняя энергия становится «энтропийной», а сама энтропия достигает максимальной величины[3].

Таким образом, при достижении равновесия достигается условие:

F=0 (4.2)

из которого, согласно (4.1) следует:

U = Smax T (4.3)

или:

Преобразуем выражение (4.1), поделив левую и правую части уравнения на Т:

Подставляя (4.4) в (4.5) и перенося член S в левую часть с противоположным знаком, получаем:

Для дальнейшего рассмотрения к входящему в выражение члену S добавим индекс r, имея в виду, что Sr – это та реальная энтропия, внутренняя энергия которой определяется выражением (4.1).

Учитывая, что в соответствии с соотношением (1. 4)

S = K H (4.7)

приведем выражение (4.6) к виду:

| F

| =

| K (Hmax – Hr)

| (4.8)

|

| T

|

где К – постоянная Больцмана;

Нтах – максимальная информационная энтропия;

Н r – реальная информационная энтропия.

Сопоставляя (4.8) с ранее полученным выражением (2.7) получаем:

Полученное соотношение свидетельствует о том, что при неизменном значении температуры Т свободная часть внутренней энергии F зависит только от количества сохраняемой системой структурной информации D IS.

Другими словами, свободная энтропия F – это часть энергии, которая расходуется на определяющие структурную организацию системы межэлементной связи.

Г.Гельмгольц назвал эту часть внутренней энергии «свободной энергией» имея в виду, что эту энергию, в отличие от составляющей внутренней энергии ST, можно «освободить» для той или иной полезной работы. Такое «освобождение» осуществляется путем разрушения внутренних связей, определяющих структуру используемых для этой цели систем: сжигания органических веществ (нефти, угля), разрушения атомов или атомных ядер и т.п.

Введем понятие потенциального коэффициента полезного действия η, показывающего, какая часть внутренней энергии может быть, в принципе, использована для полезной работы:

С учетом (4.4) и (4.9) выражение (4.10) приводится к виду:

Сопоставляя (4.11) с выражением (3.24), приходим к выводу, что потенциальный КПД η равен коэффициенту избыточности R.

Рассмотрим два крайних состояния систем, одному из которых соответствуют условия D IS = 0 (состояние равновесия), а другому – D IS = Н max (жесткая детерминация).

В соответствии с выражением (4.11) в состоянии равновесия η = 0 (поскольку вся внутренняя энергия в этом случае оказывается не «свободной», а «связанной», т.к. F = 0, a U = Smax T).

При жесткой детерминации (D IS = Н max) в соответствии с (4.11), η = 1.

Это условие означает, что вся внутренняя энергия расходуется только на сохранение межэлементных структурных связей, поэтому структура такой системы останется неизменной (жестко детерминированной) до тех пор, пока система не разрушится под влиянием изменившихся условий внешней среды.

При неизменных внешних условиях и при η = 1 осуществляется «вечное движение», примером которого может служить жестко детерминированное движение небесных светил и планет.

ЗАКЛЮЧЕНИЕ.

Подводя итог всему, что было сказано выше, отметим, что по мере того, как рациональная наука все глубже и глубже постигает сложность организации существующих в мире систем она все в большей мере осознает недостаточность ранее признанных редукционистских концепций. Поиски источников информации определяющей структуры и функции сложных систем, приводят науку к необходимости создания телеологических концепций, то есть, в конечном счете, к признанию некого организующего начала, которое и есть не что иное, как проявление воли Творца.

СПИСОК ЛИТЕРАТУРЫ

1. Седов Е., Кузнецов Д. В начале было Слово… – СПб., 1994.

2. Шеннон К.Е. Математическая теория связи. Работы по теории инфор -мации и кибернетике., М, 1963.

3. Шеннон К. Е. Бандвагон. /Работы по теории информации и кибернетике/, М., 1963.

4. Бриллюэн Л. Научная неопределенность и информация, М.,1966.

5. Винер Н. Кибернетика, или Управление и связь в животном и машине. М, 1968.

6. Аптер М. Кибернетика и развитие М. 1970.

7. Седов Е.А. Взаимосвязь информации, энергии и физической энтропии в процессах управления и самоорганизации. Информация и управление. М., Наука, 1986.

8. Седов Е.А. Эволюция и информация. М., Наука, 1976.

9. Шеннон К. Е. Предсказание и энтропия английского печатного текста.

10. Пригожий И., Ствнгврс И. Порядок из хаоса. М.. Прогресс, 1986.

11. Тейяр де Шарден Феномен человека. М., Наука, 1987.

[1] Зависимость вероятностей последующих событий от предыдущих определяется в теории вероятностей термином «корреляция».

[2] Близкое к указанному сочетание избыточной и непредсказуемой информации было затем получено в результате анализа тестов на русском и ряде европейских языков.

[3] Данное состояние относится к категории теоретических абстракция, поскольку при достижении термодинамического равновесия не разрешается структура элементарных частиц.