Количество информации – в теории информации – мера информации, сообщаемой появлением события определённой вероятности; или мера оценки информации, содержащейся в сообщении или мера, характеризующая уменьшение неопределённости, содержащейся в одной случайной величине относительно другой.

Предположим, что какое-то событие имеет m равновероятных исходов. Таким событием может быть, например, появление любого символа из алфавита, содержащего m таких символов. Как измерить количество информации, которое может быть передано при помощи такого алфавита? Это можно сделать, определив число N возможных сообщений, которые могут быть переданы при помощи этого алфавита. Если сообщение формируется из одного символа, то N = m, если из двух, то N = m*m = m2. Если сообщение содержит n символов (n - длина сообщения), то N = mn Казалось бы, искомая мера количества информации найдена. Ее можно понимать как меру неопределенности опыта, если под опытом подразумевать случайный выбор какого-либо сообщения из некоторого числа возможных. Однако эта мера не совсем удобна. При наличии алфавита, состоящего из одного символа, т.е. когда m = 1, возможно появление только этого символа. Следовательно, неопределенности в этом случае не существует, и появление этого символа не несет никакой информации. Между тем, значение N при m = 1 не обращается в нуль. Для двух независимых источников сообщений (или алфавита) с N1 и N2 числом возможных сообщений общее число возможных сообщений N = N1N2, в то время как логичнее было бы считать, что количество информации, получаемое от двух независимых источников, должно быть не произведением, а суммой составляющих величин. Выход из положения был найден Р.Хартли, который предложил информацию I, приходящуюся на одно сообщение, определять логарифмом общего числа возможных сообщений N: I(N)=logN (1)

Если-же все множество возможных сообщений состоит из одного (N = m = 1), то I(N) = log 1 = 0, что соответствует отсутствию информации в этом случае. При наличии независимых источников информации с N1 и N2 числом возможных сообщений

I(N) = logN = log N1N2 = log N1 + logN2, т.е. количество информации, приходящееся на одно сообщение, равно сумме количеств информации, которые были бы получены от двух независимых источников, взятых порознь. Формула, предложенная Хартли, удовлетворяет предложенным требованиям. Поэтому ее можно использовать для измерения количества информации.

Если возможность появления любого символа алфавита равновероятна (а мы до сих пор предполагали, что это именно так), то эта вероятность р = 1 / m. Полагая, что N=m,

I = logN = log m = logl/p = -log p, (2) т.е. количество информации на каждый равновероятный сигнал равно минус логарифму вероятности отдельного сигнала.

Полученная формула позволяет для некоторых случаев определить количество информации. Однако для практических целей необходимо задаться единицей его измерения. Для этого предположим, что информация - это устраненная неопределенность. Тогда в простейшем случае неопределенности выбор будет производиться между двумя взаимоисключающими друг друга равновероятными сообщениями, например между двумя качественными признаками: положительным и отрицательным импульсами, импульсом и паузой и т.п. Количество информации, переданное в этом простейшем случае, наиболее удобно принять за единицу количества информации. Именно такое количество информации может быть получено, если применить формулу (2) и взять логарифм по основанию 2. Тогда I = -log2p = - lo gl/2 = log22 = 1

Полученная единица количества информации, представляющая собой выбор из двух равновероятных событий, получила название двоичной единицы, или бита. Название bit образовано из двух начальных и последней букв английского выражения binary digit, что значит двоичная единица. Бит является не только единицей количества информации, но и единицей измерения степени неопределенности. При этом имеется в виду неопределенность, которая содержится в одном опыте, имеющем два равновероятных исхода.

На количество информации, получаемой из сообщения, влияет фактор неожиданности его для получения того или иного сообщения. Чем меньше эта вероятность, тем сообщение более неожиданно и, следовательно, более информативно. Сообщение, вероятность которого высока и, соответственно, низка степень неожиданности, несет немного информации.

Р. Хартли понимал, что сообщения имеют различную вероятность и, следовательно, неожиданность их появления для получателя неодинакова. Но, определяя количество информации, он пытался полностью исключить фактор "неожиданности". Поэтому формула Хартли позволяет определить количество информации в сообщении только для случая, когда появление символов равновероятно и они статистически независимы. На практике эти условия выполняются редко. При определении количества информации необходимо учитывать не только количество разнообразных сообщений, которые можно получить от источника, но и вероятность их получения.

Наиболее широкое распространение при определении среднего количества информации, которое содержится в сообщениях от источников самой разной природы, получил подход К. Шеннона. Рассмотрим следующую ситуацию.

Источник передает элементарные сигналы k различных типов. Проследим за достаточно длинным отрезком сообщения. Пусть в нем имеется N1 сигналов первого типа, N2 сигналов второго типа, …, N k сигналов k -го типа, причем N1 + N2 +... + Nk = N - общее число сигналов в наблюдаемом отрезке, f1, f2,..., fk - частоты соответствующих сигналов.

При возрастании длины отрезка сообщения каждая из частот стремится к фиксированному пределу, т.е.

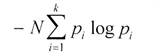

lim f i = pi (i = 1,2,..., k), где pi можно считать вероятностью сигнала. Предположим, получен сигнал i -того типа с вероятностью p i, содержащий -logpi единиц информации. В рассматриваемом отрезке i -й сигнал встретится примерно Npi раз (будем считать, что N достаточно велико), и общая информация, доставленная сигналами этого типа, будет равна произведению -Np i logpi. То же относится к сигналам любого другого типа, поэтому полное количество информации, доставленное отрезком из N сигналов, будет примерно равно

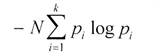

Чтобы определить среднее количество информации, приходящееся на один сигнал, т.е. удельную информативность источника, нужно это число разделить на N. При неограниченном росте числа сигналов приблизительное равенство перейдет в точное. В результате будет получено асимптотическое соотношение - формула Шеннона:

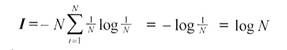

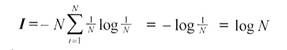

В последнее время она стала не менее распространенной, чем знаменитая формула Эйнштейна Е=mс2. Оказалось, что формула, предложенная Хартли, представляет собой частный случай более общей формулы Шеннона. Если в формуле Шеннона принять, что p1= p2 =... = pi =... pn = 1 /N,

то

Знак минус в формуле Шеннона не означает, что количество информации в сообщении - отрицательная величина. Объясняется это тем, что вероятность р, согласно определению, меньше единицы, но больше нуля. Так как логарифм числа, меньшего единицы, т.е. logpi - величина отрицательная, то произведение вероятности на логарифм числа будет положительным.