И проектирования систем

Современное понимание того, что такое информация и какую роль она играет в искусственных и естественных системах, сложилось не сразу; оно представляет собой совокупность знаний, полученных разными науками: физикой, биологией, философией, теорией связи и т.д.

Хотя физика старается изучать явления природы в максимально объективированной (т.е. не связанной с человеком и его воздействием на окружающий мир) форме, ей не удалось полностью исключить "человеческий фактор". Во-первых, при экспериментальном исследовании физических явлений невозможно обойтись без измерения ряда величин, и наличие этих величин в теоретических моделях рано и поздно требует специального рассмотрения того, как именно проводятся измерения, — а без влияния человека не проводятся даже автоматические эксперименты. Во-вторых, физика не могла не заняться изучением технических (т.е. созданных человеком) устройств и тут-то и "попала в ловушку": полностью объективистский подход к машинам все равно обнаружил в их поведении следы человеческой деятельности. Впервые это произошло в термодинамике — науке, изучающей процессы в тепловых машинах. Оказалось, что без введения специального понятия энтропии невозможно дать исчерпывающего описания их действия. Скачок в понимании природы этой величины произошел, когда JI. Больцман дал ей статистическую интерпретацию (1877); уже сам Больцман обронил фразу о том, что энтропия характеризует недостающую информацию, но тогда этой фразы никто не понял.

После построения К. Шэнноном теории информации (1948), когда оказалось, что формула Шэннона для информационной энтропии и формула Больцмана для термодинамической энтропии оказались тождественными, разгорелись споры о том, является ли это совпадение чисто формальным или оно выражает глубокую связь термодинамики и теории информации. Дискуссии (в особенности благодаря работам Бриллюэна [ 1; 2]) привели к современному пониманию этой неразрывной связи.

Совсем с другой стороны к этой проблеме пришла философская теория познания. Изначальный смысл слова "информация" как "знания, сведения, сообщения, уведомления, известия, ведомости", т.е. нечто присущее только человеческому сознанию и общению, начал расширяться и обобщаться. Признав, что наше знание есть отражение реального мира, материалистическая теория познания установила, что отражение является всеобщим свойством материи. Сознание человека является высшей, специфической формой отражения, но существуют и другие формы — психическая (присущая не только человеку, но и животным), раздражимость (охватывающая, кроме того, растения и простейшие организмы) и, наконец, самая элементарная форма — запечатление взаимодействия (присущая и неорганической природе, и элементарным частицам, т.е. всей материи вообще). И теперь, как только состояния одного объекта находятся в соответствии с состояниями другого объекта (будь то соответствие между положением стрелки вольтметра и напряжением на его клеммах или соответствие между нашим ощущением и реальностью), мы говорим, что один объект отражает другой, содержит информацию о другом.

Так вновь сомкнулись результаты философского и естественнонаучного исследования природы. Иначе и быть не могло — ведь предмет изучения един, хотя это изучение ведется с разных позиций и разными методами. В настоящее время информация рассматривается как фундаментальное свойство материи.

Таким образом, ясно, что роль информации в самом существовании систем, искусственных и естественных, огромна. Понятие информации, обладая всеобщностью, приобрело смысл философской категории. Для кибернетики, да и всей системологии, понятие информации столь же фундаментально, как понятие энергии для физики. Недаром признается не менее общим, чем определение А.И. Берга (см. гл. 1), определение кибернетики, предложенное А.Н. Колмогоровым: кибернетика — это наука, которая занимается изучением систем любой природы, способных воспринимать, хранить и перерабатывать информацию и использовать ее для управления и регулирования.

Сигнал есть материальный носитель информации, средство перенесения информации в пространстве и времени.

Утверждая, что объекты выступают в качестве сигналов, мы должны сделать уточнение. Один и тот же объект может "выступать в качестве" разных сигналов: колебания воздуха могут нести звуки музыки, речь лектора, пение птиц или шум самолета; с магнитной ленты можно стереть одну запись и сделать другую и т.д. Следовательно, в качестве сигналов используются не сами по себе объекты, а их состояния.

Далее, не всякое состояние имеет сигнальные свойства. Точнее говоря, данный объект взаимодействует не только с тем объектом, информацию о котором мы хотели бы получить, но и с другими, не интересующими нас объектами. В результате соответствие состояний ослабевает, разрушается. Условия, обеспечивающие установление и способствующие сохранению сигнального соответствия состояний, называются кодом (в искусственных системах кодом называют комплекс правил образования сигнала. При более подробном рассмотрении этого процесса в технических системах кодом называют условные, варьируемые правила, а диктуемые техникой условия называют модуляцией. Мы же будем пока использовать самое общее употребление слова "код").Посторонние воздействия, нарушающие это соответствие, называются помехами или шумами. Нарушение соответствия может происходить не только вследствие помех, но и из-за рассогласования кодов взаимодействующих объектов. В искусственных системах, где такое согласование организуется специально, это явно видно на примере криптографии, основанной на засекречивании кодов. В природных системах согласование кодов происходит в самой структуре систем через естественный отбор различных вариантов.

Сигналы играют в системах особую, очень важную роль. Если энергетические и вещественные потоки, образно говоря, питают систему, то потоки информации, переносимые сигналами, организуют все ее функционирование, управляют ею.

Необходимость моделирования самых разнообразных сигналов приводит к построению частных моделей случайных процессов, т.е. наложением дополнительных ограничений на параметры распределений и на сами распределения. Перечислим наиболее важные классы случайных процессов.

Непрерывные и дискретные по времени процессы. Случайный процесс с непрерывным временем характеризуется тем, что его реализации определяются для всех моментов из некоторого (конечного или бесконечного) интервала Т параметра t. Дискретный по времени процесс задается на дискретном ряде точек временной оси (обычно равноотстоящих).

Непрерывные и дискретные по информативному параметру процессы. Эти процессы различаются в зависимости от того, из какого (непрерывного или дискретного) множества принимает значение реализация х случайной величины X.

Стационарные и нестационарные процессы. Так называются процессы в зависимости от постоянства или изменчивости их статистических характеристик. Случайный процесс называется стационарным в узком смысле, если для любого п конечномерные распределения вероятностей не изменяются со временем, т.е. при любом т выполняется условие

\ti + т, t2 + Т,..., tn +т) =Pn(X\,-,X„\tl, t2 t„).

Если же условие независимости от времени выполняется только для первых двух моментов (среднего и функции автокорреляции), то процесс называется стационарным в широком смысле (или в смысле Хинчина).

Эргодические и неэргодические процессы. На практике при описании случайных величин вместо рассмотрения их распределений часто ограничиваются только их числовыми характеристиками, обычно моментами. В тех случаях, когда распределение неизвестно, моменты (и другие числовые характеристики) можно оценить статистически.

Перенос такой практики на произвольные случайные процессы требует не только учета зависимости отстоящих друг от друга ("разнесенных") во времени значений, но и наложения дополнительных требований. Требование совпадения величин, получающихся при усреднении по ансамблю (т.е. при фиксированном времени) и при усреднении по времени (точнее, по одной реализации), и называется условием эргодичности. Это требование можно толковать и как совпадение результатов усреднения по любой реализации. Как и для стационарности, можно различать эргодичность в узком и широком смысле.

Первым специфическим понятием теории информации является понятие неопределенности случайного объекта, для которой удалось ввести количественную меру, названную энтропией. Начнем с простейшего варианта — со случайного события. Пусть, например, некоторое событие может произойти с вероятностью 0,99 и не произойти с вероятностью 0,01, а другое событие имеет вероятности соответственно 0,5 и 0,5. Очевидно, что в первом случае результатом опыта "почти наверняка" является наступление события, во втором же случае неопределенность исхода так велика, что от прогноза разумнее воздержаться.

Для характеристики размытости распределений широко используется второй центральный момент (дисперсия) или доверительный интервал. Однако эти величины имеют смысл лишь для случайных числовых величин и не могут применяться к случайным объектам, состояния которых различаются качественно, хотя и в этом случае можно говорить о большей или меньшей неопределенности исхода опыта. Следовательно, мера неопределенности, связанной с распределением, должна быть некоторой его числовой характеристикой, функционалом от распределения, никак не связанным с тем, в какой шкале измеряются реализации случайного объекта

Из опыта мы знаем, что не существует проблемы, если мы желаем преобразовать механическую энергию в тепло. Для примера рассмотрим соскальзывание камня с горки. Сила тяжести совершает работу, камень начинает соскальзывать с горки, т.е. приобретает скорость. Трение тормозит движение камня, из-за чего повышается температура в местах соприкосновения камня и горки. тепло течет от более нагретых частей системы к более холодным и таким образом рассеивается в окружающем камень пространстве и в самом камне. В данном примере энергия механического движения преобразуется в теплоту безо всяких затруднений.

Попробуем обратить рассмотренный процесс. будем нагревать камень, надеясь, что благодаря нагреванию совершится механическая работа, т.е. камень поднимется вверх на горку. Сколько бы попыток мы не совершили, камень по-прежнему останется у основания горки. Мы видим, что в этом случае преобразование теплоты в механическую работу вызывает затруднения. Возникает вопрос – почему? Ведь такой процесс не противоречит закону сохранения энергии.

Т.е. в природе существует множество процессов, которые происходят самопроизвольно, хотя обратные процессы никогда не наблюдаются. приведем еще примеры. Чашка, стоящая на краю стола, будет разбита, если уроните ее на пол, однако сколько бы вы ни прикладывали ту же самую силу, которая привела к падению чашки, черепки никогда не соберутся снова. Духи из флакона самопроизвольно распространятся по комнате, но никогда сами по себе не соберутся опять во флакон. Интересно, что в приведенных примерах реализация обратных процессов не привела бы к нарушению закона сохранения энергии (первое начало термодинамики).

Для того чтобы объяснить отсутствие обратимости множества процессов, наблюдаемых в природе, во второй половине 19 в. был сформулирован новый закон - второе начало термодинамики. Согласно этому закону, можно судить, какие процессы возможны в природе, а какие – нет. Второе начало термодинамики можно сформулировать несколькими способами. В принципе, все они эквивалентны друг другу.

Первая формулировка принадлежит Клаузису (1822-1888): теплота в естественных условиях переходит от горячего тела к холодному, в то время как от холодного тела к горячему теплота сама по себе не переходит. Очевидно, формулировка Клаузиуса относится к процессу обмена теплотой и, с первого взгляда, не вполне ясно, как применить ее к более широкому классу процессов.

Исторически более общая формулировка была получена в ходе изучения тепловых двигателей. тепловой двигатель это любое устройство, которое преобразует теплоту в механическую работу. В таком устройстве рабочее тело обязательно получает некоторое количество теплоты Q1 от нагревателя, совершает механическую работу А и часть теплоты Q2 передает холодильнику. Термический коэффициент полезного действия h определяется формулой:

Было бы великолепно, если бы вся теплота, полученная от нагревателя, превратилась в механическую работу (в этом случае Q2 =0). Коэффициент полезного действия такого двигателя оказался бы равным 100%! Этот двигатель получил название вечный двигатель второго рода («перпетум мобиле второго рода»). Но все попытки сконструировать двигатель, который позволял бы превратить всю теплоту, полученную от нагревателя, в эквивалентную ей механическую работу, оказались безуспешными. Т.е. такой двигатель невозможен. В связи с чем и появилась еще одна формулировка второго начала термодинамики (Кельвина -Планка): невозможен периодический процесс, единственным результатом которого является превращение теплоты, полученной от нагревателя, в эквивалентную ей механическую работу.

Наиболее общая формулировка второго начала термодинамики была дана позже. Она носит название «принцип возрастания энтропии» (или «неравенство Клаузиуса»). Дадим эту формулировку без использования понятия энтропия: любые процессы, происходящие в замкнутой системе, переводят ее из более упорядоченного в более беспорядочное (хаотическое) состояние. Замкнутой системой называется такая система, которая не обменивается с окружающей средой веществом и (или) энергией.

Таким образом, второе начало термодинамики указывает направление происходящих в замкнутых системах процессов: возможны лишь такие процессы, которые приводят к возрастанию хаоса и беспорядка в замкнутых системах, к снижению уровня их организованности. Именно поэтому говорят, что второе начало термодинамики определяет термодинамическую стрелу времени. Для замкнутых систем нормальному ходу времени соответствуют процессы, приводящие к увеличению хаоса и беспорядка в этих системах.

Дадим теперь формулировку второго начала термодинамики, используя понятие «энтропия». Понятие «энтропия» сегодня настолько широко используется в научно-популярной литературе, что можно сказать: это понятие стало частью общей культуры, а не просто научным термином.

Энтропия – это физическая величина, которая характеризует степень неупорядоченности любой системы: чем больше энтропия, тем более неупорядоченное состояние занимает система; чем меньше энтропия, тем меньше в системе хаоса и беспорядка, тем более организованной она является.

В физике показано, что энтропия также характеризует отклонение системы от равновесия. Равновесному состоянию системы соответствует максимум хаоса и беспорядка. Чем более упорядоченной (другими словами, более организованной) является система, тем дальше она удалена от равновесия. Все сказанное иллюстрирует рис. 2.3.

Теперь можно дать еще одну формулировку второго начала термодинамики: при любых процессах полная энтропия замкнутой системы либо увеличивается, либо остается постоянной. (Среди физиков бытует шутка, в которой энтропия сравнивается со старой властной теткой: ее все недолюбливают, но она всегда права.)

| Равновесное состояние системы

|

| Система уходит от равновесного состояния

|

| Наименьший порядок в системе

(максимум хаоса)

|

| Порядок возрастает, хаотичность снижается

|

Рис. 2.3. Иллюстрация к толкованию термина «энтропия»

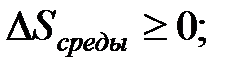

Энтропию принято обозначать латинской буквой S. Если энтропия замкнутых систем может только возрастать или оставаться постоянной, это означает, что изменение энтропии D S может быть либо больше нуля, либо равно нулю. Математически эта формулировка записывается так (это и есть неравенство Клаузиуса):

Изменение энтропии равно нулю для обратимых процессов и больше нуля во всех других случаях. Все реальные процессы, происходящие в природе, являются необратимыми.

Таким образом, второе начало термодинамики говорит о том, как изменяется степень упорядоченности любой замкнутой системы с нормальным течением времени. Понятно, что замкнутой системой может быть только неживой объект.

Рассмотрим, распространяется ли второе начало термодинамики на живые объекты. Первоначально выделим три наиболее характерные отличия живого и неживого вещества с точки зрения физики

Во-первых, любое живое существо является принципиально открытой системой, которая обменивается с окружающей средой веществом и энергией. Во-вторых, для нормальной жизнедеятельности живого организма важно, чтобы его энтропия не возрастала (соответственно степень упорядоченности не уменьшалась) в процессе жизни. Это означает, что изменение энтропии живого вещества D Sживого должно быть отрицательным или, в крайнем случае, равным нулю:  . В-третьих, любой живой организм (даже простейший) является высокоорганизованной системой, далекой от состояния теплового равновесия с окружающей средой. Каким же образом удается живой системе длительное время поддерживать свою высокую упорядоченность, свое «неравновесие» с окружающей средой?

. В-третьих, любой живой организм (даже простейший) является высокоорганизованной системой, далекой от состояния теплового равновесия с окружающей средой. Каким же образом удается живой системе длительное время поддерживать свою высокую упорядоченность, свое «неравновесие» с окружающей средой?

Для ответа на поставленный вопрос рассмотрим некоторое живое существо (например, зайца в лесу), которое для поддержания своей жизнедеятельности взаимодействует с окружающей средой (рис. 2.4). В данном случае окружающей средой является лес. Строго говоря, в окружающую среду следует добавить еще атмосферу и Солнце. «Живое» в процессе своей жизнедеятельности обменивается с окружающей средой веществом и энергией.

Рис. 2.4. Эволюция «живого»

Это означает, что изменение энтропии живого вещества D Sживого должно быть отрицательным или, в крайнем случае, равным нулю:  .

.

«Живое» является открытой системой. Образуем из живого существа и окружающей среды замкнутую систему, для которой должно выполняться второе начало термодинамики ( ). Изменение энтропии этой замкнутой системы складывается из изменения энтропии «живого» и изменения энтропии окружающей среды:

). Изменение энтропии этой замкнутой системы складывается из изменения энтропии «живого» и изменения энтропии окружающей среды:

(2.3)

(2.3)

Поскольку первое слагаемое должно быть отрицательным, а сумма положительной, то достичь этого можно лишь при условии, если изменение энтропии окружающей среды будет больше нуля, да еще по модулю превосходить изменение энтропии живого:

(2.4)

(2.4)

Отметим, что наиболее важные результаты теории информации — теоремы о кодировании — являются теоремами о существовании и носят асимптотический характер, т.е. не являются конструктивными. Однако уже само знание потенциальных возможностей имеет огромное значение: сравнение характеристик реальных систем с теоретическими пределами позволяет судить о достигнутом уровне и о целесообразности дальнейших затрат на его повышение. Прикладные же вопросы рассматриваются в специальном разделе теории информации — теории кодирования, которая изучает способы построения конкретных кодов и их свойства, в частности точные или граничные зависимости вероятностей ошибок от параметров кода.

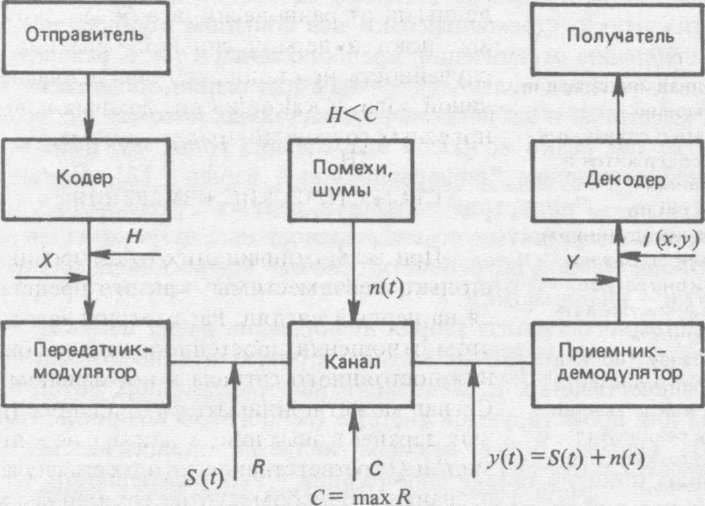

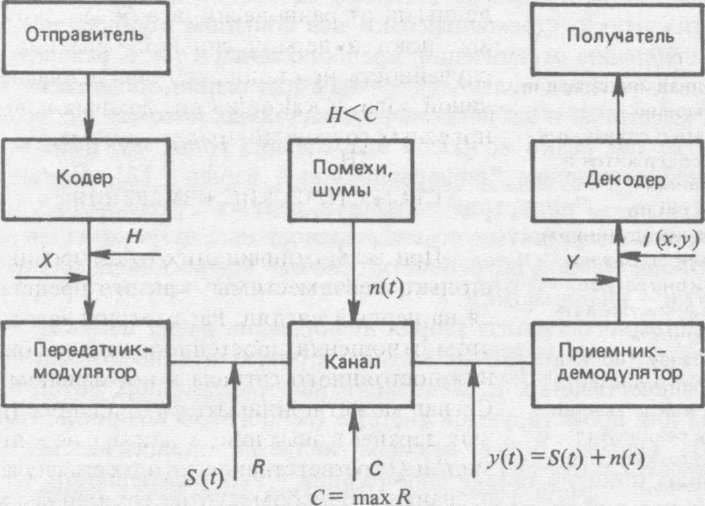

Для напоминания об основных понятиях теории информации приведем вариант блок-схемы системы передачи информации (рис.). На этом рисунке приведено большинство введенных в данной главе понятий и обозначений.

Значение теории информации выходит далеко за рамки теории связи, так как именно ее появление привело к широкому обсуждению новых понятий, к более глубокому пониманию открытых ранее закономерностей природы (например, второго закона термодинамики) и в конечном счете к тому, что понятие информации вошло теперь в число философских категорий, расширив и углубив тем самым наше видение и понимание мира.

Блок схема передачи информации

Вместе с тем некоторые специалисты различных отраслей науки некритически распространяли методы и конкретные результаты теории информации на Любые информационные процессы в реальном мире. Уже сам Шэннон заметил эту тенденцию и настоятельно предостерегал от того, чтобы ей безоглядно следовать [8]. Дело в том, что шэнноновское количество информации является характеристикой, лишь с одной стороны описывающей информационные отношения. Именно эта сторона — соответствие состояний — играет главную роль в технических устройствах. Однако в этом соответствии не проявляют себя (и, следовательно, могут не учитываться) такие свойства информации, как смысл, доброкачественность (степень истинности), ценность, полезность, временное старение, причинно-следственная направленность и т.д. — свойства, весьма существенные для информационных отношений с участием живых организмов, людей, коллективов. Исследование проблем использования информации ведется в различных направлениях, достигнуты и успехи (семиотика, теория полезности, теория решений и выбора и т.д.). С некоторыми из них мы познакомимся в других разделах книги.

Необходимость расширения принципов и методов исследования информационных процессов вытекает не только из внутренней логики развития науки, стремящейся ко все большим обобщениям, снятию или ослаблению ограничений, предположений и т.п. К развитию новых подходов толкает сильное "внешнее" давление общественной практики: масштабы и значение информационных потоков в современном обществе так резко возросли в последние годы, что даже возникло образное выражение "информационный взрыв" [3]. Появилась новая отрасль — "индустрия обработки данных", затраты на которую в промышленно развитых странах превосходят затраты на энергетику. Этой общественной потребности отвечает возникновение новой отрасли науки — информатики.

Для системного анализа теория информации имеет двоякое значение. Во-первых, ее конкретные методы и результаты позволяют провести ряд количественных исследований информационных потоков в изучаемой или проектируемой системе (если в этом возникнет необходимость). Однако более важным является эвристическое значение основных понятий теории информации — неопределенности, энтропии, количества информации, избыточности, пропускной способности и пр. Их использование столь же важно для понимания системных процессов, как и использование понятий, связанных с временными, энергетическими процессами. Системный анализ неизбежно выходит на исследование ресурсов (наличных и необходимых), которые потребуются для решения анализируемой проблемы. Информационные ресурсы играют далека не последнюю роль наряду с остальными ресурсами – материальными, энергетическими, временными, кадровыми.

. В-третьих, любой живой организм (даже простейший) является высокоорганизованной системой, далекой от состояния теплового равновесия с окружающей средой. Каким же образом удается живой системе длительное время поддерживать свою высокую упорядоченность, свое «неравновесие» с окружающей средой?

. В-третьих, любой живой организм (даже простейший) является высокоорганизованной системой, далекой от состояния теплового равновесия с окружающей средой. Каким же образом удается живой системе длительное время поддерживать свою высокую упорядоченность, свое «неравновесие» с окружающей средой? .

. (2.3)

(2.3)

(2.4)

(2.4)