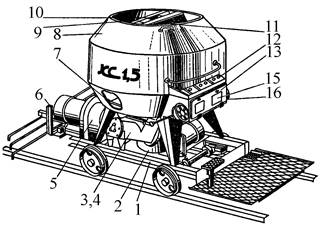

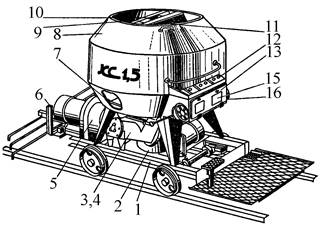

Кормораздатчик мобильный электрифицированный: схема и процесс работы устройства...

Типы сооружений для обработки осадков: Септиками называются сооружения, в которых одновременно происходят осветление сточной жидкости...

Кормораздатчик мобильный электрифицированный: схема и процесс работы устройства...

Типы сооружений для обработки осадков: Септиками называются сооружения, в которых одновременно происходят осветление сточной жидкости...

Топ:

Проблема типологии научных революций: Глобальные научные революции и типы научной рациональности...

Когда производится ограждение поезда, остановившегося на перегоне: Во всех случаях немедленно должно быть ограждено место препятствия для движения поездов на смежном пути двухпутного...

Устройство и оснащение процедурного кабинета: Решающая роль в обеспечении правильного лечения пациентов отводится процедурной медсестре...

Интересное:

Национальное богатство страны и его составляющие: для оценки элементов национального богатства используются...

Влияние предпринимательской среды на эффективное функционирование предприятия: Предпринимательская среда – это совокупность внешних и внутренних факторов, оказывающих влияние на функционирование фирмы...

Средства для ингаляционного наркоза: Наркоз наступает в результате вдыхания (ингаляции) средств, которое осуществляют или с помощью маски...

Дисциплины:

|

из

5.00

|

Заказать работу |

|

|

|

|

Михаил Боде Анар Бабаев Николай Евдокимов Алексей Штарев Евгений Костин

Раскрутка: секреты эффективного продвижения сайтов

«Раскрутка: секреты эффективного продвижения сайтов»: Питер; СПб; 2013

ISBN 978-5-496-00600-2

Аннотация

Издание представляет собой самое полное и подробное руководство по поисковой оптимизации (SEO) от практикующих специалистов данной области.

Из книги вы узнаете основы SEO – алгоритмы, цели, принципы, особенности оптимизации. Отдельные главы посвящены специалистам, всем, кто желает построить собственную компанию и организовать SEO-бизнес, а также клиентам, использующим данный вид сервиса.

В приведенных интервью своим опытом делятся известные в интернет-сфере личности, эксперты в области SEO: Сергей Людкевич (Корпорация РБС), Алексей Жуков (UnMedia), Илья Зябрев (AlterTrader Research Ltd.), Роман Клевцов (Optimism), Елизавета Трибунская (SearchEngines.ru), Леонид Гроховский (ТопЭксперт).

Издание адресовано всем, кто начинает постигать основы поисковой оптимизации, и специалистам, желающим повысить свой профессиональный уровень благодаря практическому опыту авторов и приведенным рекомендациям от ведущих российских компаний по разработке интернет-решений.

12+ (В соответствии с Федеральным законом от 29 декабря 2010 г. № 436-ФЗ.)

Бабаев А., Евдокимов Н., Боде М., Костин Е., Штарев А

Раскрутка: секреты эффективного продвижения сайтов

Вводная

♦ Эволюция факторов ранжирования поисковых систем

♦ Слагаемые бюджета на SEO

Эволюция факторов ранжирования поисковых систем

Несмотря на сделанные еще в 1960-1970-х предсказания фантастов, лет двадцать – двадцать пять назад мало кто догадывался, что вскоре для поиска любой информации миллионы людей будут обращаться к Глобальной cети. Трудно вообразить, что когда-то Интернет был «исхоженным» вдоль и поперек – не миллионы, а жалкие десятки разрозненных сайтов, которым не приходилось бороться за высокие позиции в поисковой выдаче (она же по-английски Search Engine Results Page, SERP). Да и первые алгоритмы поиска были простыми как колесо: релевантными признавались те ресурсы, на страницах которых содержался поисковый запрос. Сама выдача была ожидаемо куцей.

|

|

Однако грибница Интернета расползлась по миру, и по мере того, как ширился Веб, множились и сайты в нем. Чтобы не сдуться при этом масштабировании, поисковым системам потребовалось изменить подход к ранжированию ресурсов и взяться за разработку гораздо более сложных алгоритмов.

Внутренние факторы

В 1994 году увидела свет первая полнотекстовая поисковая система под названием WebCrawler. Произошла революция: ранее информация в Сети структурировалась исключительно в виде каталогов ссылок, сгруппированных по тематическому признаку. Следом на орбиту большого поиска вышли Lycos и AltaVista. Это были первые попытки организовать доступ к ресурсам Веба не на основе каталогизации. До наших дней дошли только упоминания о тех поисковых системах, хотя многие из нас застали их на закате славы.

В 1997 году практически одновременно на двух разных континентах зародились гиганты современного поиска – Google и «Яндекс». Их алгоритмы ранжирования, со скидкой на локальные особенности, развивались в одном русле. Стремительные изменения в качестве поисковой выдачи требовали принятия решительных мер ради выполнения единой миссии – предлагать пользователям релевантные их запросу, предельно качественные и полезные ресурсы.

Львиная доля сайтов на рубеже тысячелетий была по сегодняшним меркам примитивна, их страницы отличались незамысловатым дизайном и длинными «портянками» текстов с высокой плотностью ключевых слов. Благодаря нескольким наивным, на наш взгляд, приемам они могли продвигаться вверх в выдаче и добиваться лояльности со стороны поисковиков. В частности, большое значение для выхода в топ имело использование ключевых слов в метатегах. Один из них, keywords, ранее предназначался исключительно для того, чтобы передать информацию поисковому роботу. Он больше не играет ведущей роли в ранжировании, и даже оставить его незаполненным не будет страшным грехом.

|

|

Со временем подтвердилось, что мало учитывать лишь эти внутренние факторы, отводя сайту подобающее ему место в SERP. К внутренней оптимизации страниц предъявлялись все более высокие требования. Поисковики усложняли свои алгоритмы и объявляли войну некачественному и неуникальному контенту, скрытому тексту и многим другим нарушениям со стороны сайтостроителей, пытающихся обмануть, с одной стороны, поисковую машину, с другой – пользователей.

На текущий момент в связи с увеличением «удельного веса» внутренних факторов сложился целый свод писаных и неписаных требований к оптимизации, без соблюдения которых дорога в «высшее общество» – в топ – закрыта. И наоборот, отдельные факторы, которые ранее вершили судьбы сайтов (как то: метатеги, «тошнота», большие тексты, схемы перелинковки), утрачивают актуальность. Таким образом, если первые алгоритмы поисковых машин анализировали лишь релевантность ресурса запросу, то в настоящее время важнее его качество и полезность для посетителей.

Внешние факторы

Внутренняя оптимизация сайта – вотчина его владельца или администратора. Неудивительно, что веб-мастера из числа – выразимся иносказательно – «моральных релятивистов» научились оперировать не совсем честными методами и выдавать порой некачественные страницы за релевантные поисковому запросу. Так было до 1998 года, пока в Google не сошлись на том, что необходимо ввести новые факторы, которые бы не зависели напрямую от действий оптимизатора и позволяли объективнее судить о качестве сайта.

Вскоре вступили в силу внешние ссылочные факторы, призванные определять популярность ресурса в Сети, которая выражалась в количестве других сайтов, ссылающихся на него. Иначе говоря, к текстовой добавилась ссылочная релевантность. Оценка внешних факторов являлась дополнительным критерием отсева, благодаря которому в выдаче оседали действительно хорошо сделанные и интересные людям сайты. Но к тому моменту маховик интернет-бизнеса раскрутился и SEO[1] из боязни упущенной выгоды ответило на действие противодействием. Ввод ссылочного ранжирования повлек за собой всплеск ссылочного спама. Оказалось, что манипуляции подвержены не только внутренние, но и внешние факторы. Сетки сателлитов (вспомогательных, сопутствующих сайтов, предназначенных лишь для улучшения позиций главного) прекрасно «пускали пыль в глаза» поисковикам, убеждая их в авторитетности сайта, а выдача все больше засорялась шлак-ресурсами. Так аферисты внедряются в бомонд, и если в него проникает слишком много пройдох и пустышек, то бомонд превращается в лучшем случае в полусвет. Поисковики парировали «мусорную атаку».

|

|

Впоследствии алгоритмы ссылочного ранжирования становились все более сложными, на службу борьбы с искусственной накруткой ссылочных метрик были поставлены многочисленные фильтры. Именно в ту пору за SEO закрепилась сомнительная слава грязного трюкачества, с помощью которого удается обхитрить поисковые алгоритмы. Как внешние, так и внутренние факторы ранжирования требовали все более глубокого анализа сайта и внешней ссылочной массы. Оценке подвергались технические характеристики ресурса, его возраст, контент и качество ссылающихся на него сайтов-доноров. Было введено такое понятие, как TrustRank (называемый также трастом) – показатель доверия поисковиков к площадке. Не заслуживший траста сайт имел минимальные шансы подняться вверх в выдаче и занять желаемые места в топе.

Благодаря многочисленным ссылочным биржам веб-мастер сегодня все же способен самостоятельно влиять на внешние факторы. Но закупка ссылок требует внимательного и взвешенного подхода. Неверная стратегия ссылочного продвижения лишь навредит ресурсу. На помощь оптимизаторам и сайтовладельцам в наши дни приходят «умные» сервисы, которые максимально эффективно и безопасно, работая с внутренними и внешними факторами, обеспечивают подъем ресурса в топ поисковой выдачи. Одним из таких сервисов, самым крупным на российском рынке автоматизированной поисковой оптимизации, является SeoPult (http://seopult.ru/).

|

|

Поведенческие факторы

Анализ поведения пользователей явился следующей ступенью в развитии поисковых алгоритмов. Он был призван кардинально повысить качество выдачи и помочь в борьбе с поисковым спамом. Поведенческие факторы – если не совершенное оружие в арсенале поисковых систем, то, во всяком случае, мощное: на них трудно воздействовать искусственными методами. Если пользователи сходным образом реагируют на тот или иной сайт, с высокой степенью вероятности это говорит о том, отвечает ли он их ожиданиям. И дело не только в кликабельности, которая якобы поддается накрутке.

Поведенческие факторы – это широкий комплекс пользовательских действий, учитываемых и интерпретируемых поисковыми алгоритмами. «Яндекс» возлагает выполнение столь деликатной миссии на плечи «оценщиков»-асессоров и на технологию машинного обучения MatrixNet. Изначально, когда поведенческие факторы обрабатывались по иному принципу, наблюдения за активностью посетителей зачастую трактовались ошибочно. Само собой, глубина просмотра туристического портала с увлекательными статьями о путешествиях будет не такой, как у сайта службы такси. Поведенческие факторы разнятся в зависимости от тематики и типа сайта. Введением технологии MatrixNet проблема была решена. Ресурсы были разбиты на группы и проходили проверку по формализованному набору параметров и общему впечатлению асессоров.

Таким образом, прежние методы «черной» оптимизации утратили силу, так как низкосортные ресурсы были не в состоянии конкурировать в топе с «человеколюбивыми» и качественными. Влиять напрямую на поведенческие факторы невозможно, но косвенно – вполне. Самое главное, сайт должен быть качественным и полезным для пользователей. Уникальный тематический контент, грамотное юзабилити, продуманный дизайн, привлекательный сниппет (подробнее о сниппетах читайте в разделе «Оптимизация сниппетов» главы «SEO-практикум»), бесперебойная работа сайта – все это в руках веб-мастера. Подчиняясь этим требованиям, владелец площадки создает благоприятные условия для ее посетителей, а уж их удовлетворенность сайтом поисковая система не преминет зафиксировать и перевести на язык цифр, которые определяют позиции в топе.

Новые факторы

Стремительное развитие электронной коммерции и высокий спрос на товары и услуги в Интернете отразились на факторах ранжирования. Специально для интернет-магазинов «Яндекс» внедрил коммерческий алгоритм ранжирования, поскольку применительно к сайтам такого типа важно учитывать совсем не такие характеристики, как, например, в случае с новостными или информационными порталами.

|

|

С точки зрения «Яндекса», для качественного коммерческого сайта имеют большое значение такие факторы, как четкое указание цены товара или услуги, широта ассортимента, недвусмысленное описание условий доставки, корректность контактной информации с использованием карт. Учитывается также наличие отзывов и комментариев пользователей, оставляемых в сервисе «Яндекс.Маркет» или на других сайтах с рейтингами компаний, а также в социальных сетях. По количеству и характеру отзывов поисковик судит о качестве оказываемых услуг и уровне обслуживания покупателей. Если на компанию подозрительно часто жалуются, это, скорее всего, ударит по позициям ее интернет-магазина в SERP.

Известность компании – это еще один коммерческий фактор, влияющий на ранжирование. Частые запросы к поисковику, связанные с сайтом конкретной компании, свидетельствуют о ее популярности, а значит, такому ресурсу «больше веры».

В особую категорию выделяются социальные факторы ранжирования. Базовое правило работы с ними элементарно: ни в коем случае не следует пренебрегать инструментами социального маркетинга для нужд SEO. Самая популярная в Рунете социальная сеть «ВКонтакте» имеет ежедневную аудиторию более 40 млн человек. Поисковые системы придают информации в социальных сетях большое значение и учитывают в ранжировании ряд социальных факторов.

Во-первых, поисковый робот учитывает в социальных сетях внешние ссылки. Во-вторых, наряду со ссылками рассматривается активность пользователей в официальных группах, имеющих отношение к сайту. В группе кипит жизнь, в ней много участников (не ботов)? Поисковый робот констатирует: «Учтем». В-третьих, приветствуется наличие на сайте социальных кнопок, в том числе Like («Мне нравится») на странице рядом со статьей, обзором, описанием товара и другим контентом, который может оценить пользователь. Каждый «лайк» сигнализирует поисковику о том, что страница нравится посетителям и заслуживает более высокого места в топе.

В полном соответствии с исторической наукой алгоритмы поисковых систем становятся все более многогранными, факторы ранжирования сегодня разносторонне учитывают множество аспектов продвигаемого ресурса. По мере развития Глобальной сети рождаются тренды, которые не остаются без внимания поисковых систем, и, что логично, в игру вступают новые факторы, влияющие на ранжирование. Зато у владельца сайта, в отличие от ситуации десяти-пятнадцатилетней давности, есть незыблемые ориентиры: думать об удобстве и качестве проекта, думать о посетителе, да и просто – думать. Возможно, то, что не учитывается сегодня, будет важным фактором завтра. Например, почему бы, помимо формальных признаков картинки, не учитывать, кривые ли руки у фотографа, снимавшего товар для интернет-магазина. Глядишь, «Яндекс» назовет это «фактором божьей искры». Но догадки догадками, шутки шутками, а здравый смысл подчас помогает предвосхитить будущее поисковой оптимизации лучше, чем бурная фантазия.

Слагаемые бюджета на SEO

Современное SEO – не шаманство, а комплекс рациональных мер, вписанный в сферу цивилизованного интернет-маркетинга: кампания дробится на этапы, каждый – с конкретными задачами и KPI[2]. Однако в большинстве случаев, кто бы ни брался за раскрутку сайта – агентство или оптимизатор-одиночка, – заказчик редко получает подробный отчет о той или иной статье расходов. Гораздо прозрачнее SEO выглядит при использовании автоматизированных сервисов поискового продвижения. В системе SeoPult финансовая составляющая рекламной кампании и вовсе разложена по полочкам – с первого взгляда видно, какие суммы уходят на покупку ссылок. Но ссылки – это далеко не единственная часть поисковой оптимизации. Финансовых вложений требуют и иные меры, без принятия которых до попадания в топ будет как до Антарктиды на самокате. Так что владельцу сайта лучше заранее разведать, сколько денег может быть потрачено из бюджета на продвижение и на какие именно задачи.

Внутренняя оптимизация

Работа с внутренними факторами – хронологически приоритетная и чрезвычайно важная часть поискового продвижения. Перед тем как начать покупать ссылки, необходимо провести скрупулезный аудит сайта на предмет его корректности с точки зрения SEO. Полноформатная ревизия предполагает проверку HTML-кода, файла robots.txt, настроек CMS (системы управления контентом), наличия дублей страниц и других технических деталей. Обязательный пункт подготовки – оптимизация контента, проверка текстов на уникальность и защита авторства материалов. Мало того, что тексты должны иметь оптимальный процент вхождения ключевых слов, необходимо проанализировать их структуру и форматирование: использование заголовков и подзаголовков, абзацев, списков и т. д. Не забывайте и о правильной внутренней перелинковке. Она служит как для удобства пользователей, так и для передачи веса между страницами сайта. Все недочеты, выявленные аудитом, должны быть устранены, иначе зачем он нужен?

Внутренняя оптимизация сайта – это еще и «рихтовка» каждой посадочной страницы в отдельности. Это титаническая работа, с которой сам владелец ресурса полностью едва ли справится, если только он не супергерой – разработчик, интернет-маркетолог и оптимизатор в одном лице, не разменивающийся на такие мелочи, как сон. Но, скорее всего, придется прибегнуть к помощи специалистов, которые подготовят сайт к продвижению, и оплатить их услуги. Лучше не жадничать, потому что вложения окупятся сторицей: будучи грамотно оптимизированным, ресурс позволяет сократить траты на SEO в дальнейшем. Начинать оптимизацию с покупки ссылок – все равно что абы с кем выходить в открытое море на яхте, состояния которой вы себе не представляете. Любая серьезная внештатная ситуация в сотнях километров от береговой линии – огромный риск, равно как и «плавание» по выдаче «Яндекса» в опасной близости от поисковых фильтров. А ведь еще поди пойми, с чем беда – со штаг-юферсом или спинакер-фалом, если ты не готовил судно к плаванию. «Хорошую ж яхту купил! Белую такую…» – разведет руками незадачливый «мореход». Сайт тоже, бывает, выглядит в глазах его хозяина «белым» и непотопляемым. До первого серьезного волнения в топе.

Покупка ссылок

Стоимость ссылочного продвижения напрямую зависит от конкурентности и частотности запросов, под которые оптимизируется каждая конкретная страница сайта. На стадии формирования семантического ядра нужно понимать, что высокочастотные запросы обойдутся куда дороже, чем низкочастотные. Далее, цена ссылок зависит от того, сколько и на что тратят ваши конкуренты. Прежде чем назначить цену на ту или иную ссылку, нужно провести анализ конкурентной среды. Это трудозатратно и увеличивает расходы на кампанию, если заказывать ее в агентстве.

В SeoPult, однако, нет необходимости в монотонной ручной работе по подбору ключевых слов, анализу конкурентов и высчитыванию оптимального бюджета. Автоматизация перечисленных процессов снижает затраты владельца сайта на продвижение и дает ему четкую картину расходов на закупку ссылок. Следует заметить, что SeoPult лишь вспомогательное звено в продвижении: система дает рекомендации относительно затрат на ссылки, анализируя конкурирующие сайты. Однако клиент всегда вправе перейти на «ручное управление», если чувствует такую необходимость.

Заказ контента

Content is king[3]. А на престоле немыслим самозванец, не скрывающий своего сомнительного статуса. И взбунтуется народ, и исполнятся гневом посетители, и прахом пойдут поведенческие факторы. Да и «Яндекс» вмешается в эти «игры престолов» и загонит площадку под плинтус. То бишь на периферию выдачи, куда не ступала нога ищущего.

Как осетрина бывает только первой свежести, так и контент должен быть уникальным и тематическим – и никаким другим. Хотите высоких позиций и высокой конверсии? Напишите в бюджете большими буквами: «Заказ текстов». Связывать слова в предложения, а предложения в абзацы можно самому, были бы талант да навык, но это обычно нерационально: владельцу сайта придется потратить сотни часов на одни лишь тексты. Распространенная практика – заказывать контент на текстовых биржах или у копирайтеров-фрилансеров. Зачастую на биржах выходит дешевле и безопаснее, причем они несут прямую ответственность за действия своих сотрудников и следят за сроками выполнения задач.

К контенту относятся и графические материалы. Коммерческой площадке важно не только описать, но и показать товар. Заимствовать изображения у конкурентов категорически противопоказано, равно как и использовать чужие статьи. Поисковые алгоритмы идентифицируют картинку-дубль в два счета. Оптимальный вариант – сделать качественные, детальные снимки товара, демонстрирующие все его характерные особенности. На съемку придется потратиться, зато ваши собственные, ниоткуда не скопированные фотографии послужат заделом на будущее и предотвратят досадные эксцессы с поисковыми системами.

Еще одна, часто игнорируемая, ипостась контента – комментарии. Их наличие на страницах сайта определенно приветствуется. «Живой» сайт милее поисковым системам, да и люди охотнее пользуются им, если видят активность со стороны других его посетителей. Комментарии и отзывы достаются владельцам площадок, как правило, бесплатно, но, если проявить смекалку и дать клиентам небольшой бонус за отклик о проекте или о продукте, можно получить в разы больше пользовательского контента.

Работа специалистов

Созданием и продвижением сайта обычно занимается несколько человек, и каждый рассчитывает получить вознаграждение за свой труд. Команда может включать верстальщика, программиста, дизайнера, маркетолога, оптимизатора, линк-менеджера, копирайтера, контент-менеджера и т. д. Нередко ввиду скромного бюджета к работе над проектом привлекаются всего два-три специалиста, которые обладают разносторонними навыками. Расценки у каждого свои и зависят от множества критериев, включая квалификацию, опыт, сложность задач и, с позволения сказать, «повышающий коэффициент за простодушие заказчика». В случае SEO выделяются два базовых варианта – расчет с оптимизатором-фрилансером по договору и оплата счета, выставленного агентством. Ни «ремесленник-одиночка», ни солидная контора полной гарантии выхода в топ не даст, но, само собой, каждый хочет получить денежную компенсацию за выполненную работу. А уж поручать ли внутреннюю и внешнюю оптимизацию сайта SEO-компании или же пытаться действовать самостоятельно с помощью системы автоматизированного продвижения и веб-мастера – решать владельцу ресурса.

Бюджет на продвижение не константа. Иногда что-то из него допустимо исключить, а что-то уместно добавить. Необходимо подходить к его оценке взвешенно, четко понимая, какие цели поставлены и каких результатов нужно достичь. Стратегию каждый выбирает для себя: гнаться ли за конкурентами и тратить не меньше, чем они, или же достаточно поначалу выбирать менее конкурентные фразы и постепенно наращивать позиции в топе. Далеко не всегда большой бюджет означает мгновенный успех. И лить воду на SEO-мельницу надо осторожно, чтобы не снести плотину

SEO-практикум

♦ Работа над уникальностью контента на сайте

♦ Оптимизация в стратосфере Рунета

♦ Икроножное SEO: оптимизаторские финты для интернет-изданий

♦ SeoPult: приборы, карты, фигуры пилотажа

♦ Трастовость сайта

♦ АГС, горе от ума и парадоксы современного SEO

♦ Особенности продвижения интернет-магазина

♦ Поведенческие факторы ранжирования

♦ Оптимизация сниппетов

♦ Продвижение в «Яндекс.Картинках»

♦ Продвижение через поисковые подсказки

♦ Выбор домена и хостинга

♦ Проверка уникальности контента методом шинглов

♦ Семантическая разметка страниц

♦ Трафиковое продвижение

♦ Зеркала и склейка

♦ Особенности продвижения молодого сайта

♦ Региональное продвижение: места силы

♦ Аффилиаты: сидя на двух стульях

♦ Продвижение аффилированных интернет-магазинов

♦ Создание эффективной посадочной страницы

♦ Возможности HTML5 при оптимизации

♦ Особенности мобильных версий сайтов

Трастовость сайта

В число важнейших факторов ранжирования входит такой показатель сайта, как трастовость, именуемый также TrustRank, или просто траст. Представители поисковых систем настаивают на том, что траст – понятие относительное и не выражается количественно для каждого отдельно взятого сайта. Нам же как практикам важно одно: траст существует, он более чем реален и участвует в ранжировании. А значит, было бы непростительной ошибкой закрывать на него глаза в процессе поискового продвижения. Суслика никто не видит, но он действительно есть, и огромный.

Что такое TrustRank

Первое упоминание о трасте датируется 2004 годом. Это понятие фигурировало в совместном труде сотрудников Стэнфордского университета и компании Yahoo! под названием «Борьба с веб-спамом с помощью TrustRank». Согласно содержанию работы, TrustRank отводится важная роль в искоренении искусственной накрутки авторитетности ресурсов. Ключевые моменты влияния траста на качество выдачи таковы.

1. Наличие лишь одного метода определения авторитетности сайта, а именно PageRank, на руку любителям «черной» оптимизации. Один из их методов базируется на создании множества грамотных перелинковок между сайтами с нулевым весом, которые образуют сетку сателлитов. Благодаря накрутке реципиент получает приличный вес и вместе с ним статус авторитетного ресурса.

2. Во избежание глобальной несправедливости и ради устранения спама из выдачи и вводится TrustRank. Таким образом, при передаче PageRank от донора к реципиенту посредством обратных ссылок учитывается некий «особый вес», исходящий только от качественных, крупных, известных, прошедших ручную проверку ресурсов. Трастовый сайт не станет ссылаться на низкосортный ресурс с псевдоуникальным контентом. Это обстоятельство призвано подтолкнуть оптимизаторов и разработчиков к созданию предназначенных для людей сайтов с интересным контентом.

В сущности, траст напоминает переменную, без которой невозможно решить уравнение. Значение траста нельзя зафиксировать, но без него у сайта падают шансы на долговременное попадание в топ по высококонкурентным запросам. Вместе с тем все ресурсы Сети не могут обладать большим TrustRank. Это привело бы к хаосу в поисковой выдаче, так как определить сайты, наиболее релевантные запросу, было бы проблематично.

Благодаря трасту сайт котируется поисковыми системами выше, чем если бы не имел его, но залогом успеха в продвижении по-прежнему остаются уникальный тематический контент, безупречная внутренняя оптимизация и максимально приближенная к естественной внешняя ссылочная масса, стабильная и разнородная.

TrustRank присваивается домену в целом по аналогии с тИЦ, и делается это двумя способами. Во-первых, посредством ручной проверки сайта асессорами, во-вторых, в автоматическом режиме на основании ряда факторов, отражающих качество ресурса. Оценки в первом и втором случаях могут не совпадать: порой при незначительном трасте, определенном автоматически, выставленный вручную балл оказывается на порядок выше.

Способы увеличения траста

Наряду с поднятием «пузомерок» (в частности, PR и тИЦ) увеличение траста сайта – ежедневная забота оптимизатора. Пусть траст – величина, не поддающаяся измерению, но ее можно преумножить. Получение даже небольшого TrustRank серьезно повышает шансы ресурса на то, чтобы продвинуться в топ по ключевым запросам. Процесс приобретения траста имеет две составляющие.

1. Работа над внутренней оптимизацией сайта. Качество внутренней оптимизации явным образом влияет на присвоение траста.

2. Приобретение ссылок с трастовых ресурсов. Наличие у площадки даже небольшого количества покупных ссылок с авторитетных ресурсов повышает эффективность ссылочного продвижения в целом.

Работа с сайтом

Оптимизаторы носили бы на руках того, кто предоставил бы им подробный достоверный список факторов, которые принимает во внимание поисковая система при назначении уровня траста ресурсу. Также тайной за семью печатями остаются алгоритмы вычисления траста, которые вдобавок регулярно меняются. В частности, «Яндекс», поставив себе на службу систему машинного обучения MatrixNet, ускорил внедрение изменений.

Опытным путем SEO-эксперты все же составили перечень наиболее важных факторов, влияющих на получение TrustRank. Легко заметить, что многие из них схожи с критериями выставления тИЦ, вИЦ («взвешенный индекс цитирования» в терминологии «Яндекса») и PR. Перечислим наиболее важные.

1. Необходим качественный контент – уникальный и тематический. Сайту с заимствованным контентом странно рассчитывать на доверие поисковиков. Все тексты должны быть объединены общей тематикой, или, по-умному, обязательно присутствие сквозного семантического кластера. Сайту о ремонте жилых помещений с дельными статьями легче заслужить доверие, чем псевдоэнциклопедии, страницы которой забиты всякой всячиной, мало интересующей пользователей.

Немаловажны с точки зрения присвоения траста страницы с контактными данными, информацией о компании. Очевидно, что эти сведения должны быть реальными. В противном случае оценка асессоров будет заведомо отрицательной.

2. Возраст домена и сайта напрямую влияют на присвоение траста. Молодой сайт лишен шансов быстро удостоиться TrustRank. Поисковики прибегают к таким ограничениям ради борьбы с сателлитами и дорвеями, которые с первых дней жизни способны засорить поисковую выдачу. Стоит отметить, что возраст сайта для поисковика отсчитывается не с даты регистрации домена, а с момента первой индексации его поисковым роботом.

3. Качество хостинга играет не последнюю роль в оценке сайта. Учитывается бесперебойная работа сервера, отсутствие ошибок в его настройке, скорость загрузки страниц сайта, история IP-адреса. Если на IP ранее был размещен вредоносный ресурс, нарушавший правила поисковых систем, вероятно понижение траста у продвигаемого ресурса.

4. Дизайн сайта, претендующего на хороший траст, не должен быть шаблонным. Если в коде встречаются фрагменты, которые используются и на других сайтах, они могут быть идентифицированы как дублированный контент. Да и асессоры оценят шаблонный дизайн невысоко.

5. Вредоносный код несовместим с трастом. Следует тщательно проверить сайт и убедиться в отсутствии вирусов на нем.

6. Спам на сайте недопустим. Необходимо проверять комментарии, сообщения форума и своевременно удалять все похожее на спам.

7. Стабильный трафик свидетельствует о востребованности сайта. Регулярная посещаемость и естественный, постепенный прирост аудитории – прямой путь к набору траста. Резкие скачки или падение трафика с высокой степенью вероятности приведут к понижению TrustRank.

8. Кликабельность сниппетов демонстрирует интерес пользователей к продвигаемому ресурсу. Привлекательный сниппет приближает сайт к получению заветного траста.

9. Время нахождения на площадке – один из поведенческих факторов, которые также влияют на доверие к ней со стороны поисковых систем. Данные о длительности пребывания пользователей на сайте «Яндекс», в частности, получает посредством установленного на сайте счетчика «Яндекс.Метрика». Слишком быстрый переход посетителей со страниц свидетельствует о низком качестве контента.

10. Присутствие в крупных «белых» каталогах, а именно в «Яндекс.Каталоге» и DMOZ, повышает траст сайта в «Яндексе» и Google.

11. Использование ключевых слов в домене в некоторой степени также работает на присвоение траста. По возможности домен должен быть лаконичным и характеризовать тематику ресурса. Слишком длинные домены с нагромождением ключевых запросов в URL характерны для спам-сайтов. Им поисковики не доверяют и принимают против них защитные меры.

12. Количество страниц в индексе также учитывается при оценке ресурса. Поисковики больше доверяют крупным сайтам, у которых в индекс попало большое количество страниц с качественным контентом. Маленькие площадки имеют право на существование и способны попасть в топ, однако траста им достанется гораздо меньше.

13. Сайт тем больше нравится поисковикам, чем чаще обновляется его содержание. Не обязательно каждый день добавлять уникальные статьи, достаточно систематически проводить работу с контентом, тем самым показывая, что сайт живет и развивается. Полезно использовать такие фишки, как RSS-ленты и XML-sitemap.

Этот внушительный список отражает требования к внутренним факторам сайта. Не менее важны и внешние.

Место не для каждого

Позиция вверху SERP гарантирует площадке поток целевых посетителей, но не каждому проекту имеет смысл тратить бюджет на продвижение с целью занять первые места в поисковой выдаче. Каким же сайтам нет резона метить в топ и почему?

1. Только что «сошедший со стапелей» коммерческий сайт имеет минимум шансов попасть в топ. Поисковики проявляют осторожность по отношению к молодым ресурсам и не спешат им доверять. Даже если сайт прошел безупречную внутреннюю оптимизацию, потребуются месяцы, прежде чем ему можно будет «разевать рот» на траст «Яндекса» и выход на высокие позиции в выдаче по основным запросам.

Правильнее начинать продвижение новой площадки с запуска кампании по контекстной рекламе и с присоединения к «Яндекс.Маркету». Параллельно следует осуществлять продвижение по НЧ-запросам, избегая резкого прироста ссылочной массы. Через год впору будет бороться за высокие места в выдаче по СЧ– и ВЧ-запросам (средне– и высокочастотным).

2. Многие категории товаров затруднительно продавать дистанционно. Так, не каждый пользователь решится приобрести джинсы без примерки. Поэтому маленьким интернет-магазинам с ассортиментом такого рода невыгодно удерживаться в топе ввиду крайне низкой конверсии, в отличие от крупных проектов типа Wildberries.ru и Sapato.ru, чья аудитория несопоставимо больше.

3. Нерентабельно заниматься в Интернете продажей очень дешевых и притом неуникальных товаров. Потребуются большие, приближенные к опту объемы заказов, чтобы работать не в убыток себе. Да и редкий житель России согласится заплатить за доставку почти столько, сколько стоит сам товар. Поэтому конверсия «ширпотребных» площадок оставляет желать лучшего.

На первом этапе организации собственного бизнеса в e-commerce необходимо провести серьезный анализ выбранной ниши, изучить конкурентов, понять, стоит ли дальше двигаться в эту сторону, а следовательно, прибегать к продвижению торговой площадки с помощью SEO.

Стратегия продвижения

План выведения интернет-магазина в топ включает в себя перечисленные ниже пункты:

• подбор запросов, составление семантического ядра;

• размещение ключевых запросов на релевантных страницах, создание недостающих страниц под другие запросы;

• внутренняя оптимизация страниц;

• запуск SEO-кампании по НЧ-запросам;

• постепенное подключение к продвижению СЧ-запросов;

• распределение бюджета в пользу СЧ-запросов;

• ввод в стратегию ВЧ-запросов с целью получения максимального трафика.

Подготовительные работы

Перед запуском SEO-кампании следует проверить техническую сторону сайта. На это может уйти немало времени и средств, так как коммерческий ресурс содержит великое множество страниц, каждая из которых должна функционировать безупречно. Технический аудит заключается в проверке работы сервера, тестировании площадки на устойчивость к высоким нагрузкам, корректной настройке CMS с точки зрения SEO, проверке валидности кода. Огрехи и недоработки обязательно должны быть устранены, прежде чем состоится первое «знакомство» сайта с поисковиком.

Получение траста

Наличие траста не менее важно для хорошего интернет-магазина, чем для любого другого качественного ресурса. Чтобы получить несколько «жирных» трастовых ссылок, владельцу ресурса предстоит обратиться не к чистому SEO, а скорее к комплексному интернет-маркетингу. Вот что стоит предпринять для завоевания звания авторитетного сайта:

• добиться статуса официального торгового представителя некоей марки и получить обратную ссылку с сайта производителя;

• провести работу с ведущими блогерами в своей отрасли и договориться о размещении ссылок у них;

• регулярно заявлять о себе статьями и пресс-релизами на крупных профильных порталах;

• будоражить общественность и создавать инфоповод

|

|

|

Наброски и зарисовки растений, плодов, цветов: Освоить конструктивное построение структуры дерева через зарисовки отдельных деревьев, группы деревьев...

Опора деревянной одностоечной и способы укрепление угловых опор: Опоры ВЛ - конструкции, предназначенные для поддерживания проводов на необходимой высоте над землей, водой...

Общие условия выбора системы дренажа: Система дренажа выбирается в зависимости от характера защищаемого...

Автоматическое растормаживание колес: Тормозные устройства колес предназначены для уменьшения длины пробега и улучшения маневрирования ВС при...

© cyberpedia.su 2017-2024 - Не является автором материалов. Исключительное право сохранено за автором текста.

Если вы не хотите, чтобы данный материал был у нас на сайте, перейдите по ссылке: Нарушение авторских прав. Мы поможем в написании вашей работы!