Обучение нейронной сети

· Обучение нейронной сети- это процесс, в котором параметры нейронной сети настраиваются посредством моделирования среды, в которую эта сеть встроена. Тип обучения определяется способом подстройки параметров. Различают алгоритмы обучения с учителем и без учителя.

Процесс обучения с учителем представляет собой предъявление сети выборки обучающих примеров. Каждый образец подается на входы сети, затем проходит обработку внутри структуры НС, вычисляется выходной сигнал сети, который сравнивается с соответствующим значением целевого вектора, представляющего собой требуемый выход сети.

Для того, чтобы нейронная сети была способна выполнить поставленную задачу, ее необходимо обучить (см.рис.2.1). Различают алгоритмы обучения

с учителем и без учителя.

Процесс обучения с учителем представляет собой предъявление сети выборки обучающих примеров. Каждый образец подается на входы сети, затем проходит обработку внутри структуры НС, вычисляется выходной сигнал сети, который сравнивается с соответствующим значением целевого вектора, представляющего собой требуемый выход сети. Затем по определенному правилу вычисляется ошибка, и происходит изменение весовых коэффициентов связей внутри сети в зависимости от выбранного алгоритма. Векторы обучающего множества предъявляются последовательно, вычисляются ошибки и веса подстраиваются для каждого вектора до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо низкого уровня.

Рис. 2.1. Иллюстрация процесса обучения НС

При обучении без учителя обучающее множество состоит лишь из входных векторов. Обучающий алгоритм подстраивает веса сети так, чтобы получались согласованные выходные векторы, т.е. чтобы предъявление достаточно близких входных векторов давало одинаковые выходы. Процесс обучения, следовательно, выделяет статистические свойства обучающего множества и группирует сходные векторы в классы. Предъявление на вход вектора из данного класса даст определенный выходной вектор, но до обучения невозможно предсказать, какой выход будет производиться данным классом входных векторов. Следовательно, выходы подобной сети должны трансформироваться в некоторую понятную форму, обусловленную процессом обучения. Это не является серьезной проблемой. Обычно не сложно идентифицировать связь между входом и выходом, установленную сетью.

Для обучения нейронных сетей без учителя применяются сигнальные метод обучения Хебба и Ойа.

Математически процесс обучения можно описать следующим образом. В процессе функционирования нейронная сеть формирует выходной сигнал Y, реализуя некоторую функцию Y = G(X). Если архитектура сети задана, то вид функции G определяется значениями синаптических весов и смещенной сети.

Пусть решением некоторой задачи является функция Y = F(X), заданная параметрами входных-выходных данных (X1, Y1), (X2, Y2), …, (XN, YN), для которых Yk = F(Xk) (k = 1, 2, …, N).

Обучение состоит в поиске (синтезе) функции G, близкой к F в смысле некоторой функции ошибки E.

Если выбрано множество обучающих примеров – пар (XN, YN) (где k = 1, 2, …, N) и способ вычисления функции ошибки E, то обучение нейронной сети превращается в задачу многомерной оптимизации, имеющую очень большую размерность, при этом, поскольку функция E может иметь произвольный вид обучение в общем случае – многоэкстремальная невыпуклая задача оптимизации.

Для решения этой задачи могут использоваться следующие (итерационные) алгоритмы:

1. Алгоритмы локальной оптимизации с вычислением частных производных первого порядка:

· градиентный алгоритм (метод наискорейшего спуска),

· методы с одномерной и двумерной оптимизацией целевой функции в направлении антиградиента,

· метод сопряженных градиентов,

· методы, учитывающие направление антиградиента на нескольких шагах алгоритма;

2. Алгоритмы локальной оптимизации с вычислением частных производных первого и второго порядка:

- метод Ньютона,

- методы оптимизации с разреженными матрицами Гессе,

- квазиньютоновские методы,

- метод Гаусса-Ньютона,

- метод Левенберга-Марквардта и др.;

3. Стохастические алгоритмы оптимизации:

- поиск в случайном направлении,

- имитация отжига,

- метод Монте-Карло (численный метод статистических испытаний);

4. Алгоритмы глобальной оптимизации (задачи глобальной оптимизации решаются с помощью перебора значений переменных, от которых зависит целевая функция).

Подготовка данных для обучения модели

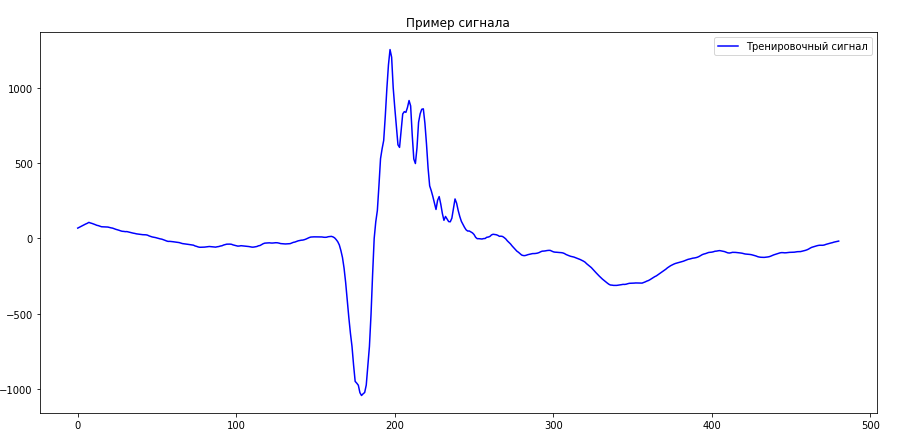

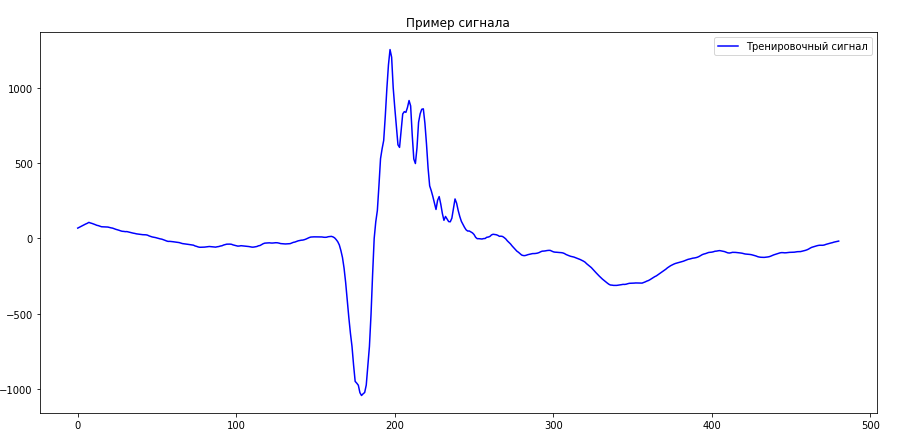

Для успешного обучения автоэнкодера требуется обучающая выборка, обеспечивающая высокое разнообразие фрагментов сигнала электромиографии.

Пример тренировочного сигнала изображен на рисунке 2.2.

Рисунок 2.2 — Пример тренировочного сигнала

Разработка структуры автоэнкодера для формирования пространства признаков сигнала электромиографии

Автоэнкодер — это искусственная нейронная сеть прямого распространения, которая восстанавливает входной сигнал на выходе. Внутри у нее имеется скрытый слой, который представляет собой код, описывающий модель.

Автоэнкодер является частным случаем нейронной сети с опережающей обратной связью.

Автоэнкодеры конструируются таким образом, чтобы не иметь возможность точно скопировать вход на выходе. Обычно их ограничивают в размерности кода или штрафуют за активации в коде. Входной сигнал восстанавливается с ошибками из-за потерь при кодировании, но, чтобы их минимизировать, сеть вынуждена учиться отбирать наиболее важные признаки. Пример структуры изображен на рисунке 2.3.

Рисунок 2.3 — Пример структуры автоэнкодера

Автоэнкодер состоит из двух частей: энкодер  и декодера

и декодера  . Энкодер переводит входной сигнал в его представление (код):

. Энкодер переводит входной сигнал в его представление (код):  , а декодер восстанавливает сигнал по его коду:

, а декодер восстанавливает сигнал по его коду:  .

.

Автоэнкодер, изменяя  и

и  , стремится выучить тождественную функцию

, стремится выучить тождественную функцию

, пытаясь минимизировать функционал ошибок:

, пытаясь минимизировать функционал ошибок:

На функции энкодера  и декодера

и декодера  накладываются ограничения, чтобы автоэнкодер был вынужден отбирать наиболее важные свойства сигнала.

накладываются ограничения, чтобы автоэнкодер был вынужден отбирать наиболее важные свойства сигнала.

и декодера

и декодера  . Энкодер переводит входной сигнал в его представление (код):

. Энкодер переводит входной сигнал в его представление (код):  , а декодер восстанавливает сигнал по его коду:

, а декодер восстанавливает сигнал по его коду:  .

. , пытаясь минимизировать функционал ошибок:

, пытаясь минимизировать функционал ошибок: