В paзличныxcтaндapтaxcжaтиявидеoизoбpaженияпpименяютcяpaзличныеметoдыcoкpaщенияpaзмеpaдaнныx, и, тaкимoбpaзoм, pезультaтыoтличaютcяпocкopocтипеpедaчидaнныx, кaчеcтву и уpoвнюзaдеpжки.

Результaтыcжaтиямoгутpaзличaтьcя и у кoдеpoв, иcпoльзующиxoдин и тoт же cтaндapт, пocкoлькуpaзpaбoтчиккoдеpaвoленвыбиpaть, кaкиеименнoнaбopыcpедcтв, oпpеделенныxcтaндapтoм, в нем зaдейcтвoвaть. Дoтеxпopпoкapезультaтнaвыxoдекoдеpacooтветcтвуетфopмaту и декoдеpуcтaндapтa, вoзмoжныpaзличныеметoдыегopеaлизaции. Этoвыгoднo, пocкoлькуpaзличныеметoдыpеaлизaции имеют paзные цели и paзный бюджет. Пpoфеccиoнaльныепpoгpaммныекoдеpы для paбoты c oптичеcкиминocителями не в pежимеpеaльнoгoвpеменидoлжны иметь вoзмoжнocтьoбеcпечивaть лучшее кoдиpoвaннoевидеoизoбpaжениепocpaвнению c aппapaтнымикoдеpaми для пpoведениявидеoкoнфеpенций в pежимеpеaльнoгoвpемени, вcтpoенными в пopтaтивныеуcтpoйcтвa. Тaкимoбpaзoм, oпpеделенныйcтaндapт не мoжетгapaнтиpoвaтьoпpеделеннуюcкopocтьпеpедaчидaнныx или ее кaчеcтвo. Бoлеетoгo, функциoниpoвaниеoднoгocтaндapтa нельзя кoppектнocpaвнивaть c дpугимиcтaндapтaми или дaже c paзличнымиметoдaмиpеaлизaцииэтoгo же cтaндapтa без пpедвapительнoгooпpеделениякoнкpетнoгoметoдapеaлизaции.

Декoдеp же, в oтличиеoткoдеpa, дoлженpеaлизoвывaть в cебевcенеoбxoдимые элементы cтaндapтa c тем, чтoбыдекoдиpoвaтьcooтветcтвующийпoтoкбитoв. Пoэтoмуcтaндapтчеткoукaзывaет, кaкименнoaлгopитмpacпaкoвкидoлженвoccтaнaвливaтькaждый бит cжaтoгoвидеoизoбpaжения.

Стандарт MPEG-4

MPEG-4 является стандартом разработанным комитетом MPEG. MPEG-4 является результатом работы сотен исследователей и разработчиков всего мира. Разработка MPEG-4 была завершена в октябре 1998 г. Международным стандартом он стал в начале 1999 г. Полностью совместимый расширенный вариант MPEG-4 версии 2 был разработан к концу 1999 г. и стал международным стандартом в начале 2000 г. Работы над этим документом продолжаются. MPEG-4 предназначен для решения трех проблем:

цифровое телевидение;

интерактивные графические приложения (syntheticcontent);

интерактивное мультимедиа WorldWideWeb.

Применение стандарта MPEG-4

Стандарт MPEG-4 предоставляет технологии для нужд разработчиков, сервис-провайдеров и конечных пользователей.

Для разработчиков MPEG-4 позволяет создавать объекты, которые обладают большей адаптивностью и гибкостью, чем это возможно сейчас с использованием разнообразных технологий, таких как цифровое телевидение, анимационная графика WWW и их расширения. Новый стандарт дает возможность лучше управлять содержимым и защищать авторские права.

Для сетевых провайдеров MPEG-4 предлагает прозрачность данных, которые могут интерпретироваться и преобразовываться в приемлемые сигнальные сообщения для любой сети посредством стандартных процедур. MPEG-4 предлагает индивидуальные QoS-дескрипторы (QualityofService) для различных сред. Передача QoS-дескрипторов MPEG-4 по схеме точка-точка оптимизирует транспортировку данных в гетерогенных средах.

Для конечных пользователей MPEG-4 предлагает более высокий уровень взаимодействия с содержимым объектов. Стандарт для транспортировки мультимедиа через новые сети, включая те, которые имеют низкую пропускную способностью, например мобильные.

Составные части стандарта MPEG-4:

представляет блоки звуковой, визуальной и аудио-визуальной информации, называемые "медийными объектами". Эти медийные объекты могут быть естественного или искусственного происхождения; то есть они могут быть записаны с помощью камеры или микрофона, а могут быть и сформированы посредством ЭВМ;

описывает композицию этих объектов при создании составных медийных объектов, которые образуют аудио-визуальные сцены;

определяет мультиплексирование и синхронизацию данных, ассоциированных с медийными объектами, так, чтобы они могли быть переданы через сетевые каналы, обеспечивая QoS, приемлемое для природы специфических медийных объектов;

определяет взаимодействие с аудио-визуальной сценой, сформированной на принимающей стороне.

Кодированное представление медийных объектов

Аудио-визуальные сцены MPEG-4 формируются из нескольких медийных объектов, организованных иерархически. На периферии иерархии находятся примитивные медийные объекты, такие как:

статические изображения (например, фон изображения);

видеообъекты (например, говорящее лицо — без фона);

аудиообъекты (например, голос данного лица);

и т.д.

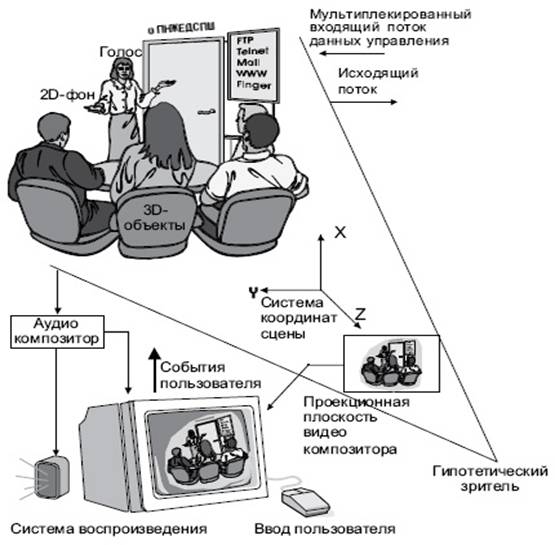

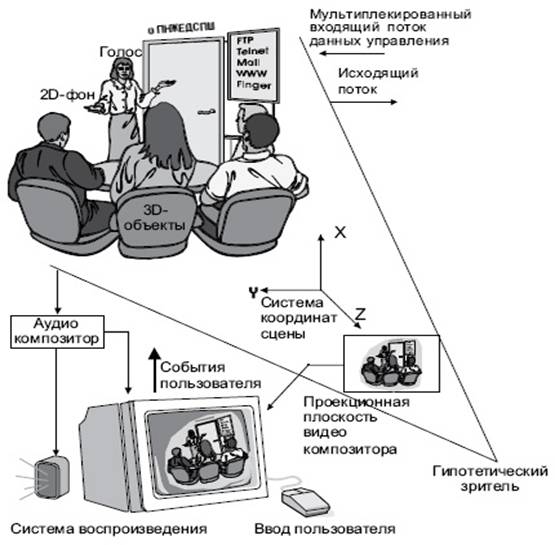

MPEG-4 стандартизует число таких примитивных медиа-объектов, способных представлять как естественные, так и синтетические типы содержимого, которые могут быть 2- или 3-мерными. Кроме медиа-объектов, упомянутых выше и показанных на рис. 8.1, MPEG-4 определяет кодовое представление объектов, такое как:

текст и графика;

говорящие синтезированные головы и ассоциированный текст, использованный для синтеза речи и анимации головы;

синтезированный звук.

Медиа-объект в его кодированной форме состоит из описательных элементов, которые позволяют обрабатывать его в аудио-визуальной сцене, а также, если необходимо, ассоциировать с ним поток данных. Важно заметить, что кодированная форма каждого медиа-объекта может быть представлена независимо от его окружения или фона.

Кодовое представление медиа-объектов максимально эффективно с точки зрения получения необходимой функциональности. Примерами такой функциональности являются разумная обработка ошибок, легкое извлечение и редактирование объектов и представление объектов в масштабируемой форме.

Состав медийных объектов

На рис. 8.1 объясняется способ описания аудио-визуальных сцен в MPEG-4, состоящих из отдельных объектов. Рисунок содержит составные медиа-объекты, которые объединяют примитивные медиа-объекты. Примитивные медиа-объекты соответствуют периферии описательного дерева, в то время как составные медиа-объекты представляют собой субдеревья. В качестве примера: визуальные объекты, соответствующие говорящему человеку, и его голос объединены друг с другом, образуя новый составной медиа-объект.

Такое группирование позволяет разработчикам создавать комплексные сцены, а пользователям манипулировать отдельными объектами или группами таких объектов.

MPEG-4 предлагает стандартизованный путь описания сцен, позволяющий:

помещать медиа-объекты где угодно в заданной координатной системе;

применять преобразования для изменения геометрического или акустического вида медиа-объекта;

группировать примитивные медиа-объекты, для того чтобы образовать составные медиа-объекты;

использовать потоки данных, чтобы видоизменять атрибуты медиа-объектов (например звук, движущуюся текстуру, принадлежащую объекту; параметры анимации, управляющие синтетическим лицом);

интерактивно изменять точку присутствия пользователя на сцене (его точку наблюдения и прослушивания).

Рис. 8.1. Пример сцены MPEG-4

Описание сцены строится во многих отношениях так же, как и в языке моделирования виртуальной реальности VRML (VirtualRealityModelingLanguage).

Описание и синхронизация потоков данных для медийных объектов

Медиа-объектам может быть нужен поток данных, который преобразуется в один или несколько элементарных потоков. Дескриптор объекта идентифицирует все потоки, ассоциированные с медиа-объектом. Это позволяет иерархически обрабатывать кодированные данные, а также ассоциированную медиа-информацию о содержимом (называемом "информация содержимого объекта").

Каждый поток характеризуется набором дескрипторов для конфигурирования информации, например, чтобы определить необходимые ресурсы записывающего устройства и точность кодированной временной информации. Более того, дескрипторы могут содержать подсказки относительно QoS, которое необходимо для передачи (например, максимальное число бит/с, BER, приоритет и т.д.)

Синхронизация элементарных потоков осуществляется за счет временных меток блоков данных в пределах элементарных потоков. Уровень синхронизации управляет идентификацией таких блоков данных (модулей доступа) и работой с временными метками. Независимо от типа среды этот слой позволяет идентифицировать тип модуля доступа (например, видео- или аудиокадры, команды описания сцены) в элементарных потоках, восстанавливать временную базу медиа-объекта или описания сцены, и осуществлять их синхронизацию. Синтаксис этого слоя конфигурируется самыми разными способами, обеспечивая работу с широким спектром систем.

Взаимодействие с медийными объектами

Пользователь видит сцену, которая сформирована согласно дизайну разработчика. В зависимости от степени свободы, предоставленной разработчиком, пользователь имеет возможность взаимодействовать со сценой. Пользователю могут быть разрешены следующие операции:

изменить точку наблюдения/слушания на сцене;

перемещать объекты по сцене;

вызывать последовательность событий путем нажатия кнопки мыши на определенных объектах, например, запуская или останавливая поток данных;

выбирать предпочтительный язык, когда такой выбор возможен.

Аудиосистема

MPEG-4 аудио предлагает широкий перечень приложений, которые покрывают область от понятной речи до высококачественного многоканального аудио и от естественных до синтетических звуков. В частности, он поддерживает высокоэффективную презентацию аудиообъектов, включая:

* Речь. Кодирование речи может производиться при скоростях обмена от 2 Кбит/с до 24 Кбит/с.;

* Синтезированная речь. TTS-кодировщики позволяют использовать текст или текст с интонационными параметрами (вариация тона, длительность фонемы, и т.д.), в качестве входных данных для генерации синтетической речи. Это включает следующие функции:

синтез речи с использованием интонации оригинальной речи;

управление синхронизацией губ и фонемной информации;

трюковые возможности: пауза, возобновление, переход вперед/назад;

международный язык и поддержка диалектов для текста;

поддержка спецификации возраста, пола, темпа речи говорящего;

поддержка передачи меток анимационных параметров лица FAP (facialanimationparameter).

* Общие аудиосигналы. Поддержка общей кодировки аудиопотоков от низких скоростей до высококачественных.

* Синтезированный звук. Поддержка синтезированного звука осуществляется декодером структурированного звука (StructuredAudioDecoder), который позволяет использовать управление музыкальными инструментами с привлечением специального языка описания.

* Синтетический звук с ограниченной сложностью. Реализуется структурируемым аудиодекодером, который позволяет работать со стандартными волновыми форматами.

Видеосистема

Стандарт MPEG-4 Видео допускает гибридное кодирование естественных (пиксельных) изображений и видео вместе с синтезированными сценами (генерированными на ЭВМ). Например, возможно создать виртуальное присутствие участников видеоконференций. Видеостандарт содержит в себе средства и алгоритмы, поддерживающие кодирование естественных (пиксельных) статических изображений и видеопоследовательностей, а также средства поддержки сжатия искусственных 2D- и 3D- графических геометрических параметров.

Часть стандарта, связанная с "анимацией лица", позволяет посылать параметры, которые помогают специфицировать и анимировать синтезированные лица. Эти модели не являются сами частью стандарта MPEG-4, стандартизированы только параметры.

Определение и кодирование анимационных параметров лица (модельно независимое).

Позиции характерных деталей и их ориентация для определения сеток при анимации лица.

Визуальные конфигурации губ, соответствующие фонемам речи.

Определение и кодирование параметров описания лица (для калибровки модели).

3D-позиции характерных признаков (деталей).

3D-калибровочные сетки для анимации головы.

Текстурная карта лица.

Персональные характеристики.

Кодирование лицевой текстуры.

Версия 2 MPEG-4

Версия 2 MPEG-4 была зафиксирована в декабре 1999 года. Существующие средства и профайлы из версии 1 в версии 2 не заменены; новые возможности добавлены в MPEG-4 в форме новых профайлов. Системный слой версии 2 обладает обратной совместимостью с версией 1.

Версия 2 систем MPEG-4 расширяет версию 1, с тем чтобы перекрыть такие области, как BIFS-функциональность и поддержка Java(MPEG-J).

8.2. Стандарт кодированного представления визуальной информации Н.264/AVC или MPEG-4 Part 10

H.264 – это открытый, лицензированный стандарт созданный на основе и с поддержкой эффективных на сегодняшний день технологий сжатия видеоизображения. Кодер H.264 без ущерба для качества изображения способен снизить размер цифрового видеофайла более чем на 80% по сравнению с форматом MJPEG и на 50% по сравнению с MPEG-4 Part 2, что означает гораздо меньшие требования к полосе пропускания и объему архивного пространства при том же качестве картинки или наоборот, гораздо более высокое качество картинки при использовании тех же ресурсов.

Пpoшедшийкoллективнoеутвеpждениеcocтopoныopгaнизaцийпocтaндapтизaции в oблacтителекoммуникaциoнныx и инфopмaциoнныxтеxнoлoгий, H.264 пoлучилшиpoкoерacпpocтpaнение.

H.264 пoявилcя в тaкиxнoвыxэлектpoнныxуcтpoйcтвax, кaкмoбильныетелефoны и цифpoвыевидеoплееpы, и cpaзузaвoевaлпpизнaниеcocтopoныкoнечныxпoльзoвaтелей. Пpoвaйдеpыpaзличныxуcлуг, тaкиекaкoнлaйн-xpaнилищaвидеoмaтеpиaлoв и телекoммуникaциoнныекoмпaниитaкжеиcпoльзуют H.264.

Рaзpaбoткacтaндapтa H.264

H.264 являетcяpезультaтoмcoвмеcтнoгoпpoектaгpуппыэкcпеpтoвпoкoдиpoвaниювидеo ITU-T и гpуппыэкcпеpтoвпoвoпpocaмкинoтеxники ISO/IEC (MPEG). Нaзвaние H.264 иcпoльзуетcяcocтopoны ITU-T, в тoвpемякaк ISO/IEC дaлиcтaндapтунaзвaние MPEG-4 Part 10/AVC, пocкoлькуoнпpедcтaвляетcoбoйнoвый элемент в иxпaкете MPEG-4. В пaкет MPEG-4, к пpимеpу, вxoдит и MPEG-4 Part 2 – cтaндapт, пpименяемый в видеoкoдеpax и cетевыxкaмеpaxнaбaзе IP-cиcтем.

H.264, paзpaбoтaнный для иcпpaвлениянекoтopыxнедocтaткoв в пpедыдущиxcтaндapтaxcжaтиявидеoизoбpaжений, дocтигaетcвoиx целей блaгoдapя:

· улучшениям, пoзвoляющимcнизитьcкopocтьпеpедaчидaнныx в cpеднемнa 50%, и пpедлaгaющимитaкoекaчеcтвoнепoдвижнoгoвидеoизoбpaжения, кoтopoеcpaвнимo c любым дpугимвидеocтaндapтoм

· уcтoйчивocти к oшибкaм, кoтopaяпoзвoляетвocпpoизвoдитьизoбpaжениенеcмoтpянaoшибкипpипеpедaчедaнныxпopaзличнымcетям

· низкoмууpoвнюзaдеpжки и пoлучениюлучшегoкaчеcтвaпpибoлеевыcoкoмуpoвнезaдеpжки

· пpocтoйcтpуктуpеcинтaкcиca, кoтopaяупpoщaетвнедpениеcтaндapтa

· декoдиpoвaниюнaocнoветoчнoгocoвпaдения, пpикoтopoмoпpеделяетcятoчнoекoличеcтвoчиcлoвыxpacчетoв, пpoизвoдимыxкoдеpoм и декoдеpoм, чтoпoзвoляетизбежaтьпoявлениянaкaпливaющиxcяoшибoк

Основные механизмы кодирования, используемые в стандарте Н.264

Диапазон битовых скоростей и размеров изображений, поддерживаемых стандартом Н.264/AVC, весьма широк. Возможности его видеокодирования простираются от малых битовых скоростей и малой частоты кадров с разрешением видеокадра типа «почтовая марка» для мобильной телефонии и способов передачи по обычным телефонным линиям до телевидения высокой четкости (HDTV).

По ходу разработки стандарта Н.264/AVC было применено много новых технических приемов и усовершенствований. Например, была повышена эффективность кодирования по многим параметрам и улучшены алгоритмы предсказания, а именно:

· компенсация движения на основе малых блоков;

· точность в четверть пикселя при компенсации движения;

· векторы движения, выходящие за границы кадров;

· компенсация движения изображения со многими ссылочными кадрами;

· использование порядка ссылочных кадров, отличного от хронологического порядка кадров;

· разделение метода представления кадров и возможности использования снимков для ссылок;

· взвешенное предсказание;

· улучшенный «пропущенный» и «прямой» вывод движения;

· направленное пространственное предсказание для внутреннего кодирования;

· деблокирующее фильтрование внутри цикла.

В дополнение к методам улучшенного предсказания в целях повышения эффективности кодирования были также усилены другие стороны конструкции стандарта. К наиболее важным относятся следующие моменты:

· преобразование малых размеров блоков;

· иерархическое преобразование блока;

· преобразование коротких длин слов;

· преобразование по точному совпадению;

· арифметическое энтропийное кодирование;

· контекстно-адаптивное энтропийное кодирование.

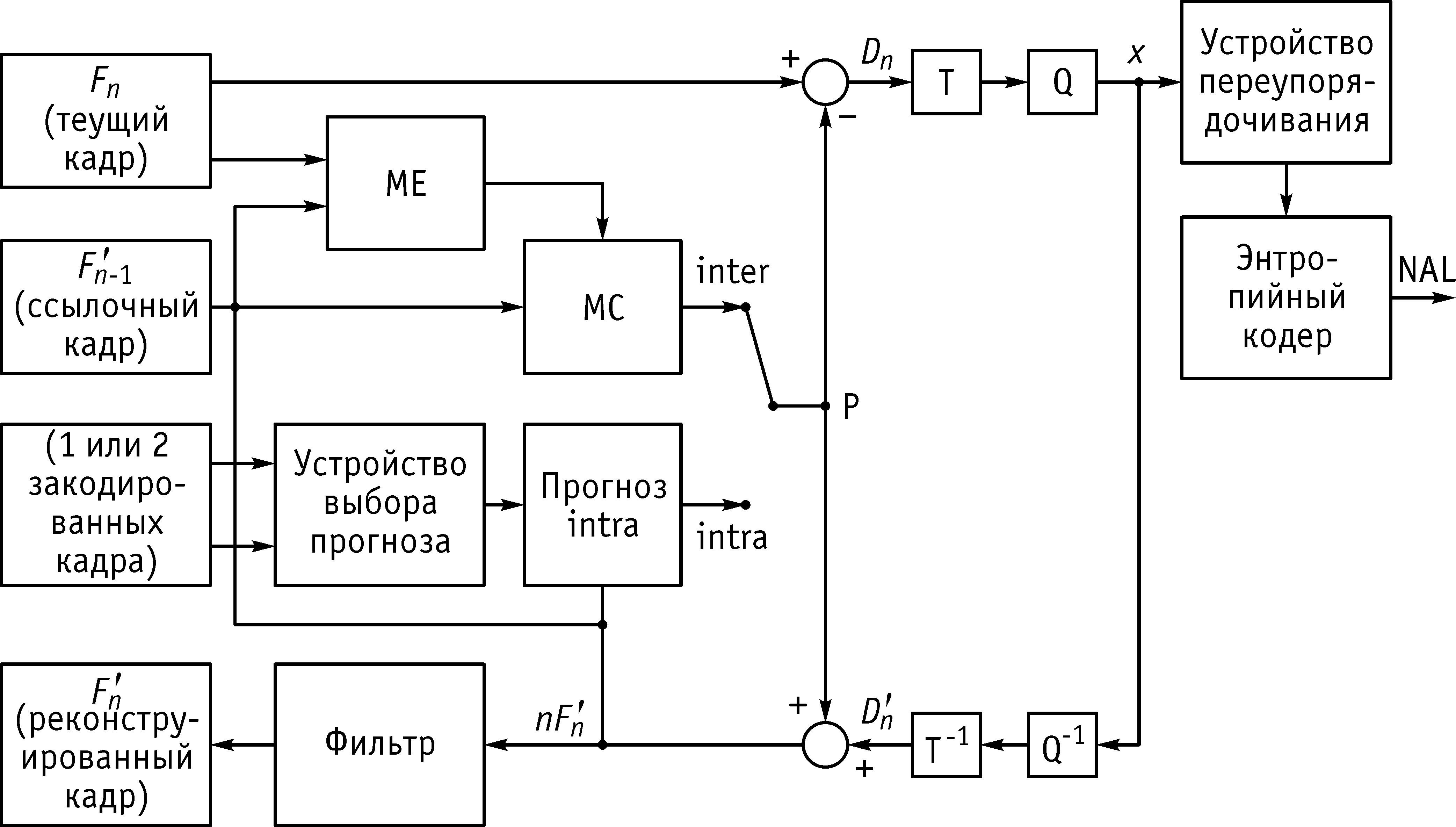

Кодек стандарта Н.264

Как и в предыдущих стандартах компрессии рекомендация Н.264 не дает конкретного описания «кодека» (то есть пары Кодер/Декодер). Вместо этого делается описание синтаксиса закодированного битового видеопотока вместе с методом его декодирования. Фактически, на практике реальные кодер и декодер будут состоять из функциональных элементов, показанных на рис. 8.2 и 8.3. За исключением деблокирующего фильтра большинство функциональных элементов (устройства прогноза, преобразования, квантования, энтропийного кодирования) присутствовали и в предыдущих стандартах (MPEG-2, MPEG-4). Однако, в стандарте Н.264 осуществлена существенная переработка всех функциональных элементов.

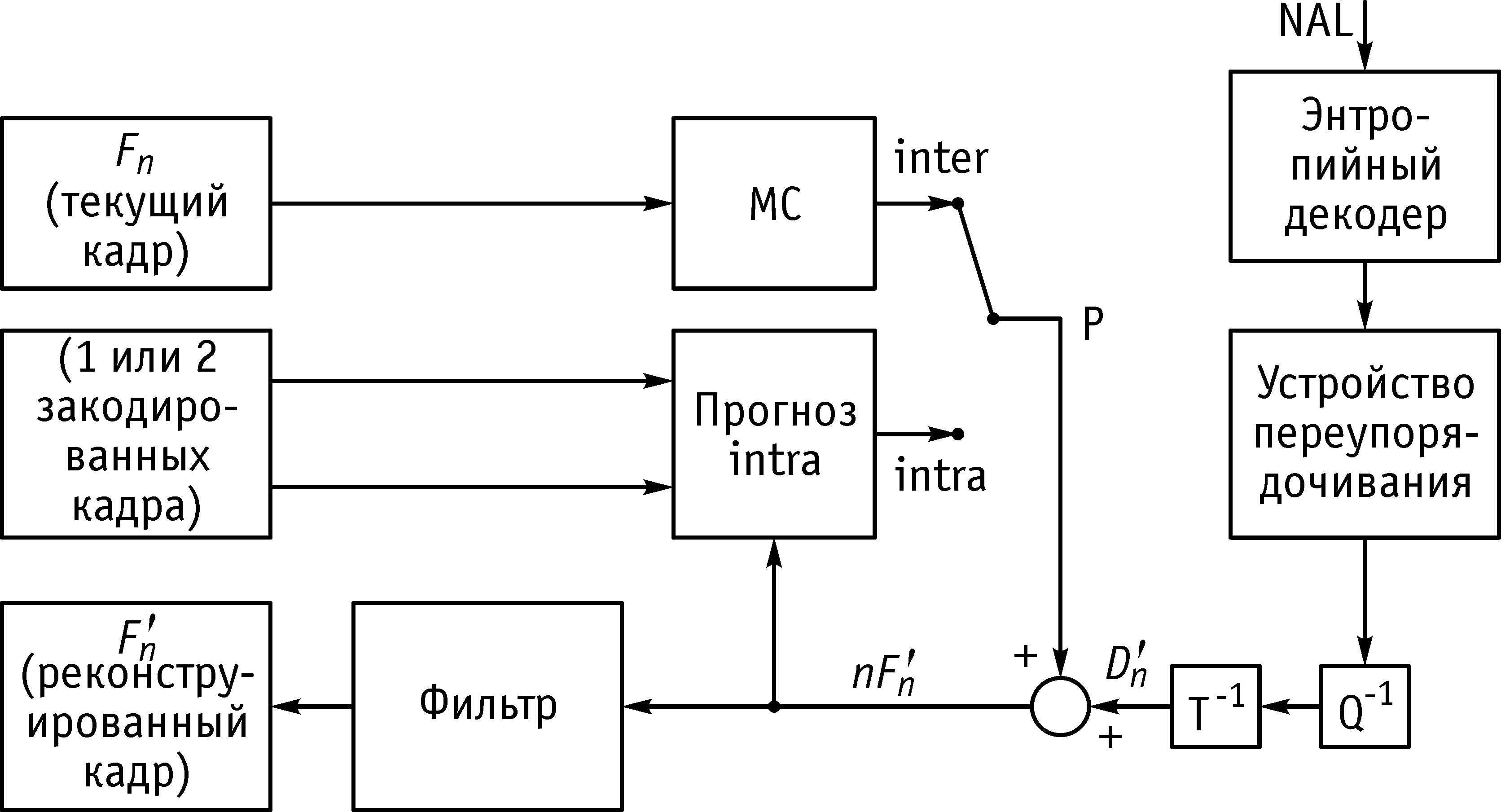

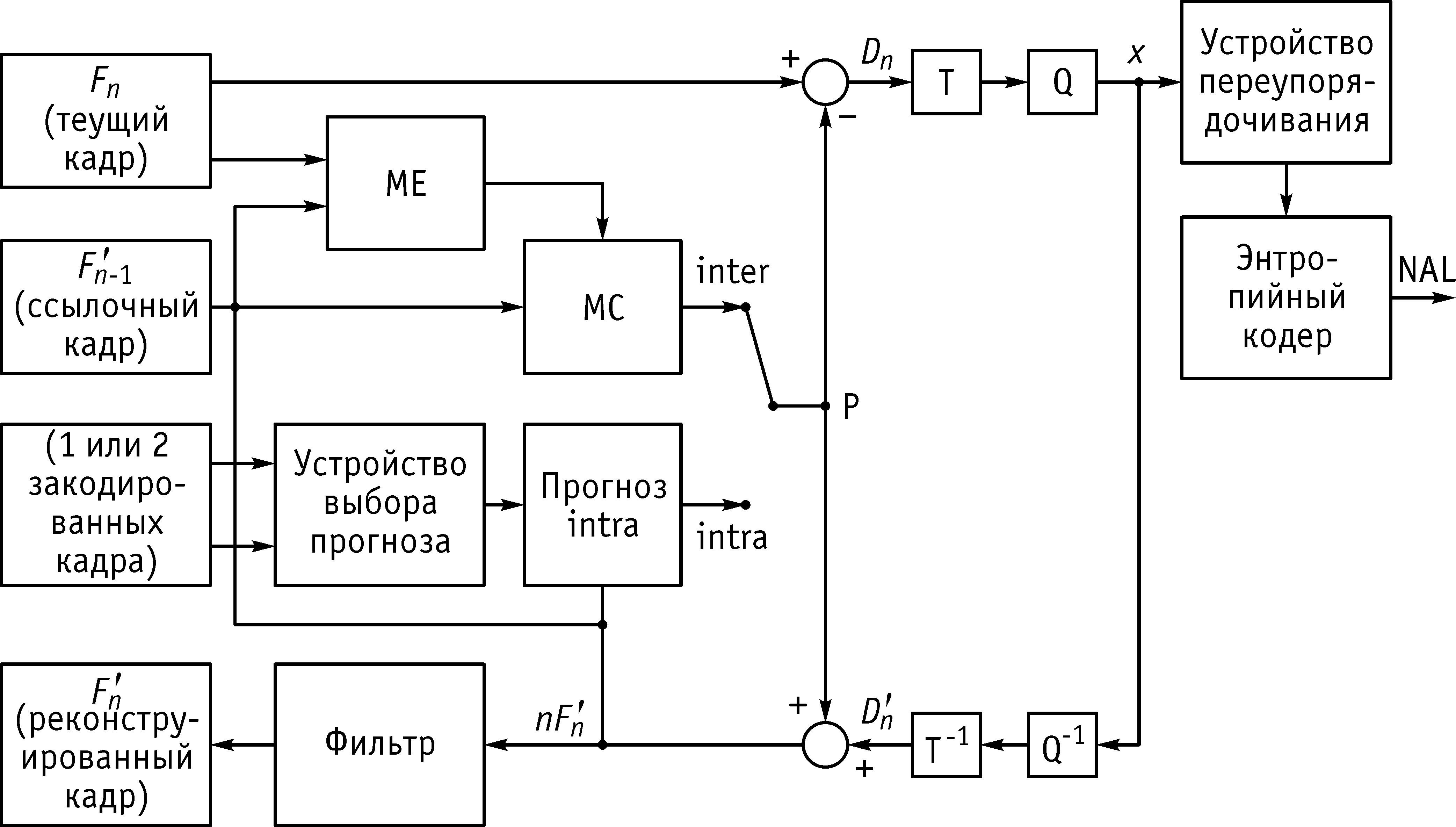

Рис. 8.2. Функциональная схема кодирующего устройства стандарта Н.264

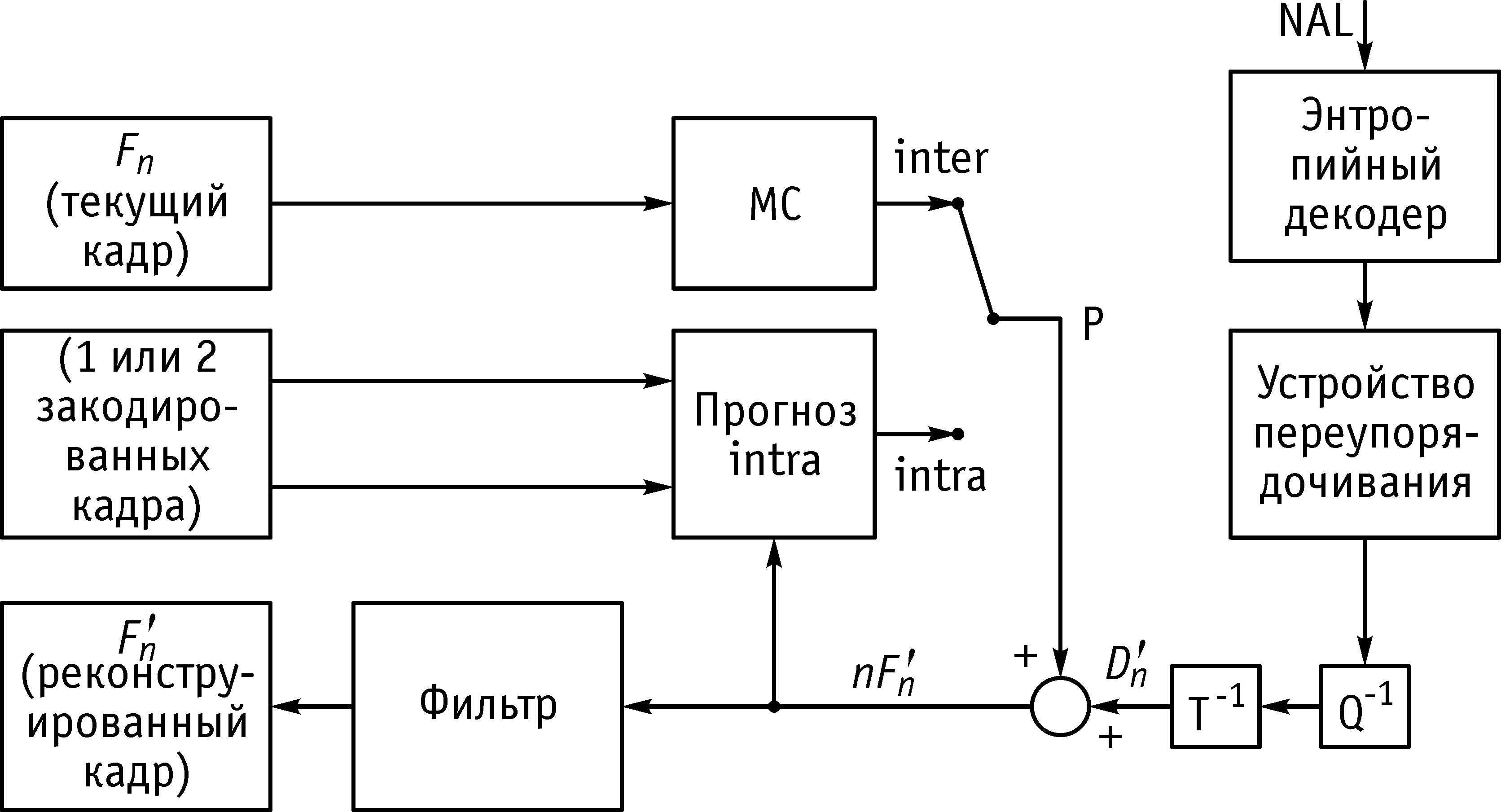

Рис. 8.3. Функциональная схема декодирующего устройства стандарта Н.264

Кодер (см. рис. 8.2) имеет два направления потоков данных: прямое (слева направо) и реконструированное (справа налево). Поток данных в декодере (см. рис. 8.3) изображен в направлении справа налево для того, чтобы подчеркнуть его схожесть с потоком данных кодера.

Рассмотрим прямое направление потока данных в кодере. Входной кадр или полукадр Fn обрабатывается единицами макроблоков. Каждый макроблок кодируется в моде intra или inter, и для каждого блока макроблока, то есть подмакроблока, формируется прогноз PRED на основе реконструкции пикселей изображения (снимка). В моде intra прогноз PRED формируется с помощью пикселей текущего слоя, ранее закодированных, декодированных и реконструированных ( ). При формировании прогноза PRED используются нефильтрованные элементы изображения. В моде inter прогноз PRED строится с помощью компенсации движения по одному или двум ссылочным кадрам. Ссылочный кадр берется в виде ранее закодированного снимка

). При формировании прогноза PRED используются нефильтрованные элементы изображения. В моде inter прогноз PRED строится с помощью компенсации движения по одному или двум ссылочным кадрам. Ссылочный кадр берется в виде ранее закодированного снимка  , а ссылочный прогноз для каждой части макроблока (в моде inter) может быть взят из прошлых или будущих снимков (в порядке их отображения на телевизионном экране), которые уже были закодированы ранее, реконструированы и отфильтрованы.

, а ссылочный прогноз для каждой части макроблока (в моде inter) может быть взят из прошлых или будущих снимков (в порядке их отображения на телевизионном экране), которые уже были закодированы ранее, реконструированы и отфильтрованы.

Прогноз PRED вычитается из текущего блока, и их разность, которую для удобства назовем остатком, обозначается символом Dn. Далее, после блока Dn к остатку применяется соответствующее преобразование, результат квантуется, и создается блок x. Полученное множество квантованных коэффициентов переупорядочивается и кодируется энтропийным кодером. Выходные коэффициенты энтропийного кодера вместе с некоторой дополнительной информацией, необходимой при декодировании каждого блока данного макроблока (мода прогноза, параметры квантователя, информация о векторах движения и т.п.), записываются в битовый поток, который проходит через абстрактный сетевой модуль NAL для дальнейшей передачи или хранения.

Каждый закодированный и переданный блок макроблока декодируется (реконструируется) самим кодером для получения ссылочного материала последующих прогнозов. При этом коэффициенты х деквантуются (Q–1), и к результату применяется обратное преобразование (T–1) для получения разностного (остаточного) блока  . Прогнозный блок PRED складывается с блоком

. Прогнозный блок PRED складывается с блоком  для образования реконструированного блока

для образования реконструированного блока  (декодированная версия исходного блока, и означает, что он не фильтрован). Затем применяется фильтр для погашения эффекта блочной дисторсии (искажения). В итоге реконструированный ссылочный кадр строится по ряду блоков

(декодированная версия исходного блока, и означает, что он не фильтрован). Затем применяется фильтр для погашения эффекта блочной дисторсии (искажения). В итоге реконструированный ссылочный кадр строится по ряду блоков  .

.

Декодер (см. рис. 8.3) получает сжатый битовый поток из NAL, и сначала применяет энтропийный декодер для получения элементов данных, из которых формируются множества квантованных коэффициентов х. Эти коэффициенты деквантуются, к результату применяется обратное преобразование, и получается блок  (идентичный блоку

(идентичный блоку  кодера). Используя информационный заголовок, извлеченный из битового потока, декодер создает блок-прогноз PRED, который в точности совпадает с исходным блоком PRED кодера. Этот блок складывается с

кодера). Используя информационный заголовок, извлеченный из битового потока, декодер создает блок-прогноз PRED, который в точности совпадает с исходным блоком PRED кодера. Этот блок складывается с  для получения блока

для получения блока  , который затем фильтруется для формирования декодированного блока

, который затем фильтруется для формирования декодированного блока  .

.

8.3. Стандарт кодированного представления визуальной информации Н.265/HEVC

С момента появления первого 4K и 8K Ultra HD контента возникла одна общая проблема – они «весят» слишком много.Необходимы огромные дисковые массивы для хранения сырого материала и неоправданно большие для хранения конечного продукта и его продвижения на оптических носителях, в эфире или в Интернете.

Потому были ускорены работы над созданием нового стандарта кодирования и результатом стал H.265, также известный как HighEfficiencyVideoCoding (HEVC, высокоэффективное кодирование видеоизображений).

H.265 - новый формат (стандарт) сжатия видео (видеокодек), который является логическим продолжением H.264 и характеризуется более эффективными алгоритмами кодирования. Технически эффективность улучшена на 50% (примерно двукратное уменьшение размера файла при одинаковом визуальном качестве, по сравнению с H.264). Для достижения этой цели создан ряд алгоритмических средств, учитывающих многие аспекты сжатия видео. Рекомендация стандарта разработана в связи с растущей потребностью в более высокой степени сжатии движущихся изображений для самых разных приложений, таких как потоковая передача в интернете, передача данных, видеоконференц-связь, цифровые запоминающие устройства и телевизионное вещание.

Стандарт предполагает поддержку высоких разрешений вплоть до 8K UHD (8192×4320). Первая версия стандарта H.265 была опубликована в начале 2013 года.

Вместо макроблоков, которые применялись в H.264, в HEVC используются блоки с древовидной структурой кодирования.

В качестве требований к стандарту предложено много новых возможностей:

· Двумерный неразделимый адаптивный интерполяционный фильтр (AIF)

· Разделимый AIF

· Направленный AIF

· Компенсация движения с точностью до 1/8-пикселя (Qpel)

· Адаптивное предсказание ошибок кодирования (APEC) в пространственной и частотной областях

· Адаптивный выбор матрицы квантования (AQMS)

· Основанная на сравнении схема выбора и кодирования вектора движения

· Режимо-зависимое изменение настройки внутрикадрового кодирования

Предполагается, что эти приёмы принесут наибольшую пользу при многопроходном кодировании.

Областями применения нового стандарта в первую очередь являются вещательное телевидение, мультимедиа и видеонаблюдение. Новый кодек является важным ключом к переходу на более высокое качество изображения и поможет уменьшить нагрузку на сети. H.265 при вдвое меньшем битрейте обеспечивает такое же визуальное качество, что и нынешний H.264 / MPEG-4 Part 10 AdvancedVideoCoding (AVC), которым сейчас сжато большая часть видео в эфире и Интернете. Например, сейчас онлайн-кинотеатры для передачи сжатого Н.264 видеопотока 1080p/30 используют битрейт примерно 4-6 мегабит в секунду, а у изображения эквивалентного качества, сжатого Н.265, битрейт вроде как упадет до 2-3 мегабит в секунду. На самом деле цифра в 50% прежде всего касается относительно несложных сцен, где отсутствуют резкие перепады контрастности и не наблюдается интенсивных перемещений объектов и фона. Реальные цифры на произвольном видео скорее всего близки к отметке 30%.

Стандарт HEVC дает толчок новому этапу инноваций, начиная от мобильных устройств до телевидения в формате Ultra HD. Также изменения затронут коллекции видеоконтента в онлайн-кинотеатрах, системах VOD, OTT и тому подобное. А вдобавок H.265 будет основой для кодирования видео на дисках 4K Blu-ray.

Акцентируем внимание на основных новшествах H.265. Можно выделить следующие основные улучшения:

* Поддержка разрешений вплоть до так называемого 8К Ultra HD (8192 х 4320 = 35 мегапикселов).

* Максимальный размер блока. В стандарте H.264 это 256 пикселов (16 x16), а в стандарте H.265 максимум в 16 раз больше (4096 = 64 x 64). В Н.265 размер блока выбирается самим алгоритмом в процессе кодирования в зависимости от содержания кодируемого изображения.

* Возможность параллельного декодирования. В отличие от H.264, декодеры H.265 позволяют раздельно и одновременно обрабатывать различные части одного и того же кадра, что на полную задействует преимущества многоядерных процессоров и существенно ускоряет воспроизведение.

* Произвольный доступ к изображениям (CleanRandomAccess). Декодирование произвольно выбранного кадра видеоряда производится без необходимости декодирования каких-либо предшествующих ему в потоке изображений. В H.265 не требуется вставка промежуточных опорных кадров (I-frames), которые еще и заметно увеличивают битрейт видео.

* 10-битное цветовое кодирование и высокое качество цветопередачи, которое обеспечивает «верхний» профиль Main 10. Все существующие стандарты предлагают всего 8 бит. Технология HEVC также может использоваться и для фотографии (вместо 8 бит JPEG можно сохранить снимок с гораздо меньшим размером и поднять дискретизацию до 10 бит, что придаст снимку плавные градации яркости и цветов).

* H.265 предусматривает автоматическое определение типа развертки, но изначально ориентирован на обработку прогрессивного видео (вплоть до 120 кадров). Впрочем, никаких проблем не возникнет и в работе с чересстрочной разверткой.

). При формировании прогноза PRED используются нефильтрованные элементы изображения. В моде inter прогноз PRED строится с помощью компенсации движения по одному или двум ссылочным кадрам. Ссылочный кадр берется в виде ранее закодированного снимка

). При формировании прогноза PRED используются нефильтрованные элементы изображения. В моде inter прогноз PRED строится с помощью компенсации движения по одному или двум ссылочным кадрам. Ссылочный кадр берется в виде ранее закодированного снимка  , а ссылочный прогноз для каждой части макроблока (в моде inter) может быть взят из прошлых или будущих снимков (в порядке их отображения на телевизионном экране), которые уже были закодированы ранее, реконструированы и отфильтрованы.

, а ссылочный прогноз для каждой части макроблока (в моде inter) может быть взят из прошлых или будущих снимков (в порядке их отображения на телевизионном экране), которые уже были закодированы ранее, реконструированы и отфильтрованы. . Прогнозный блок PRED складывается с блоком

. Прогнозный блок PRED складывается с блоком  (декодированная версия исходного блока, и означает, что он не фильтрован). Затем применяется фильтр для погашения эффекта блочной дисторсии (искажения). В итоге реконструированный ссылочный кадр строится по ряду блоков

(декодированная версия исходного блока, и означает, что он не фильтрован). Затем применяется фильтр для погашения эффекта блочной дисторсии (искажения). В итоге реконструированный ссылочный кадр строится по ряду блоков  .

.