Коэффициент линейной корреляции между  и

и  определяется по формуле (7.1).

определяется по формуле (7.1).

(7.1)

(7.1)

.

.

Можно рассчитать по другой формуле.

;

;  ;

;

Мы должны различать корреляцию (взаимосвязь) и причинность (каузальность). При исследовании можно обнаружить, что когда возрастает  , возрастает также и

, возрастает также и  . Но это не обязательно означает, что

. Но это не обязательно означает, что  служит причиной

служит причиной  . Связь здесь может быть чисто случайной или порождаться каким-либо другим фактором, неучтенным в нашем исследовании. Величина статистического показателя парного коэффициента корреляции

. Связь здесь может быть чисто случайной или порождаться каким-либо другим фактором, неучтенным в нашем исследовании. Величина статистического показателя парного коэффициента корреляции  абсолютно ничего не говорит о направлении причинно-следственных связей, т.е. о том, какая из рассматриваемых переменных является независимой и определяет поведение другой переменной. Эти вопросы должны быть решены в ходе теоретического анализа, т.е. априори. В экономических исследованиях иногда довольно трудно установить причинно-следственные связи. Например, определена положительная связь между уровнем образования и доходом. Можно предположить, что более высокий уровень образования является причиной, а более высокий доход – следствием. Но можно поставить вопрос и по другому, что люди, имеющие более высокие доходы, имеют больше возможностей в получении более высокого уровня образования. Но не исключен и третий вариант, что на эти два исследуемых показателя влияет и ряд других факторов, которыми обладают те или иные индивидуумы (способность, настойчивость в достижении цели и др.).

абсолютно ничего не говорит о направлении причинно-следственных связей, т.е. о том, какая из рассматриваемых переменных является независимой и определяет поведение другой переменной. Эти вопросы должны быть решены в ходе теоретического анализа, т.е. априори. В экономических исследованиях иногда довольно трудно установить причинно-следственные связи. Например, определена положительная связь между уровнем образования и доходом. Можно предположить, что более высокий уровень образования является причиной, а более высокий доход – следствием. Но можно поставить вопрос и по другому, что люди, имеющие более высокие доходы, имеют больше возможностей в получении более высокого уровня образования. Но не исключен и третий вариант, что на эти два исследуемых показателя влияет и ряд других факторов, которыми обладают те или иные индивидуумы (способность, настойчивость в достижении цели и др.).

Таким образом, высокая корреляция может свидетельствовать лишь о линейной форме связи и ее можно связывать с любой из перечисленных выше трех возможностей о причинах взаимосвязи. Нельзя отбрасывать и четвертый вариант – о случайности взаимосвязи, поэтому всегда следует опасаться ложной корреляции.

Ложными корреляциями называются такие корреляции, которые не могут быть объяснены с теоретической точки зрения. Ложная корреляция была введена К. Пирсоном в связи с измерением тесноты связи между относительными величинами (индексами)  . Причем

. Причем  не коррелированны. Если

не коррелированны. Если  даже взаимно независимы, то индексы

даже взаимно независимы, то индексы  , образованные отношением этих величин к одному и тому же знаменателю

, образованные отношением этих величин к одному и тому же знаменателю  будут коррелированны друг с другом.

будут коррелированны друг с другом.

Достоверность значения парного коэффициента корреляции проверяется сравнением расчетного значения критерия Стьюдента, рассчитанного по формуле  , где

, где  – ошибка коэффициента корреляции, с критическим значением критерия Стьюдента

– ошибка коэффициента корреляции, с критическим значением критерия Стьюдента  с выбранным уровнем значимости

с выбранным уровнем значимости  , равным

, равным  и степенью свободы

и степенью свободы  . Если

. Если  , то парный коэффициент корреляции значим.

, то парный коэффициент корреляции значим.

Как отмечалось выше, взаимосвязь между исследуемыми признаками может быть обусловлена другой причиной, что есть третья переменная, которая оказывает сильное влияние на две первые переменные и может служить причиной высокой коррелированности их. Чтобы найти чистую корреляцию между двумя первыми переменными исключают (элиминируют) влияние других факторов, используя понятия частного коэффициента корреляции.

Для определения частных коэффициентов корреляции (7.2) можно использовать элементы обратной матрицы парных коэффициентов корреляции.

(7.2)

(7.2)

где  – элементы обратной матрицы парных коэффициентов корреляции

– элементы обратной матрицы парных коэффициентов корреляции  и размерностью

и размерностью  ;

;  .

.

Например, элементы обратной матрицы  будут такими.

будут такими.

где  .

.

Значимость частного коэффициента корреляции находится также как и парного коэффициента корреляции, только ошибку частного коэффициента корреляции определяют так:  , где

, где  - количество элиминированных переменных.

- количество элиминированных переменных.

Рассмотрим примеры расчетов парных и частных коэффициентов корреляции и их значимости.

Пример 1. Расчет парного коэффициента корреляции и его значимости.

Таблица 7.3

Расчет парного коэффициента корреляции

Цена,

| Спрос,

|

|

|

|

|

|

|

|

| -2

|

|

|

|

|

|

|

| -12

|

| -60

|

|

|

|

|

|

| -5

| -15

|

|

|

|

|

| -2

|

|

|

|

|

|

|

|

| -10

| -180

|

|

|

|

|

|

| -15

| -420

|

|

|

|

|

|

| -5

| -40

|

|

|

|

|

| -12

|

| -120

|

|

|

|

|

| -22

|

| -330

|

|

|

|

|

| -7

|

| -35

|

|

|

|

|

|

|

|

|

|

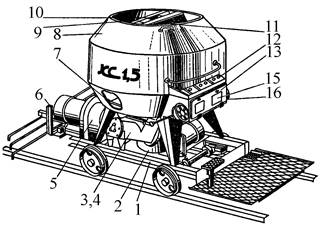

Рис. 7.6

дол;

дол;  кг.

кг.

с увеличением цены спрос падает.

с увеличением цены спрос падает.

Найдем расчетное значение критерия Стьюдента:

;

;

Критические значения  - критерия находим из таблицы с уровнем значимости

- критерия находим из таблицы с уровнем значимости  и степенью свободы

и степенью свободы

. Так как

. Так как  , то парный коэффициент корреляции значим.

, то парный коэффициент корреляции значим.

Пример 2. Частная корреляция.

Таблица 7.4

Данные для расчета частных коэффициентов корреляции

Энерговооруженность

| Фондовооруженность

| Выработка

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Рассчитаем матрицу парных коэффициентов корреляции  между

между  и

и  и обратную матрицу

и обратную матрицу  .

.

Расчет частных коэффициентов корреляции

;

;

;

;

;

;

. Так как

. Так как  ,то частные коэффициенты корреляции значимы

,то частные коэффициенты корреляции значимы

Уравнение регрессии

Регрессионный анализ применяется в том случае, когда установлена причинная связь между исследуемыми переменными, одна из которых независимая переменная (причина), а другая зависимая переменная (следствие). Если имеется одна независимая переменная и одна зависимая переменная регрессионная модель называется парной регрессией. Если независимых переменных несколько, то модель называется множественной регрессией.

Линейную связь для зависимой переменной  от независимой переменной

от независимой переменной  можно записать следующим образом.

можно записать следующим образом.

.

.

Данное уравнение называется линейной теоретической регрессией,  - параметры теоретической регрессии, а

- параметры теоретической регрессии, а  - случайная ошибка, представляет собой все те независимые переменные, которые вероятно влияют на

- случайная ошибка, представляет собой все те независимые переменные, которые вероятно влияют на  , но не поддаются измерению или по какой либо другой причине не включены в регрессионную модель. Для определения

, но не поддаются измерению или по какой либо другой причине не включены в регрессионную модель. Для определения  необходимо использовать все значения

необходимо использовать все значения  и

и  в генеральной совокупности. Для выборочных данных строят эмпирическое уравнение регрессии

в генеральной совокупности. Для выборочных данных строят эмпирическое уравнение регрессии  , где

, где  - оценка параметров

- оценка параметров  . Случайная ошибка определяется

. Случайная ошибка определяется  . Для нахождения оценок

. Для нахождения оценок  используют метод наименьших квадратов, который минимизирует сумму квадратов отклонений наблюдаемых значении

используют метод наименьших квадратов, который минимизирует сумму квадратов отклонений наблюдаемых значении  от теоретических

от теоретических  .

.

Для минимизации суммы квадратов отклонений берут частные производные по неизвестным параметрам  и приравнивают к нулю.

и приравнивают к нулю.

Если каждое уравнение разделим на  , то получим.

, то получим.

Из этой системы можно определить  .

.

;

;  (7.3)

(7.3)

Метод наименьших квадратов предполагает следующие предпосылки:

1. Математическое ожидание случайных ошибок имеет среднею равную нулю  и ошибки нормально распределены.

и ошибки нормально распределены.

Для проверки этого условия можно построить гистограмму распределения ошибок  – ось абсцисс, а ось ординат частоты

– ось абсцисс, а ось ординат частоты  и по гистограмме можно визуально установить близко ли распределение ошибок к симметричному с центром равным нулю.

и по гистограмме можно визуально установить близко ли распределение ошибок к симметричному с центром равным нулю.

2. Дисперсия случайного отклонения постоянна  для любого заданного значения

для любого заданного значения  , следовательно, постоянна и дисперсия зависимой переменной

, следовательно, постоянна и дисперсия зависимой переменной  и называется гомоскедастичностью. Когда нет постоянства дисперсии ошибок, то такое явление называется гетероскедастичностью. Последствия этого следующие: оценки параметров не будут иметь наименьшую дисперсию по сравнению с другими оценками, стандартная ошибка будет смещена и выводы, полученные по

и называется гомоскедастичностью. Когда нет постоянства дисперсии ошибок, то такое явление называется гетероскедастичностью. Последствия этого следующие: оценки параметров не будут иметь наименьшую дисперсию по сравнению с другими оценками, стандартная ошибка будет смещена и выводы, полученные по  критериям, будут неверны.

критериям, будут неверны.

Для проверки гомоскедастичности можно использовать графики: на оси ординат откладывают  , и на оси абсцисс для одной независимой переменной откладывают

, и на оси абсцисс для одной независимой переменной откладывают  и для множественной регрессии -

и для множественной регрессии -  . Если обнаружена гетероскедастичность (рис. 7.7), то применяют взвешенный МНК.

. Если обнаружена гетероскедастичность (рис. 7.7), то применяют взвешенный МНК.

Рис. 7.7 Рис. 7.8

3.  – это допущение означает некоррелированность ошибок. Если это условие не выполняется, то ошибки

– это допущение означает некоррелированность ошибок. Если это условие не выполняется, то ошибки  не будут независимы и такое явление называется автокорреляцией. Наиболее часто встречается в рядах динамики. Наличие или отсутствие автокорреляции проверяется с помощью критерия Дарбина - Уотсона

не будут независимы и такое явление называется автокорреляцией. Наиболее часто встречается в рядах динамики. Наличие или отсутствие автокорреляции проверяется с помощью критерия Дарбина - Уотсона  .

.

4. Мультиколлинеарность (для множественной регрессии) – высокая коррелированность матрицы парных коэффициентов корреляции независимых переменных. Получаемые параметры регрессии имеют большие стандартные ошибки и проверка их значимости по  - критерию Стьюдента не имеет смысла. Оценки параметров регрессии очень чувствительны к изменению объема выборки и к результатам наблюдений.

- критерию Стьюдента не имеет смысла. Оценки параметров регрессии очень чувствительны к изменению объема выборки и к результатам наблюдений.

Множественная корреляция

Матричная запись МНК. Введем обозначения:

где  – вектор наблюдений зависимых переменных;

– вектор наблюдений зависимых переменных;  – матрица наблюдений независимых переменных;

– матрица наблюдений независимых переменных;  – количество наблюдений;

– количество наблюдений;  – количество независимых переменных.

– количество независимых переменных.

Модель регрессии в матричной форме можно записать так  . Для определения

. Для определения  минимизируем сумму квадратов отклонений вектора

минимизируем сумму квадратов отклонений вектора  от линии регрессии.

от линии регрессии.

Дифференцируя это выражение по вектору  и приравнивая к нулю, получим.

и приравнивая к нулю, получим.

(7.4)

(7.4)

Оценка параметров регрессии по матрице парных коэффициентов корреляции.

Результаты корреляционного анализа можно использовать для построения регрессионной модели. Коэффициенты корреляции представляются в виде вектора столбца  зависимой и независимых переменных и матрицы

зависимой и независимых переменных и матрицы  независимых переменных.

независимых переменных.

По этим данным находятся вектор  стандартизованных коэффициентов регрессии

стандартизованных коэффициентов регрессии  .

.

(7.5)

(7.5)

Оценка влияния независимых переменных на зависимую переменную затруднена, если независимые переменные имеют различные единицы измерения. В этом случае используют стандартизованные  коэффициенты. Модель регрессии в стандартизованном масштабе имеет вид:

коэффициенты. Модель регрессии в стандартизованном масштабе имеет вид:

где  – теоретические стандартизованные значения зависимой переменной, наблюдаемые значения которых получены так

– теоретические стандартизованные значения зависимой переменной, наблюдаемые значения которых получены так  , у которой средняя

, у которой средняя  ;

;  – стандартизованные значения независимых переменных, полученных так

– стандартизованные значения независимых переменных, полученных так  , у которых средние

, у которых средние  и

и  .

.

Интерпретация  коэффициентов.

коэффициентов.

Если независимые переменные  изменятся на величину своего стандартного отклонения

изменятся на величину своего стандартного отклонения  , то зависимая переменная

, то зависимая переменная  изменится на величину

изменится на величину  .

.

Они дают также возможность провести сравнительную оценку влияния независимых переменных на зависимую переменную. Для этого, выбрав по абсолютной величине  и разделив на эту величину остальные

и разделив на эту величину остальные  коэффициенты, определим, какая из независимых переменных, оказывает наибольшее влияние на зависимую переменную.

коэффициенты, определим, какая из независимых переменных, оказывает наибольшее влияние на зависимую переменную.

Для перехода от стандартизованного масштаба к натуральному масштабу используют формулы:

Одним из условий классической регрессионной модели является линейная независимость матрицы независимых переменных, это эквивалентно тому, что матрица  имеет полный ранг

имеет полный ранг  . Рангом матрицы называется порядок наибольшего отличного от нуля определителя. При нарушении этого условия, т.е. когда один из столбцов матрицы

. Рангом матрицы называется порядок наибольшего отличного от нуля определителя. При нарушении этого условия, т.е. когда один из столбцов матрицы  , есть линейная комбинация остальных столбцов, то такая матрица называется вырожденной и ее определитель равен нулю. В практических исследованиях такая ситуация встречается редко, чаще встречаются случаи, когда матрица

, есть линейная комбинация остальных столбцов, то такая матрица называется вырожденной и ее определитель равен нулю. В практических исследованиях такая ситуация встречается редко, чаще встречаются случаи, когда матрица  имеет полный ранг, но между независимыми переменными имеется высокая корреляция, т. е. матрица

имеет полный ранг, но между независимыми переменными имеется высокая корреляция, т. е. матрица  близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. Признаки мультиколлинеарности таковы:

близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. Признаки мультиколлинеарности таковы:

1. Небольшое изменение в исходных данных приводит к существенному изменению оценок параметров модели;

2. Оценки параметров модели имеют большие стандартные ошибки и не значимы по  - критерию Стьюдента, в то время как модель в целом по

- критерию Стьюдента, в то время как модель в целом по  критерию значима;

критерию значима;

3. Параметры модели имеют другое направление воздействия на зависимую переменную по сравнению с теоретическими представлениями.

4. Большие отклонения  собственного значения матрицы от

собственного значения матрицы от  .

.

Если при построении модели возникла проблема мультиколлинеарности, то, как будто самым простым способом решить эту проблему, является исключение из модели одной из независимых переменных, сильно коррелированной с другой независимой переменной. Но такой подход вряд ли может быть оправдан, так как это может привести к неправильной спецификации модели (количество независимых переменных и форма связи), что в конечном случае приведет к смещению параметров модели. Можно попробовать преобразовать переменные, если есть возможность использовать дополнительные данные или же применить специальные методы решения проблемы мультиколлинеарности (регрессия на главных компонентах, ридж-регрессия).

Для обнаружения мультиколлинеарности использую следующие подходы:

1. Ферраром и Глобером предложен критерий оценки мультиколлинеарности, суть которого в следующем. Если независимые переменные  попарно линейно независимы, то корреляционная матрица является единичной, следовательно, ее обратная матрица также является единичной. Выборочная корреляционная матрица и ее обратная отличаются от единичной матрицы. На этом свойстве основан предложенный ими критерий, который подчиняется распределению Фишера с

попарно линейно независимы, то корреляционная матрица является единичной, следовательно, ее обратная матрица также является единичной. Выборочная корреляционная матрица и ее обратная отличаются от единичной матрицы. На этом свойстве основан предложенный ими критерий, который подчиняется распределению Фишера с  степенями свободы.

степенями свободы.

где  – диагональные элементы обратной корреляционной матрицы независимых переменных;

– диагональные элементы обратной корреляционной матрицы независимых переменных;  – количество независимых переменных;

– количество независимых переменных;  – количество наблюдений.

– количество наблюдений.

Если  , то принимается гипотеза отсутствия мультиколлинеарности

, то принимается гипотеза отсутствия мультиколлинеарности  независимой переменной с остальными независимыми переменными при уровне значимости a=0.05, а если

независимой переменной с остальными независимыми переменными при уровне значимости a=0.05, а если  , то принимается гипотеза присутствия мультиколлинеарности

, то принимается гипотеза присутствия мультиколлинеарности  независимой переменной с остальными независимыми переменными при a=0.01.

независимой переменной с остальными независимыми переменными при a=0.01.

2. В пакетах прикладных программ ”Statistica”, “Statgraphis plus” и других используется критерий обнаружения мультиколлинеарности, основанный на множественном коэффициенте детерминации  между независимой переменной и остальными независимыми переменными, определенный как

между независимой переменной и остальными независимыми переменными, определенный как  (Variance Inflation Factor).

(Variance Inflation Factor).

Если  , то

, то  , то

, то  не зависит от остальных независимых переменных, если

не зависит от остальных независимых переменных, если  , то

, то  зависит от остальных независимых переменных и

зависит от остальных независимых переменных и  . Определив

. Определив  для каждой независимой переменной и если

для каждой независимой переменной и если  – это свидетельствует о наличии мультиколлинеарности между

– это свидетельствует о наличии мультиколлинеарности между  и остальными независимыми переменными.

и остальными независимыми переменными.

3. В пакете прикладных программ SPSS наличие мультиколлинеарности контролируется состоянием индексов, определяемых как:

где  – собственные значения исследуемой матрицы независимых переменных.

– собственные значения исследуемой матрицы независимых переменных.

Большие значения индексов свидетельствуют о наличии проблемы мультиколлинеарности.

Оценка адекватности регрессионной модели.

Рассматриваемую линейную модель можно записать так:

Вычтем из этого уравнения среднее значение зависимой переменной  .

.

Возводя в квадрат и просуммировав это соотношение, получим

Доказывается, что выражение  . Учитывая это, получим.

. Учитывая это, получим.

Это означает, что квадрат полной вариации  обозначим его

обозначим его  , равен сумме квадратов вариации вследствие регрессии

, равен сумме квадратов вариации вследствие регрессии  , обозначим его

, обозначим его  и слагаемого, которое называется суммой квадратов ошибок

и слагаемого, которое называется суммой квадратов ошибок  , обозначим

, обозначим  , тогда это выражение можно переписать так.

, тогда это выражение можно переписать так.

Поскольку истинное значение  по выборке определить не возможно, оно заменяется выборочной несмещенной дисперсией

по выборке определить не возможно, оно заменяется выборочной несмещенной дисперсией  , а корень квадратный из дисперсии называется стандартной ошибкой оценки модели и определяется

, а корень квадратный из дисперсии называется стандартной ошибкой оценки модели и определяется

(7.6)

(7.6)

Чем ближе  к

к  , тем меньше выражение

, тем меньше выражение  , и, следовательно,

, и, следовательно,  ближе к

ближе к  , поэтому показателем точности подгонки модели к наблюдаемым значениям может служить величина

, поэтому показателем точности подгонки модели к наблюдаемым значениям может служить величина  . Но эта величина зависит от единиц измерения наблюдаемых величин. Если мы ее сделаем безразмерной, разделив на

. Но эта величина зависит от единиц измерения наблюдаемых величин. Если мы ее сделаем безразмерной, разделив на  , то с учетом этого получим.

, то с учетом этого получим.

Величина  показывает долю вариации вследствие регрессии, обозначается

показывает долю вариации вследствие регрессии, обозначается  и называется коэффициентом детерминации. Определяется

и называется коэффициентом детерминации. Определяется

(7.7)

(7.7)

Если используется модель в стандартизованном масштабе, то коэффициент детерминации определяется так.

Корень квадратный из коэффициента детерминации называется множественным коэффициентом корреляции.

Недостатком коэффициента детерминации является то, что при добавлении в модель даже незначимых независимых переменных он увеличивается, поэтому вводится скорректированный коэффициент детерминации, свободный от такого недостатка.

(7.8)

(7.8)

Значимость параметров определяется с помощью  - критерия Стьюдента. Вначале определяются расчетные значения

- критерия Стьюдента. Вначале определяются расчетные значения  - критерия Стьюдента по формуле:

- критерия Стьюдента по формуле:

(7.9)

(7.9)

где  – оценки параметров модели;

– оценки параметров модели;  – стандартные ошибки параметров модели.

– стандартные ошибки параметров модели.

(7.10)

(7.10)

где  – стандартная ошибка модели;

– стандартная ошибка модели;  – диагональные элементы обратной матрицы

– диагональные элементы обратной матрицы  независимых переменных, соответствующие оценкам параметров модели для

независимых переменных, соответствующие оценкам параметров модели для

.

.

Затем  сравниваются с критическим значением из таблицы Стьюдента с выбранным уровнем значимости и степенью свободы

сравниваются с критическим значением из таблицы Стьюдента с выбранным уровнем значимости и степенью свободы  . Если расчетные значения больше критического, то все параметры модели значимы. Если некоторые из параметров модели незначимы, то их исключают из модели и параметры модели определяют вновь.

. Если расчетные значения больше критического, то все параметры модели значимы. Если некоторые из параметров модели незначимы, то их исключают из модели и параметры модели определяют вновь.

Проверка адекватности всей модели, т.е. коэффициента детерминации  осуществляется с помощью критерия Фишера.

осуществляется с помощью критерия Фишера.

(7.11)

(7.11)

где  – дисперсия, отнесенная к регрессии (объясненная дисперсия);

– дисперсия, отнесенная к регрессии (объясненная дисперсия);  – остаточная регрессия.

– остаточная регрессия.

Эта статистика подчиняется распределению Фишера со степенями свободы  . Если при выбранном уровне значимости

. Если при выбранном уровне значимости

, то связь существенна между зависимой и независимыми переменными.

, то связь существенна между зависимой и независимыми переменными.

Для определения наличияавтокорреляции используют критерий Дарбина – Уотсона.

(7.12)

(7.12)

Можно показать, что статистика Дарбина – Уотсона заключена в пределах от 0 до 4, а при отсутствии автокорреляции  . Какие значения, кроме

. Какие значения, кроме  , указывают на отсутствие автокорреляции остатков? Для этого разработаны специальные таблицы критических точек статистики Дарбина–Уотсона с различным уровнем значимости. В ней при заданном уровне значимости

, указывают на отсутствие автокорреляции остатков? Для этого разработаны специальные таблицы критических точек статистики Дарбина–Уотсона с различным уровнем значимости. В ней при заданном уровне значимости  на пересечении столбца, соответствующему количеству независимых переменных

на пересечении столбца, соответствующему количеству независимых переменных  , и строки, соответствующей числу наблюдаемых данных

, и строки, соответствующей числу наблюдаемых данных  , находятся два значения

, находятся два значения  – нижняя граница и

– нижняя граница и  – верхняя граница критических точек. Использование этих границ объясняется следующей схемой. При попадании расчетного значения критерия

– верхняя граница критических точек. Использование этих границ объясняется следующей схемой. При попадании расчетного значения критерия  в одну из указанных границ, делают заключение об отсутствии или наличии автокорреляции.

в одну из указанных границ, делают заключение об отсутствии или наличии автокорреляции.

где 0 – dl – положительная автокорреляция; dl – du – интервал неопределенности; du – 4-du – отсутствие автокорреляции; 4-du – 4-dl – отрицательная автокорреляция.

При попадании расчетного критерия в границы неопределенности, то требуется проведения дополнительных исследований, например взятие первых разностей в исходных данных.

Обнаружение гетероскедастичности – использование графического представления  (ось ординат) и

(ось ординат) и  (ось абсцисс). Если на графике с ростом

(ось абсцисс). Если на графике с ростом  или

или  наблюдается возрастания остатков, то дисперсия постоянная (гомоскедастичность).

наблюдается возрастания остатков, то дисперсия постоянная (гомоскедастичность).

Интерпретация модели. Если построенная модель прошла все проверки, рассмотренные выше, то такую модель можно использовать для анализа и прогноза.

Пусть дана функция  . Приращение независимой переменной

. Приращение независимой переменной  есть

есть  , а относительное приращение независимой переменной

, а относительное приращение независимой переменной  есть

есть  . Соответствующее приращение зависимой переменной

. Соответствующее приращение зависимой переменной  есть

есть  , а относительное приращение зависимой переменной

, а относительное приращение зависимой переменной  есть

есть  .

.

Отношение относительного приращения зависимой переменной к относительному приращению независимой переменной  показывает во сколько раз относительное приращение зависимой переменной больше относительного приращения независимой переменной, или какую долю составляет от независимой переменной. Это выражение может быть выражено в процентах, при умножении числителя и знаменателя на 100% и его можно записать в следующем виде.

показывает во сколько раз относительное приращение зависимой переменной больше относительного приращения независимой переменной, или какую долю составляет от независимой переменной. Это выражение может быть выражено в процентах, при умножении числителя и знаменателя на 100% и его можно записать в следующем виде.

Если существует производная функции  , то

, то

Такой предел называется эластичностью функции и для средних значений зависимой и независимой переменной это выражение можно переписать так.

(7.13)

(7.13)

Для функции многих переменных (множественная регрессия) такой предел называется частными коэффициентами эластичности.

(7.14)

(7.14)

Коэффициенты эластичности показывают, на сколько процентов в среднем изменится значение зависимой переменной  при изменении независимой переменной

при изменении независимой переменной  на

на  .

.

Частный коэффициент детерминации показывает, какую долю вариации зависимой переменной объясняется вариацией  независимой переменной.

независимой переменной.

;

;

Для оценки доли влияния независимой переменной в общем влиянии всех независимых переменных, можно использовать формулу.

Прогнозирование по регрессионным моделям – полученные модели можно использовать для прогнозирования. Обозначим вектор столбец, состоящий из  независимых переменных, по которым мы хотим осуществить прогноз, через

независимых переменных, по которым мы хотим осуществить прогноз, через  . Стандартная ошибка прогноза определяется по формуле.

. Стандартная ошибка прогноза определяется по формуле.

(7.15)

(7.15)

Используя стандартную ошибку прогноза можно вычислить интервал, в котором будет находиться прогнозируемая величина с заданным уровнем значимости и со степенью свободы  из таблицы Стьюдента (

из таблицы Стьюдента ( - для двухсторонней таблицы или

- для двухсторонней таблицы или  – для односторонней).

– для односторонней).

(7.16)

(7.16)

К полученным точечным и интервальным прогнозам нужно относиться крайне осторожно, особенно если в полученную модель подставлять значения независимых переменных, выходящих за границы выборочных данных, так как полученная модель отражает те тенденции, которые сложились в прошлом. Если предположить что данные соотношения не будут кардинально меняться, например технология, численность, трудоемкость и т. п., то можно надеяться на успешный прогноз.

Нелинейные м

и

и  определяется по формуле (7.1).

определяется по формуле (7.1). (7.1)

(7.1) .

.

;

;  ;

;

абсолютно ничего не говорит о направлении причинно-следственных связей, т.е. о том, какая из рассматриваемых переменных является независимой и определяет поведение другой переменной. Эти вопросы должны быть решены в ходе теоретического анализа, т.е. априори. В экономических исследованиях иногда довольно трудно установить причинно-следственные связи. Например, определена положительная связь между уровнем образования и доходом. Можно предположить, что более высокий уровень образования является причиной, а более высокий доход – следствием. Но можно поставить вопрос и по другому, что люди, имеющие более высокие доходы, имеют больше возможностей в получении более высокого уровня образования. Но не исключен и третий вариант, что на эти два исследуемых показателя влияет и ряд других факторов, которыми обладают те или иные индивидуумы (способность, настойчивость в достижении цели и др.).

абсолютно ничего не говорит о направлении причинно-следственных связей, т.е. о том, какая из рассматриваемых переменных является независимой и определяет поведение другой переменной. Эти вопросы должны быть решены в ходе теоретического анализа, т.е. априори. В экономических исследованиях иногда довольно трудно установить причинно-следственные связи. Например, определена положительная связь между уровнем образования и доходом. Можно предположить, что более высокий уровень образования является причиной, а более высокий доход – следствием. Но можно поставить вопрос и по другому, что люди, имеющие более высокие доходы, имеют больше возможностей в получении более высокого уровня образования. Но не исключен и третий вариант, что на эти два исследуемых показателя влияет и ряд других факторов, которыми обладают те или иные индивидуумы (способность, настойчивость в достижении цели и др.). . Причем

. Причем  не коррелированны. Если

не коррелированны. Если  даже взаимно независимы, то индексы

даже взаимно независимы, то индексы  , образованные отношением этих величин к одному и тому же знаменателю

, образованные отношением этих величин к одному и тому же знаменателю  будут коррелированны друг с другом.

будут коррелированны друг с другом. , где

, где  – ошибка коэффициента корреляции, с критическим значением критерия Стьюдента

– ошибка коэффициента корреляции, с критическим значением критерия Стьюдента  с выбранным уровнем значимости

с выбранным уровнем значимости  , равным

, равным  и степенью свободы

и степенью свободы  . Если

. Если  , то парный коэффициент корреляции значим.

, то парный коэффициент корреляции значим. (7.2)

(7.2) – элементы обратной матрицы парных коэффициентов корреляции

– элементы обратной матрицы парных коэффициентов корреляции  и размерностью

и размерностью  ;

;  .

.

.

. , где

, где  - количество элиминированных переменных.

- количество элиминированных переменных.

дол;

дол;  кг.

кг.

с увеличением цены спрос падает.

с увеличением цены спрос падает. ;

;

- критерия находим из таблицы с уровнем значимости

- критерия находим из таблицы с уровнем значимости  и степенью свободы

и степенью свободы

. Так как

. Так как  , то парный коэффициент корреляции значим.

, то парный коэффициент корреляции значим.

между

между  и

и

;

;

;

;

;

;

. Так как

. Так как  можно записать следующим образом.

можно записать следующим образом. .

. - параметры теоретической регрессии, а

- параметры теоретической регрессии, а  - случайная ошибка, представляет собой все те независимые переменные, которые вероятно влияют на

- случайная ошибка, представляет собой все те независимые переменные, которые вероятно влияют на  , где

, где  - оценка параметров

- оценка параметров  . Для нахождения оценок

. Для нахождения оценок  .

.

, то получим.

, то получим.

;

;  (7.3)

(7.3) и ошибки нормально распределены.

и ошибки нормально распределены. и по гистограмме можно визуально установить близко ли распределение ошибок к симметричному с центром равным нулю.

и по гистограмме можно визуально установить близко ли распределение ошибок к симметричному с центром равным нулю. для любого заданного значения

для любого заданного значения  критериям, будут неверны.

критериям, будут неверны. , и на оси абсцисс для одной независимой переменной откладывают

, и на оси абсцисс для одной независимой переменной откладывают  . Если обнаружена гетероскедастичность (рис. 7.7), то применяют взвешенный МНК.

. Если обнаружена гетероскедастичность (рис. 7.7), то применяют взвешенный МНК.

– это допущение означает некоррелированность ошибок. Если это условие не выполняется, то ошибки

– это допущение означает некоррелированность ошибок. Если это условие не выполняется, то ошибки  .

.

– вектор наблюдений зависимых переменных;

– вектор наблюдений зависимых переменных;  – матрица наблюдений независимых переменных;

– матрица наблюдений независимых переменных;  – количество независимых переменных.

– количество независимых переменных. . Для определения

. Для определения  минимизируем сумму квадратов отклонений вектора

минимизируем сумму квадратов отклонений вектора

(7.4)

(7.4) зависимой и независимых переменных и матрицы

зависимой и независимых переменных и матрицы  независимых переменных.

независимых переменных.

стандартизованных коэффициентов регрессии

стандартизованных коэффициентов регрессии  .

. (7.5)

(7.5) коэффициенты. Модель регрессии в стандартизованном масштабе имеет вид:

коэффициенты. Модель регрессии в стандартизованном масштабе имеет вид:

– теоретические стандартизованные значения зависимой переменной, наблюдаемые значения которых получены так

– теоретические стандартизованные значения зависимой переменной, наблюдаемые значения которых получены так  , у которой средняя

, у которой средняя  ;

;  – стандартизованные значения независимых переменных, полученных так

– стандартизованные значения независимых переменных, полученных так  , у которых средние

, у которых средние  и

и  .

. изменятся на величину своего стандартного отклонения

изменятся на величину своего стандартного отклонения  , то зависимая переменная

, то зависимая переменная  изменится на величину

изменится на величину  .

. и разделив на эту величину остальные

и разделив на эту величину остальные

имеет полный ранг

имеет полный ранг  близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. Признаки мультиколлинеарности таковы:

близка к вырожденной. Тогда говорят о наличии мультиколлинеарности. Признаки мультиколлинеарности таковы: критерию значима;

критерию значима; собственного значения матрицы от

собственного значения матрицы от  .

. попарно линейно независимы, то корреляционная матрица является единичной, следовательно, ее обратная матрица также является единичной. Выборочная корреляционная матрица и ее обратная отличаются от единичной матрицы. На этом свойстве основан предложенный ими критерий, который подчиняется распределению Фишера с

попарно линейно независимы, то корреляционная матрица является единичной, следовательно, ее обратная матрица также является единичной. Выборочная корреляционная матрица и ее обратная отличаются от единичной матрицы. На этом свойстве основан предложенный ими критерий, который подчиняется распределению Фишера с  степенями свободы.

степенями свободы.

– диагональные элементы обратной корреляционной матрицы независимых переменных;

– диагональные элементы обратной корреляционной матрицы независимых переменных;  , то принимается гипотеза отсутствия мультиколлинеарности

, то принимается гипотеза отсутствия мультиколлинеарности  независимой переменной с остальными независимыми переменными при уровне значимости a=0.05, а если

независимой переменной с остальными независимыми переменными при уровне значимости a=0.05, а если  , то принимается гипотеза присутствия мультиколлинеарности

, то принимается гипотеза присутствия мультиколлинеарности  между независимой переменной и остальными независимыми переменными, определенный как

между независимой переменной и остальными независимыми переменными, определенный как  (Variance Inflation Factor).

(Variance Inflation Factor).

, то

, то  , то

, то  , то

, то  . Определив

. Определив  – это свидетельствует о наличии мультиколлинеарности между

– это свидетельствует о наличии мультиколлинеарности между

– собственные значения исследуемой матрицы независимых переменных.

– собственные значения исследуемой матрицы независимых переменных.

.

.

. Учитывая это, получим.

. Учитывая это, получим.

обозначим его

обозначим его  , равен сумме квадратов вариации вследствие регрессии

, равен сумме квадратов вариации вследствие регрессии  , обозначим его

, обозначим его  и слагаемого, которое называется суммой квадратов ошибок

и слагаемого, которое называется суммой квадратов ошибок  , обозначим

, обозначим  , тогда это выражение можно переписать так.

, тогда это выражение можно переписать так.

по выборке определить не возможно, оно заменяется выборочной несмещенной дисперсией

по выборке определить не возможно, оно заменяется выборочной несмещенной дисперсией  , а корень квадратный из дисперсии называется стандартной ошибкой оценки модели и определяется

, а корень квадратный из дисперсии называется стандартной ошибкой оценки модели и определяется (7.6)

(7.6) к

к

показывает долю вариации вследствие регрессии, обозначается

показывает долю вариации вследствие регрессии, обозначается  (7.7)

(7.7)

(7.8)

(7.8) (7.9)

(7.9) – оценки параметров модели;

– оценки параметров модели;  – стандартные ошибки параметров модели.

– стандартные ошибки параметров модели. (7.10)

(7.10) – стандартная ошибка модели;

– стандартная ошибка модели;  – диагональные элементы обратной матрицы

– диагональные элементы обратной матрицы

.

. сравниваются с критическим значением из таблицы Стьюдента с выбранным уровнем значимости и степенью свободы

сравниваются с критическим значением из таблицы Стьюдента с выбранным уровнем значимости и степенью свободы  . Если расчетные значения больше критического, то все параметры модели значимы. Если некоторые из параметров модели незначимы, то их исключают из модели и параметры модели определяют вновь.

. Если расчетные значения больше критического, то все параметры модели значимы. Если некоторые из параметров модели незначимы, то их исключают из модели и параметры модели определяют вновь. (7.11)

(7.11) – дисперсия, отнесенная к регрессии (объясненная дисперсия);

– дисперсия, отнесенная к регрессии (объясненная дисперсия);  – остаточная регрессия.

– остаточная регрессия. . Если при выбранном уровне значимости

. Если при выбранном уровне значимости  , то связь существенна между зависимой и независимыми переменными.

, то связь существенна между зависимой и независимыми переменными. (7.12)

(7.12) . Какие значения, кроме

. Какие значения, кроме  – нижняя граница и

– нижняя граница и  – верхняя граница критических точек. Использование этих границ объясняется следующей схемой. При попадании расчетного значения критерия

– верхняя граница критических точек. Использование этих границ объясняется следующей схемой. При попадании расчетного значения критерия  в одну из указанных границ, делают заключение об отсутствии или наличии автокорреляции.

в одну из указанных границ, делают заключение об отсутствии или наличии автокорреляции.

(ось ординат) и

(ось ординат) и  (ось абсцисс). Если на графике с ростом

(ось абсцисс). Если на графике с ростом  или

или  . Приращение независимой переменной

. Приращение независимой переменной  есть

есть  , а относительное приращение независимой переменной

, а относительное приращение независимой переменной  . Соответствующее приращение зависимой переменной

. Соответствующее приращение зависимой переменной  , а относительное приращение зависимой переменной

, а относительное приращение зависимой переменной  .

. показывает во сколько раз относительное приращение зависимой переменной больше относительного приращения независимой переменной, или какую долю составляет от независимой переменной. Это выражение может быть выражено в процентах, при умножении числителя и знаменателя на 100% и его можно записать в следующем виде.

показывает во сколько раз относительное приращение зависимой переменной больше относительного приращения независимой переменной, или какую долю составляет от независимой переменной. Это выражение может быть выражено в процентах, при умножении числителя и знаменателя на 100% и его можно записать в следующем виде.

(7.13)

(7.13) (7.14)

(7.14) .

. ;

;

. Стандартная ошибка прогноза определяется по формуле.

. Стандартная ошибка прогноза определяется по формуле. (7.15)

(7.15) – для односторонней).

– для односторонней). (7.16)

(7.16)