Согласно комбинаторному определению количества информации для установления записанного в регистр двоичного числа, имеющего п разрядов, требуется п двоичных единиц информации (по одной двоичной единице или по одному двоичному вопросу на выяснение содержания каждого разряда). Определить записанное в регистр число посредством задания меньшего числа вопросов, получив меньшее количество информации, невозможно, если мы об этом числе ничего, кроме того, что оно записано в регистр, не знаем. Количество необходимой информации можно уменьшить только в том случае, если мы будем располагать некоторыми априорными сведениями о числе, в частности, о способе его записи (генерации).

Допустим, некоторое устройство вырабатывает (генерирует) число как независимую последовательность из единиц и нулей, которые появляются соответственно с вероятностями, равными р и q= 1— р. В этом случае при неограниченном возрастании длины последовательности п с вероятностью, равной единице, появляются последовательности, количество единиц в которых незначительно отличается от среднего значения, равного пр. Такие последовательности называются типичными. Они различаются между собой в основном только размещением единиц, а не их количеством. Поскольку количество типичных последовательностей Q меньше общего количества последовательностей, то имеется возможность уменьшить количество информации, необходимое для определения числа.

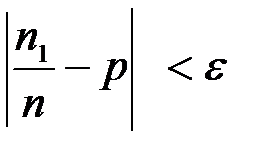

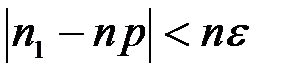

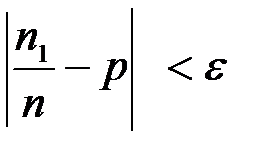

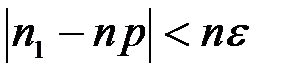

Последовательность назовем типичной для заданного источника, если количество единиц n в ней удовлетворяет неравенству

или

или  (4.1)

(4.1)

и нетипичной в противном случае, то есть когда

(4.2)

(4.2)

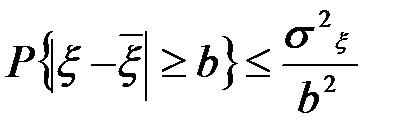

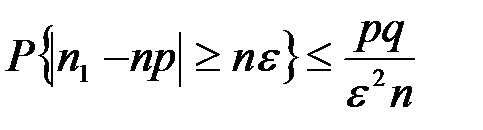

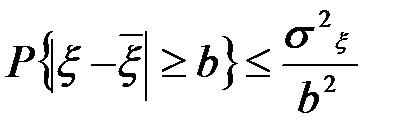

Вероятность появления нетипичной последовательности равна вероятности, с которой n1 удовлетворяет неравенству (4.2). Для оценки этой вероятности воспользуемся неравенством Чебышева, которое для произвольной случайной величины ξ, имеющей конечную дисперсию, при каждом b>0 записывается в виде

,

,

где  и

и  — соответственно математическое ожидание и дисперсия случайной величины

— соответственно математическое ожидание и дисперсия случайной величины  . Полагая

. Полагая  =n1,

=n1,  =

=  =пр, b=

=пр, b=  n,

n,  =

=  =npq (q=( 1—p)), получим аналогичное неравенство для случайного числа единиц n1

=npq (q=( 1—p)), получим аналогичное неравенство для случайного числа единиц n1

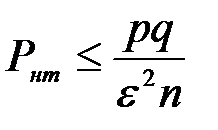

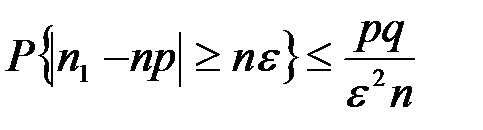

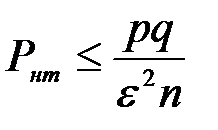

Следовательно, вероятность появления нетипичной последовательности

,

,

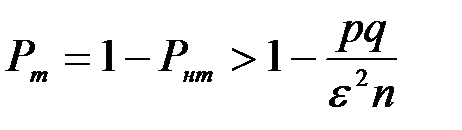

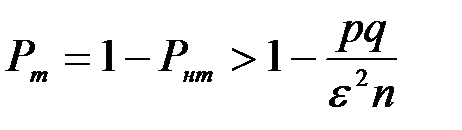

а вероятность появления типичной последовательности

.

.

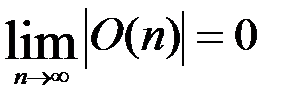

Вероятность Рнт стремится к нулю, а вероятность Рт стремится к единице при любом сколь угодно малом значении ε и неограниченном возрастании длины последовательности п. Интервал [- п  , п

, п  ], которому принадлежит количество единиц в типичной последовательности, неограниченно увеличивается (п

], которому принадлежит количество единиц в типичной последовательности, неограниченно увеличивается (п  →

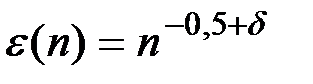

→  ), хотя относительная величина интервала всегда меньше значения ε. Докажем, что одновременно с неограниченным увеличением длины последовательности п можно уменьшать значение

), хотя относительная величина интервала всегда меньше значения ε. Докажем, что одновременно с неограниченным увеличением длины последовательности п можно уменьшать значение  =

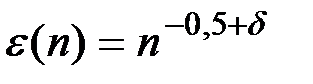

=  (n) с такой скоростью, при которой относительная величина интервала будет стремиться к нулю, а вероятность появления типичной последовательности — к единице. При этом абсолютная величина интервала по-прежнему неограниченно возрастает. Вероятность РТ стремится к единице, если величина

(n) с такой скоростью, при которой относительная величина интервала будет стремиться к нулю, а вероятность появления типичной последовательности — к единице. При этом абсолютная величина интервала по-прежнему неограниченно возрастает. Вероятность РТ стремится к единице, если величина  2(п)п неограниченно увеличивается с ростом п. Пусть

2(п)п неограниченно увеличивается с ростом п. Пусть  2(п)п=

2(п)п=  , где

, где  >0 — некоторый параметр, определяющий скорость роста величины

>0 — некоторый параметр, определяющий скорость роста величины  2(п)п. Отсюда

2(п)п. Отсюда  , (0<

, (0<  <0,5).

<0,5).

Величина  (п) стремится к нулю с ростом п при

(п) стремится к нулю с ростом п при  <0,5. При этом абсолютная величина интервала п

<0,5. При этом абсолютная величина интервала п  (п) не может быть постоянной или стремиться к нулю одновременно с неограниченным увеличением величины

(п) не может быть постоянной или стремиться к нулю одновременно с неограниченным увеличением величины  2(п)п, стремлением

2(п)п, стремлением  (п) к нулю.

(п) к нулю.

Определим количество типичных последовательностей Q.

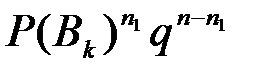

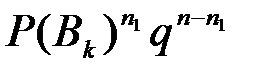

Вероятность появления произвольной последовательности Bk равна  .

.

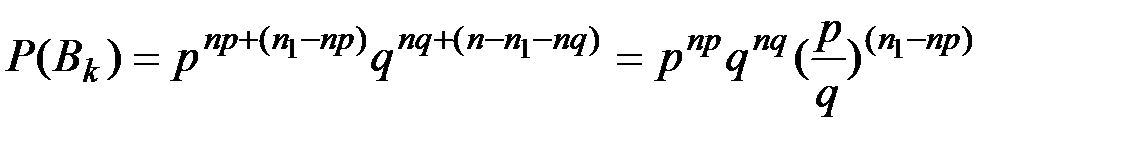

В результате тождественных преобразований  .

.

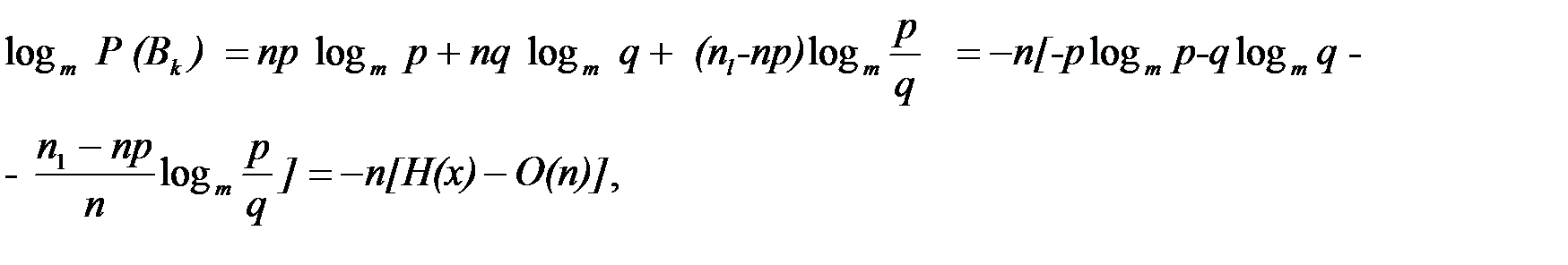

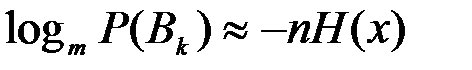

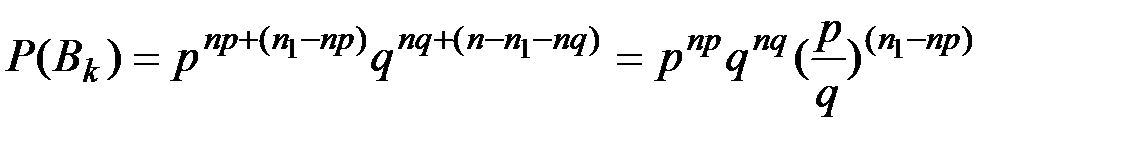

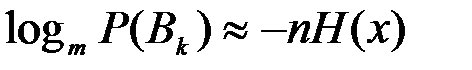

Прологарифмировав последнее равенство, получим

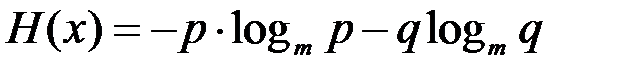

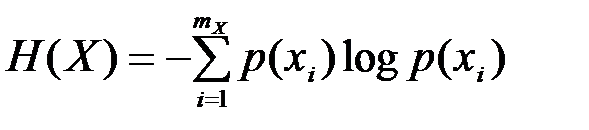

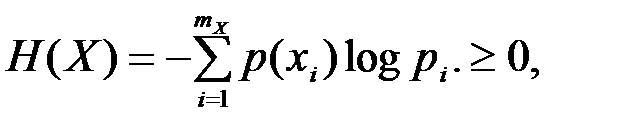

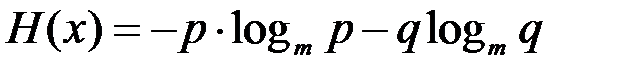

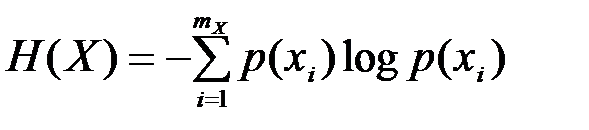

где величин  является характеристикой источника сообщений и называется энтропией.

является характеристикой источника сообщений и называется энтропией.

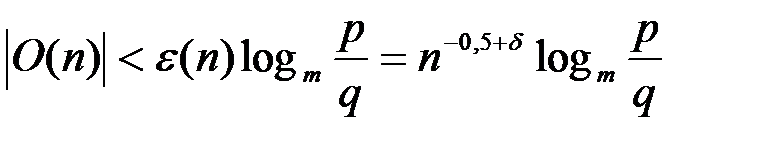

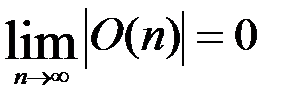

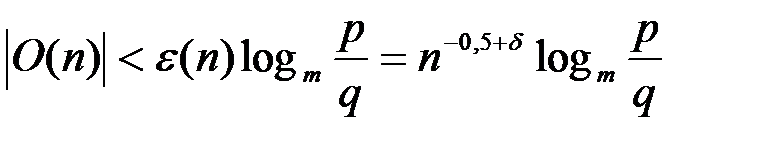

Покажем, что в случае типичных последовательностей остаточным членом О(п) по сравнению с величиной Н(Х) можно пренебречь.

Поскольку для типичных последовательностей справедливо неравенство  ,то

,то

Следовательно,

Таким образом, при достаточно большом п справедливо приближенное равенство  .

.

Отсюда вероятность появления отдельной типичной последовательности

P(Bk)  m-nH(X)

m-nH(X)

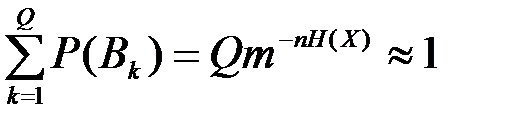

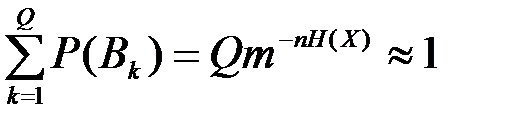

Поскольку правая часть равенства не зависит от номера типичной последовательности k, то все типичные последовательности примерно равновероятны. Вероятность появления типичной последовательности

Рт=  ,

,

где суммирование ведется по всему множеству типичных последовательностей. Отсюда:

Q=mnH(X)

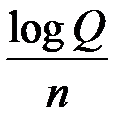

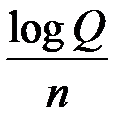

причем единица измерения энтропии Н(Х) совпадает с основанием степени т. Поскольку количество информации, необходимое для определения состояния регистра, равно log Q, то энтропия

Н(Х) =  равна количеству информации, которое необходимо для определения состояния одного разряда.

равна количеству информации, которое необходимо для определения состояния одного разряда.

Аналогично определяется количество типичных последовательностей, вырабатываемых источником с алфавитом размера mx, только в этом случае энтропия  .

.

Свойства энтропии

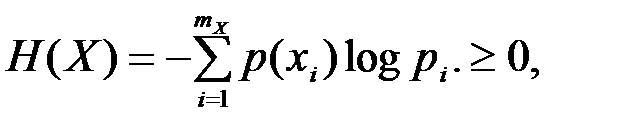

Энтропия  поскольку pi удовлетворяет неравенству 0

поскольку pi удовлетворяет неравенству 0  1. Энтропия H(X)=0, когда система находится в одном из состояний с вероятностью, равной единице, и во всех остальных — с вероятностью, равной нулю. При этом имеется в виду, что

1. Энтропия H(X)=0, когда система находится в одном из состояний с вероятностью, равной единице, и во всех остальных — с вероятностью, равной нулю. При этом имеется в виду, что

pilog pi=0.

pilog pi=0.

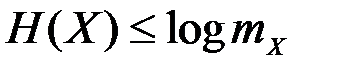

При равномерном распределении (pi=  ) энтропия H(X)=logmx

) энтропия H(X)=logmx

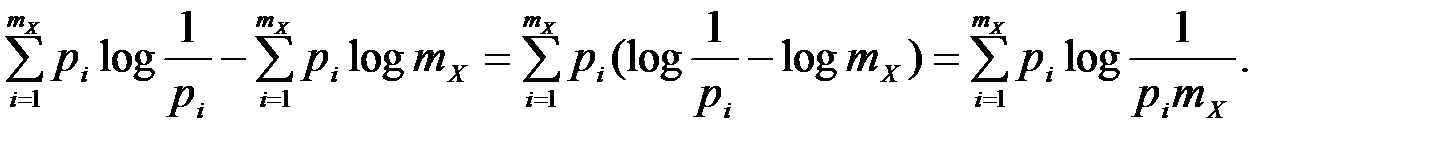

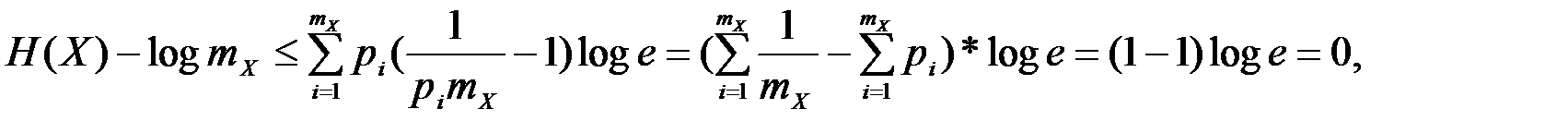

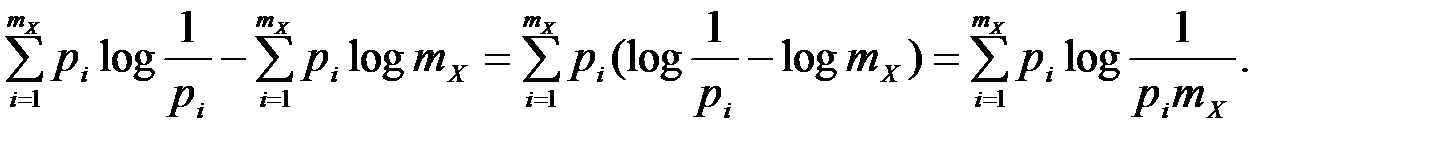

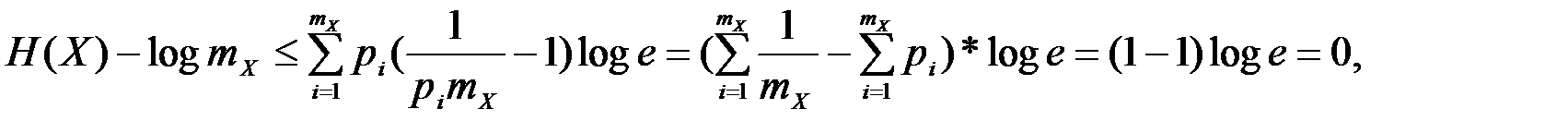

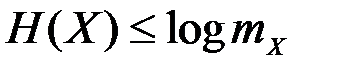

Докажем, что это максимальное значение энтропии. Используя равенство  =1, можно выполнить следующие тождественные преобразования:

=1, можно выполнить следующие тождественные преобразования:

Н(Х)-logmX=

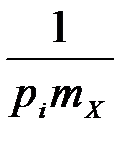

Для оценки выражения log  воспользуемся неравенством

воспользуемся неравенством

lnz  z—1, положив z=

z—1, положив z=  .

.

Рис. 4.1. Энтропия системы с двумя состояниями: р – вероятность одного из состояний

Заменяя  на

на  , получим

, получим

где log e —модуль перехода. Отсюда

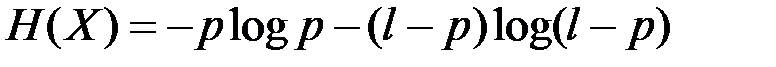

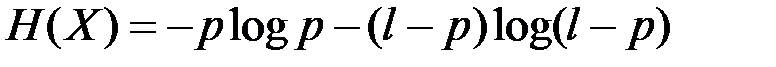

Пусть множество состоит из двух элементов, которые обозначим через единицу и ноль, причем единица появляется с вероятностью, равной р, а ноль — с вероятностью, равной q=1 — р. Тогда

.

.

Указанная зависимость изображена на рис. 1. Максимум достигается при p=q= 0,5.

Ценность информации

Все определения ценности информации связаны с понятием цели. Ценной считается та информация, которая способствует достижению поставленной цели.

Один из способов измерения ценности информации, сформулированный в рамках статистической теории информации, был предложен А.А.Харкевичем [3]. Ценность информации может быть выражена через приращение вероятности достижения цели. Если значение априорной вероятности достижения цели обозначить через р1, а апостериорной — через p2, то ценность полученной информации можно определить как log  .

.

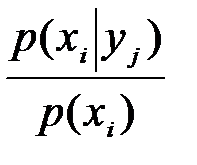

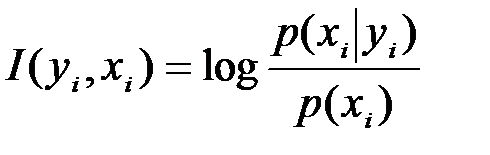

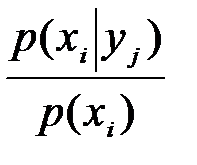

В системах передачи информации цель сводится к правильной передаче сообщений независимо от их конкретного содержания и формулируется относительно каждого символа множества X. Пусть целью является принятие решения в пользу xi. Тогда относительно этой цели ценность сведений,содержащихся в принятом yj равна log  , где P(xi) — априорная вероятность передачи хi; p(xi|yj) — вероятность того, что было передано xi после принятия yj. При такой формулировке цели ценность информации совпадает с обычным количеством информации, которое определено выше.

, где P(xi) — априорная вероятность передачи хi; p(xi|yj) — вероятность того, что было передано xi после принятия yj. При такой формулировке цели ценность информации совпадает с обычным количеством информации, которое определено выше.

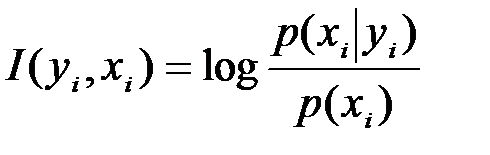

Таким образом, количество информации, которое уi несет об xi, равно

.

.

Умножая числитель и знаменатель под логарифмом на р{уj) и учитывая равенства

p(xi|yj)p(yj)= p(xi, yj)= p(yj |xi)р(хi),

получим

(4.3)

(4.3)

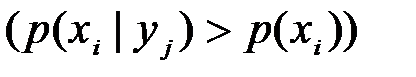

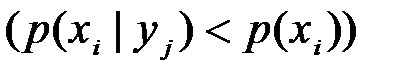

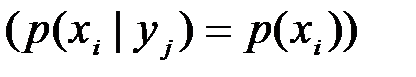

Отсюда следует, что yj несет об такое же количество информации, какое хi несет об yj (свойство симметрии). Поэтому I(хi, yj) называется взаимным количеством информации между i-м символом множества X и j-м символом множества У. Взаимное количество информации I(хi, yj), может быть положительным  , отрицательным

, отрицательным  и равным нулю

и равным нулю  . Отрицательная информация называется дезинформацией.

. Отрицательная информация называется дезинформацией.

или

или  (4.1)

(4.1) (4.2)

(4.2) ,

, и

и  — соответственно математическое ожидание и дисперсия случайной величины

— соответственно математическое ожидание и дисперсия случайной величины  . Полагая

. Полагая  =n1,

=n1,  =пр, b=

=пр, b=  n,

n,  =npq (q=( 1—p)), получим аналогичное неравенство для случайного числа единиц n1

=npq (q=( 1—p)), получим аналогичное неравенство для случайного числа единиц n1

,

, .

. , п

, п  ], которому принадлежит количество единиц в типичной последовательности, неограниченно увеличивается (п

], которому принадлежит количество единиц в типичной последовательности, неограниченно увеличивается (п  ), хотя относительная величина интервала всегда меньше значения ε. Докажем, что одновременно с неограниченным увеличением длины последовательности п можно уменьшать значение

), хотя относительная величина интервала всегда меньше значения ε. Докажем, что одновременно с неограниченным увеличением длины последовательности п можно уменьшать значение  , где

, где  >0 — некоторый параметр, определяющий скорость роста величины

>0 — некоторый параметр, определяющий скорость роста величины  , (0<

, (0<  <0,5).

<0,5). (п) не может быть постоянной или стремиться к нулю одновременно с неограниченным увеличением величины

(п) не может быть постоянной или стремиться к нулю одновременно с неограниченным увеличением величины  .

. .

.

является характеристикой источника сообщений и называется энтропией.

является характеристикой источника сообщений и называется энтропией. ,то

,то

.

. m-nH(X)

m-nH(X) ,

, равна количеству информации, которое необходимо для определения состояния одного разряда.

равна количеству информации, которое необходимо для определения состояния одного разряда. .

. поскольку pi удовлетворяет неравенству 0

поскольку pi удовлетворяет неравенству 0  1. Энтропия H(X)=0, когда система находится в одном из состояний с вероятностью, равной единице, и во всех остальных — с вероятностью, равной нулю. При этом имеется в виду, что

1. Энтропия H(X)=0, когда система находится в одном из состояний с вероятностью, равной единице, и во всех остальных — с вероятностью, равной нулю. При этом имеется в виду, что pilog pi=0.

pilog pi=0. ) энтропия H(X)=logmx

) энтропия H(X)=logmx =1, можно выполнить следующие тождественные преобразования:

=1, можно выполнить следующие тождественные преобразования:

воспользуемся неравенством

воспользуемся неравенством z—1, положив z=

z—1, положив z=  .

. на

на  , получим

, получим

.

. .

. , где P(xi) — априорная вероятность передачи хi; p(xi|yj) — вероятность того, что было передано xi после принятия yj. При такой формулировке цели ценность информации совпадает с обычным количеством информации, которое определено выше.

, где P(xi) — априорная вероятность передачи хi; p(xi|yj) — вероятность того, что было передано xi после принятия yj. При такой формулировке цели ценность информации совпадает с обычным количеством информации, которое определено выше. .

. (4.3)

(4.3) , отрицательным

, отрицательным  и равным нулю

и равным нулю  . Отрицательная информация называется дезинформацией.

. Отрицательная информация называется дезинформацией.