Знания как основа принятия решений

Принятие решений – генерация возможных альтернативных решений, оценка этих альтернатив и выбор наилучшего решения.

Поддержка ПР – информация (книги, опыт др. людей).

Задача ИИ – поддержка управленческих решений.

Принять решение – выбрать такую альтернативу из числа возможных, которая с учетом всех разнообразных и противоречивых требований будет максимально способствовать достижению поставленной цели (оптимизация). Множество альтернатив человек формирует сам.

Неотъемлемой частью ПР является неопределенность в выборе альтернатив. Для снятия неопределенности нужна объективная оценка ситуации, основанная на знании. Знания основываются на инфе относительно состояния проблемной области, которой располагает ЛПР.

Инфа – это то, что позволяет принять решение или осознанный выбор. Инф-ые ед-цы – это элементы инфы.

Свойства знаний:

1) внутренняя интерпретируемость (каждая структурная единица должна иметь уникальное имя и однозначно определяться)

2) структурируемость – м\у инф-ыми ед-цами д.б. установлены определенные отношения (отношение типа «часть-целое», «род - вид» и т.д.)

Знания должны определяться как система (некоторое множество элементов, позволяющее получить новые свойства). Знания должны представлять собой систему. Управлять можно только при наличии систематических знаний. Системы ИИ – это системы, в основе которых лежат знания.

Понятие «система»

Система – некоторое множество элементов, позволяющее получить новые свойства.

Система – это перечисление ее свойств.

Свойства:

1) Система д.б. разделима на подсистемы, к-ые тоже м.б.разделены и т.д., вплоть до элементов. Элемент – это такая часть системы, внутрь которой описание не проникает. Понятие «элемент» зависит от поставленной задачи (от глубины описания).

2) Наличие сильных и устойчивых связей м\у эл-ми, сила к-ых значительно превосходит силу связей эл-ов с окружающей средой.

3) Наличие структуры (организации) – наличие упорядоченных в пр-ве и во времени эл-ов, подсистем и связей м\у ними.

4) Наличие системного эффекта – это свойство, присущее только системе в целом и отсутствующее у каждого из ее элементов. Надежная система м.б. построена из ненадежных элементов (при определенной организации).

5) Наличие цели функционирования. Цель биологического объекта – жить и продолжать род. Цель интеллектуальной системы закладывается при проектировании.

6) Наличие окружающей среды (любая система способна функционировать только в окружающей среде; обмениваясь при этом инфой, энергией, материей одновременно)

3. Понятия «данные», «инфа», «знания» и связь м\у ними

Инфа основывается на данных, т.е. на элементах описания предметной области.

Данные + Процедуры обработки = Инфа

Инфа + Процедуры обработки = Знания

Пример: Read Only Memory – символьные данные.

читать только память (интеллектуальный переводчик) или память только для чтения - альтернативы. Данные сопоставляем со словарем и получаем инфу (понятные данные). Нужны дополнительные внешние знания о правилах перевода, они не содержаться в данной фразе. Применяя внешние знания о правилах перевода к переведенным словам, получаем знания.

Формула Вирта: Программа = Алгоритм обработки + Исходные данные.

Данные будут поняты только тогда, когда к ним будет применен алгоритм обработки.

Данные (декларативные) – это характеристика проблемной области.

Процедурные знания в алгоритме – это как обработать данные, атрибуты, способ их обработки.

Пример: Часы показывают 12.15. В мозг передается сигнал, в мозге формируется изображение; данные соотносятся со шкалой времени и => получили инфу. Человек подключил внешние знания и сравнивает с к.-л. событием (расписание занятий) => знания: опаздывает.

Знания не содержатся в исходных данных. Знания возникают в результате сопоставления элементов инфы (о времени и о расписании). И затем принимается решение.

Формализованные знания. Сущность и сферы использования. Примеры.

Формализованные знания формируют в виде строгих суждений, образующих так называемую формализованную систему. Задачи формализованной системы – в конкретной ситуации определять степень истинности каждого из этих суждений. Формализованные знания – связка элементов.

F=<A, P, X, I>.

A–алфавит – набор символов, из которых строятся предложения формализованных систем, Р – синтаксические правила построения предложений из алфавита А, Х – аксиомы, т.е. тождественно истинные предложения.

Пример: аксиоматическая теория вероятности Колмагорова.

По фон-Мезесу: вероятность – это m\n, (где m – количество успехов, n – количество экспериментов) при соблюдении условия однородности. Условия статистической устойчивости: m\n – частота и она приблизительно равна m`\n`. Где n`<n. При этом последовательность n` должна выбираться заранее, до опытов. Можно выбирать в качестве n` только успешные или только неуспешные события. m\n – это способ измерения.

При аксиоматическом определении вероятности, вероятность задается перечислением ее свойств. Выбираем из частоты m\n только существенные свойства.

Свойства:

1) m\n > 0 - Частота неотрицательная величина.

2) Если событие появляется при каждом испытании, т.е. оно достоверно при любых n, то m=n и m\n=1.

3) Если m1 результатов испытаний из n испытаний привело к появлению события А, а m2 результатов испытаний повлекли событие В, при этом события А и В не появились одновременно (ни в одном из n испытаний), то частота появления события, состоящего в появлении либо А либо В: m\n= m1\n + m2\n.

Вероятностью появления события называется численная мера возможности наступления этого события при некотором испытании.

Формулировка аксиом: 1) для каждого случайного события А определена его вероятность, причем она неотрицательная. Р(А)>=0.

2) для достоверного события А имеет место равенство: Р(А)=1.

3) если события А и В не совместны, т.е.  , то вероятность совместного наступления этих событий

, то вероятность совместного наступления этих событий  .

.

Множество – это некоторая совокупность, для каждого элемента которой можно указать => правила: 1) принадлежит ли некоторый элемент данной совокупности или нет. 2) позволяет отличить элементы друг от друга внутри совокупности.

Пример: докажем некоторые формулировки.

1) вероятность невозможного события = 0. Определим  как множество элементарных событий.

как множество элементарных событий.  , - по 3-ей аксиоме.

, - по 3-ей аксиоме.  .

.

Вывод: любая формальная система содержит аксиомы и правила вывода (помимо алфавита). Достоинства формализованных знаний: пригодны для алгоритмизации. Недостатки: эти формализованные знания слишком «точны», жестки для описания реального мира. Человеческое восприятие и понимание мира гораздо сложнее того, что можно описать с помощью формальных систем (знаний).

Механизм логического вывода в продукционных системах. Примеры логического вывода

Выполняет 2 функции:

1)Просмотр существующих фактов из БД и правил из базы правил и добавление в рабочую память новых фактов.

2)Определение порядка просмотра и применение правил.

Существуют 2 способа вывода:прямой (от факта к заключению) и обратный (заключения последовательно просматриваются до тех пор, пока в рабочей памяти не будут обнаружены или не буду т получены от пользователя факты, подтверждающие одно из заключений.

Пример: Возьмем 2 правила

П1: Если сбой подачи питания И сетевой фильтр включен, ТО сгорел предохранитель.

П2: Если лампочка питания не горит, ТО сбой подачи питания.

факты от пользователя: лампочка питания не горит, сетевой фильтр включен

Процесс прямого вывода:

1) Цикл П1-не срабатывает; П2 срабатывает

2) Действие сработавшего П2: заносится в БД заключение правила П2 «Сбой подачи питания»; П2-отработавшее

Второй цикл сопоставления фактов и правил:

3) П1 срабатывает

4) Заключение П1 «Сгорел предохранитель» является результатом вывода, так как база правил исчерпана

Процесс обратного вывода:

1) Начинается с гипотезы «Сгорел предохранитель»

2) Ищем правило, заключение которого соответствует выдвинутой гипотезе. Это П1.

3) Проверяем, срабатывает ли это правило. П1 не срабатывает так как в рабочей памяти нет факта «Сбой подачи питания» =>

4) Ищем правило, в заключении которого «Сбой подачи питания»

5) Проверяем, срабатывает ли это правило. П2 срабатывает.

6) В рабоч память заносится факт «Сбой подачи питания»

7) Опять цикл просмотра правил: П1 срабатывает

8) Выдвинутая гипотеза подтверждается фактами.

Нечеткие отношения.

Пусть Е = Е1хЕ2х...хЕn - прямое произведение n универсальных множеств и М - некоторое множество принадлежностей (М = [0,1]). Нечетким n-арным отношеним наз-ют нечеткое подмножество R, заданное на E, принимающее свои значения на М.

В случае n=2 (отношение бинарное) и М = [0,1], нечетким отношением R между множествами X = Е1 и Y = Е2 будет называться функция R: (Х,Y)->[0,1], которая ставит в соответствие каждой паре элементов (х,y) э Х*Y величину µR(х,y) э [0,1]. Обозначение: нечеткое отношение на X*Y запишется в виде: xэX, yэY: xRy. В случае, когда X = Y, т.е. X и Y совпадают, нечеткое отношение R: X*X->[0,1] называется нечетким отношением на множестве X.Носителем нечеткого отношения R называется обычное множество упорядоченных пар (x,y), для которых функция принадлежности положительна: S(R) ={(x,y): µR (x,y)>0}. Пусть R1 и R2 - два нечетких отношения такие, что:для любого (x,y) э X * Y: µR1 (x,y)≤ µR2 (x,y),

тогда говорят, что R2 содержит R1 или R1 содержится в R2.

Объединение двух отношений обозначается R1υR2 и определяется выражением:

µR1 υ R2 (x,y) = µR1 (x,y) V µR2 (x,y).

Пересечение двух отношений R1 и R2 обозначается R1 ∩ R2 и определяется выражением:

µR1 ∩ R2 (x,y) = µR1 (x,y) ∩ µR2 (x,y).

Алгебраическое произведение двух отношений R1 и R2 обозначается R1×R2 и определяется выражением:

µR1×R2 (x,y) = µR1 (x,y)× µR2 (x,y).

Алгебраическая сумма двух отношений R1 и R2 обозначается R1  R2 и определяется выражением:

R2 и определяется выражением:  .

.

Для введенных операций справедливы следующие свойства дистрибутивности:

R1∩(R2υR3) = (R1∩R2)υ(R1∩R3),

R1υ(R2∩R3) = (R1υR2)∩(R1υR3),

R1×(R2υR3) = (R1×R2)υ(R1×R3),

R1×(R2∩R3) = (R1×R2)∩(R1×R3),

R1  (R2υR3) = (R1

(R2υR3) = (R1  R2)υ(R1

R2)υ(R1  R3),

R3),

R1  (R2∩R3) = (R1

(R2∩R3) = (R1  R2)∩ (R1

R2)∩ (R1  R3).

R3).

Дополнение отношения R обозначается  и определяется функцией принадлежности:

и определяется функцией принадлежности:

(x,y) = 1 - µR (x,y)

(x,y) = 1 - µR (x,y)

Нечеткие аппроксиматоры.

При аппроксиматор в простейшем случае представляет собой элемент с несколькими скалярными входами и одним выходом, выполняющий нелинейное параметрическое преобразование суммарного взвешенного входного сигнала в скалярную величину

У=f(Х1, Х2,…, Хm)+ е

f- неизвестная функция.

Над объектом выполняются N испытаний, в итоге получаем N пар значений (хk,Yk), где k изменяется от 1 до N, и хk- вектор.

Затем 1) из общего числа N пар выбираются n<N пар (хk,Yk) и из них составляется начальная база знаний в виде матрицы

Х11 Х12 …… Х1m, Y1

…

Хn1 Хn2 …… Хnm, Yn

Каждая строка – одно правило.

2) для каждой экспериментальной точки (хk,Yk), рассчитывают прогнозируемое значение по формуле Сугено 1го порядка (//в формуле все х – векторы)

γ()- многомерная функция Гаусса

|| || - символ эвклидова расстояния.

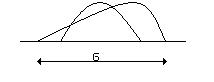

Получаем колокообразную функцию принадлежности типа функции Гаусса.

σ – размах колокола

σ – размах колокола

3)n- используется в качестве базы правил

d- заданная погрешность аппроксимации

| ŷ- y|>d

При выполнении этого неравенства матрица расширяется за счет дополнительной строки: (х, ŷ).

4) условие остановки: если все N точек перебраны в соответствии с подпунктами 2 и 3 (кроме значений начальной БЗ), то построение модели заканчивается. Иначе переходим к шагу 2.

Параметры σ и d задаются до начала эксперимента.

Биологический нейрон.

Центральная нервная система имеет клеточное строение. Единица – нервная клетка, нейрон. Нейрон имеет следующие основные свойства:

1. Участвует в обмене веществ и рассеивает энергию. Меняет внутреннее состояние с течением времени, реагирует на входные сигналы и формирует выходные воздействия и поэтому является активной динамической системой.

2. Имеет множество синапсов – контактов для передачи информации.

3. Нейрон взаимодействует путем обмена электрохимическими сигналами двух видов: электротоническими (с затуханием) и нервными импульсами (спайками), распространяющимися без затуания.

Нервная система человека, построенная из элементов, называемых нейронами, имеет ошеломляющую сложность. Около 1011 нейронов участвуют в примерно 1015 передающих связях, имеющих длину метр и более. Каждый нейрон обладает многими качествами, общими с другими элементами тела, но его уникальной способностью является прием, обработка и передача электрохимических сигналов по нервным путям, которые образуют коммуникационную систему мозга.

Рис. 1.1. Биологический нейрон

На рис. 1.1 показана структура пары типичных биологических нейронов. Дендриты идут от тела нервной клетки к другим нейронам, где они принимают сигналы в точках соединения, называемых синапсами. Принятые синапсом входные сигналы подводятся к телу нейрона. Здесь они суммируются, причем одни входы стремятся возбудить нейрон, другие – воспрепятствовать его возбуждению. Когда суммарное возбуждение в теле нейрона превышает некоторый порог, нейрон возбуждается, посылая по аксону сигнал другим нейронам. У этой основной функциональной схемы много усложнений и исключений, тем не менее большинство искусственных нейронных сетей моделируют лишь эти простые свойства.

Биологический нейрон 2

Нейрон (нервная клетка) состоит из тела клетки - сомы (soma), и двух типов внешних древовидных ответвлений: аксона (axon) и дендритов (dendrites). Тело клетки содержит ядро (nucleus), где находится информация про свойства нейрона, и плазму, которая производит необходимые для нейрона материалы. Нейрон получает сигналы (импульсы) от других нейронов через дендриты (приемника) и передает сигналы, сгенерированные телом клетки, вдоль аксона (передатчик), который в конце разветвляется на волокна (strands). На окончаниях волокон находятся синапсы (synapses).

Рис. 1. Схема биологического нейрона.

Синапс является функциональным узлом между двумя нейронами (волокно аксона одного нейрона и дендрит другого). Когда импульс достигает синаптического окончания, вырабатываются химические вещества, называемые нейротрансмиттерами. Нейротрансмиттери проходят через синаптичную щель, и в зависимости от типа синапса, возбуждая или тормозя способность нейрона-приемника генерировать электрические импульсы. Результативность синапса настраивается проходящими через него сигналами, поэтому синапсы обучаются в зависимости от активности процессов, в которых они принимают участие. Нейроны взаимодействуют с помощью короткой серии импульсов. Сообщение передается с помощью частотно-импульсной модуляции.

Последние экспериментальные исследования доказывают, что биологические нейроны структурно сложнее, чем упрощенное объяснение существующих искусственных нейронов, которые являются элементами современных искусственных нейронных сетей. Поскольку нейрофизиология предоставляет ученым расширенное понимание действия нейронов, а технология вычислений постоянно совершенствуется, разработчики сетей имеют неограниченное пространство для улучшения моделей биологического мозга.

Понятие коннекционизма

(от англ. connection — соединение, согласованность, связь) — разработанный в когнитивной науке вычислительный (компьютерный) подход к моделированию мозга, использующий искусственные нейронные сети для имитации процессов познания живых существ (включая человека) и их интеллектуальных способностей.

Согласно взглядам современных коннекционистов, нейронные сети — это упрощенные модели мозга, состоящие из большого числа модулей (аналогов нейронов), которым приписываются веса, измеряющие силу соединений между модулями. Эти веса моделируют действия синапсов, обеспечивающих информационный обмен между нейронами. Модули нейронной сети, соединенные вместе в паттерне подключений, обычно делят на три класса: входные модули, которые получают необходимую для обработки информацию; выходные модули, где содержатся результаты обработки информации; модули, находящиеся между входными и выходными, получившие название скрытых модулей. Если нейронную сеть рассматривать как модель человеческого мозга, то входные модули аналогичны сенсорным нейронам, выходные — моторным нейронам, а скрытые модули — всем др. нейронам. Каждый входной модуль имеет величину возбуждения, репрезентирующую некоторое свойство, внешнее к сети. Сигнал от входных модулей распространяется всеми путями через сеть и определяет величины возбуждения во всех скрытых и выходных модулях. Установленный сетью паттерн возбуждения определяется весами или силой соединений между модулями. Величина возбуждения для каждого получающего сигнал модуля рассчитывается согласно функции возбуждения. Поскольку допускается, что все модули вычисляют в значительной мере ту же самую простую функцию возбуждения, то успешное моделирование человеческих интеллектуальных действий зависит прежде всего от параметров настройки весов между модулями. Поэтому нахождение правильного набора значений, необходимых для выполнения данной задачи, — главная цель в исследованиях коннекционистов. Для этого были изобретены соответствующие алгоритмы, которые могут вычислять правильные значения, необходимые для решения многих задач. Успешное применение коннекционистских методов зависит от весьма тонкой корректировки таких алгоритмов и используемых для обучения значений. Обучение обычно включает сотни тысяч попыток корректировки значений и может занимать дни или даже недели.

Из коннекционистских моделей и методов обучения сетей, в частности, следует, что репрезентация когнитивной информации в мозге скорее не локализована в отдельных нейронах или нейронных узлах, а распределена. Человеческая мысль предполагает образование сложных паттернов, действие которых распределено по относительно большим зонам кортекса. Обучение нейронных сетей показало, что каждая распределенная репрезентация является паттерном, действующим через все модули, т.к. граница между простыми и сложными репрезентациями отсутствует. С позиции К. оказывается, что высшие ментальные процессы представляют собой эмерджентные свойства, систематическим образом зависящие от феноменов низшего уровня. Поскольку мозг представляет собой векторный процессор, то проблемы психологии сводятся тогда к вопросу, какие операции с векторами объясняют различные аспекты человеческого познания.

Схема формального нейрона

Формальная модель нейрона Мак-Каллока-Питтс.

Искусственный нейрон имитирует в первом приближении свойства биологического нейрона. На вход искусственного нейрона поступает некоторое множество сигналов, каждый из которых является выходом другого нейрона. Каждый вход умножается на соответствующий вес, аналогичный синаптической силе, и все произведения суммируются, определяя уровень активации нейрона. На рис. 1.2 представлена модель, реализующая эту идею. Хотя сетевые парадигмы весьма разнообразны, в основе почти всех их лежит эта конфигурация. Здесь множество входных сигналов, обозначенных x 1, x 2, …, x n, поступает на искусственный нейрон. Эти входные сигналы, в совокупности обозначаемые вектором X, соответствуют сигналам, приходящим в синапсы биологического нейрона. Каждый сигнал умножается на соответствующий вес w 1, w 2, …, w n, и поступает на суммирующий блок, обозначенный Σ. Каждый вес соответствует «силе» одной биологической синаптической связи. (Множество весов в совокупности обозначается вектором W.) Суммирующий блок, соответствующий телу биологического элемента, складывает взвешенные входы алгебраически, создавая выход, который мы будем называть NET. В векторных обозначениях это может быть компактно записано следующим образом:

NET = XW.

В модели взвешенная сумма сигналов на входах нейрона сравнивается с пороговым значением h, и на выходе есть сигнал, если она превышает порог. В современных моделях нейронов пороговая функция в общем случае заменяется на нелинейную функцию y=f(S), называемую передаточной функцией или функцией активации нейрона.

Параметрами нейрона, определяющими его работу, являются: вектор весов w, пороговый уровень и вид функции активации F.

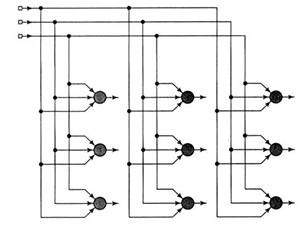

Архитектуры нейронных сетей

Способ структурирования нейронов в сети (организация взаимосвязи) тесно связан с алгоритмом обучения нейронной сети.

Рекуррентные сети

Рекуррентные сети отличаются от сетей прямого распространения наличием хотя бы одной петли обратной связи.

Решетчатые структуры

Решетчатая структура состоит из многомерного массива нейронов с соответствующим множеством входных узлов, которые предоставляют входную информацию сети;

Смешанные структуры

Говоря обобщенно, смешанные структуры не относятся к отдельному типу нейронных структур, а рассматриваются в разделах построения модульных сетей.

| Входной слой узлов источников

| |

| Рисунок 4. Двухмерная решетка 3*3 нейронов

| |

| Рисунок 3. Архитектурный граф рекуррентной сети без собственных обратных связей

| |

Обучение нейросетей.

Обучение сильно напоминает процесс интеллектуального развития человеческой личности. Но возможности обучения искусственных нейронных сетей ограниченны, и нужно решить много сложных задач, чтобы определить, на правильном ли пути мы находимся. Тем не менее уже получены убедительные достижения, и возникает много практических применений.

Цель обучения

Сеть обучается, чтобы для некоторого множества входов давать желаемое (или, по крайней мере, сообразное с ним) множество выходов. Каждое такое входное (или выходное) множество рассматривается как вектор. Обучение осуществляется путем последовательного предъявления входных векторов с одновременной подстройкой весов в соответствии с определенной процедурой. В процессе обучения веса сети постепенно становятся такими, чтобы каждый входной вектор вырабатывал выходной вектор.

Обучение осуществляется путем подбора такого состояния нейросети, при котором выходной вектор адекватен входному. Под состоянием нейронной сети, которое может изменяться, обычно понимается:

· веса синапсов нейронов (карта весов - map) (коннекционистский подход);

· веса синапсов и пороги нейронов (обычно в этом случае порог является более легко изменяемым параметром, чем веса синапсов);

· установление новых связей между нейронами (свойство биологических нейронов устанавливать новые связи и ликвидировать старые называется пластичностью).

По организации обучения разделяют обучение нейронных сетей с учителем (supervised neural networks) и без учителя (nonsupervised).

Обучение с учителем. Обучение с учителем предполагает, что для каждого входного вектора существует целевой вектор, представляющий собой требуемый выход. Вместе они называются обучающей парой. Обычно сеть обучается на некотором числе таких обучающих пар. Предъявляется выходной вектор, вычисляется выход сети и сравнивается с соответствующим целевым вектором, разность (ошибка) с помощью обратной связи подается в сеть и веса изменяются в соответствии с алгоритмом, стремящимся минимизировать ошибку. Векторы обучающего множества предъявляются последовательно, вычисляются ошибки и веса подстраиваются для каждого вектора до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо низкого уровня.

Обучение без учителя. Несмотря на многочисленные прикладные достижения, обучение с учителем критиковалось за свою биологическую неправдоподобность. Обучение без учителя является намного более правдоподобной моделью обучения в биологической системе. Развитая Кохоненом [3] и многими другими, она не нуждается в целевом векторе для выходов и, следовательно, не требует сравнения с предопределенными идеальными ответами. Обучающее множество состоит лишь из входных векторов. Обучающий алгоритм подстраивает веса сети так, чтобы получались согласованные выходные векторы, т. е. чтобы предъявление достаточно близких входных векторов давало одинаковые выходы.

Генетические алгоритмы. Основные понятия, принципы и особенности построения.

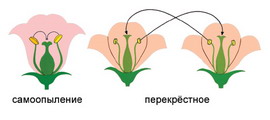

Генети́ческий алгори́тм (англ. genetic algorithm) — это эвристический алгоритм поиска, используемый для решения задач оптимизации и моделирования путем последовательного подбора, комбинирования и вариации искомых параметров с использованием механизмов, напоминающих биологическую эволюцию. Является разновидностью эволюционных вычислений (англ. evolutionary computation). Отличительной особенностью генетического алгоритма является акцент на использование оператора «скрещивания», который производит операцию рекомбинации решений-кандидатов, роль которой аналогична роли скрещивания в живой природе. «Отцом-основателем» генетических алгоритмов считается Джон Холланд (англ. John Holland), книга которого «Адаптация в естественных и искусственных системах» (англ. Adaptation in Natural and Artificial Systems) является основополагающим трудом в этой области исследований.

Задача кодируется таким образом, чтобы её решение могло быть представлено в виде вектора («хромосома»). Случайным образом создаётся некоторое количество начальных векторов («начальная популяция»). Они оцениваются с использованием «функции приспособленности», в результате чего каждому вектору присваивается определённое значение («приспособленность»), которое определяет вероятность выживания организма, представленного данным вектором. После этого с использованием полученных значений приспособленности выбираются вектора (селекция), допущенные к «скрещиванию». К этим векторам применяются «генетические операторы» (в большинстве случаев «скрещивание» - crossover и «мутация» - mutation), создавая таким образом следующее «поколение». Особи следующего поколения также оцениваются, затем производится селекция, применяются генетические операторы и т. д. Так моделируется «эволюционный процесс», продолжающийся несколько жизненных циклов (поколений), пока не будет выполнен критерий останова алгоритма. Таким критерием может быть:

нахождение глобального, либо субоптимального решения;

исчерпание числа поколений, отпущенных на эволюцию;

исчерпание времени, отпущенного на эволюцию.

Генетические алгоритмы служат, главным образом, для поиска решений в очень больших, сложных пространствах поиска.

Таким образом, можно выделить следующие этапы генетического алгоритма:

1 Создание начальной популяции

2 Вычисление функций приспособленности для особей популяции (оценивание)

(Начало цикла)

3 Выбор индивидов из текущей популяции (селекция)

4 Скрещивание и\или мутация

5 Вычисление функций приспособленности для всех особей

6 Формирование нового поколения

Если выполняются условия останова, то (конец цикла), иначе (начало цикла).

Знания как основа принятия решений

Принятие решений – генерация возможных альтернативных решений, оценка этих альтернатив и выбор наилучшего решения.

Поддержка ПР – информация (книги, опыт др. людей).

Задача ИИ – поддержка управленческих решений.

Принять решение – выбрать такую альтернативу из числа возможных, которая с учетом всех разнообразных и противоречивых требований будет максимально способствовать достижению поставленной цели (оптимизация). Множество альтернатив человек формирует сам.

Неотъемлемой частью ПР является неопределенность в выборе альтернатив. Для снятия неопределенности нужна объективная оценка ситуации, основанная на знании. Знания основываются на инфе относительно состояния проблемной области, которой располагает ЛПР.

Инфа – это то, что позволяет принять решение или осознанный выбор. Инф-ые ед-цы – это элементы инфы.

Свойства знаний:

1) внутренняя интерпретируемость (каждая структурная единица должна иметь уникальное имя и однозначно определяться)

2) структурируемость – м\у инф-ыми ед-цами д.б. установлены определенные отношения (отношение типа «часть-целое», «род - вид» и т.д.)

Знания должны определяться как система (некоторое множество элементов, позволяющее получить новые свойства). Знания должны представлять собой систему. Управлять можно только при наличии систематических знаний. Системы ИИ – это системы, в основе которых лежат знания.

Понятие «система»

Система – некоторое множество элементов, позволяющее получить новые свойства.

Система – это перечисление ее свойств.

Свойства:

1) Система д.б. разделима на подсистемы, к-ые тоже м.б.разделены и т.д., вплоть до элементов. Элемент – это такая часть системы, внутрь которой описание не проникает. Понятие «элемент» зависит от поставленной задачи (от глубины описания).

2) Наличие сильных и устойчивых связей м\у эл-ми, сила к-ых значительно превосходит силу связей эл-ов с окружающей средой.

3) Наличие структуры (организации) – наличие упорядоченных в пр-ве и во времени эл-ов, подсистем и связей м\у ними.

4) Наличие системного эффекта – это свойство, присущее только системе в целом и отсутствующее у каждого из ее элементов. Надежная система м.б. построена из ненадежных элементов (при определенной организации).

5) Наличие цели функционирования. Цель биологического объекта – жить и продолжать род. Цель интеллектуальной системы закладывается при проектировании.

6) Наличие окружающей среды (любая система способна функционировать только в окружающей среде; обмениваясь при этом инфой, энергией, материей одновременно)

3. Понятия «данные», «инфа», «знания» и связь м\у ними

Инфа основывается на данных, т.е. на элементах описания предметной области.

Данные + Процедуры обработки = Инфа

Инфа + Процедуры обработки = Знания

Пример: Read Only Memory – символьные данные.

читать только память (интеллектуальный переводчик) или память только для чтения - альтернативы. Данные сопоставляем со словарем и получаем инфу (понятные данные). Нужны дополнительные внешние знания о правилах перевода, они не содержаться в данной фразе. Применяя внешние знания о правилах перевода к переведенным словам, получаем знания.

Формула Вирта: Программа = Алгоритм обработки + Исходные данные.

Данные будут поняты только тогда, когда к ним будет применен алгоритм обработки.

Данные (декларативные) – это характеристика проблемной области.

Процедурные знания в алгоритме – это как обработать данные, атрибуты, способ их обработки.

Пример: Часы показывают 12.15. В мозг передается сигнал, в мозге формируется изображение; данные соотносятся со шкалой времени и => получили инфу. Человек подключил внешние знания и сравнивает с к.-л. событием (расписание занятий) => знания: опаздывает.

Знания не содержатся в исходных данных. Знания возникают в результате сопоставления элементов инфы (о времени и о расписании). И затем принимается решение.

Формализованные знания. Сущность и сферы использования. Примеры.

Формализованные знания формируют в виде строгих суждений, образующих так называемую формализованную систему. Задачи формализованной системы – в конкретной ситуации определять степень истинности каждого из этих суждений. Формализованные знания – связка элементов.

F=<A, P, X, I>.

A–алфавит – набор символов, из которых строятся предложения формализованных систем, Р – синтаксические правила построения предложений из алфавита А, Х – аксиомы, т.е. тождественно истинные предложения.

Пример: аксиоматическая теория вероятности Колмагорова.

По фон-Мезесу: вероятность – это m\n, (где m – количество успехов, n – количество экспериментов) при соблюдении условия однородности. Условия статистической устойчивости: m\n – частота и она приблизительно равна m`\n`. Где n`<n. При этом последовательность n` должна выбираться заранее, до опытов. Можно выбирать в качестве n` только успешные или только неуспешные события. m\n – это способ измерения.

При аксиоматическом определении вероятности, вероятность задается перечислением ее свойств. Выбираем из частоты m\n только существенные свойства.

Свойства:

1) m\n > 0 - Частота неотрицательная величина.

2) Если событие появляется при каждом испытании, т.е. оно достоверно при любых n, то m=n и m\n=1.

3) Если m1 результатов испытаний из n испытаний привело к появлению события А, а m2 результатов испытаний повлекли событие В, при этом события А и В не появились одновременно (ни в одном из n испытаний), то частота появления события, состоящего в появлении либо А либо В: m\n= m1\n + m2\n.

Вероятностью появления события называется численная мера возможности наступления этого события при некотором испытании.

Формулировка аксиом: 1) для каждого случайного события А определена его веро<

, то вероятность совместного наступления этих событий

, то вероятность совместного наступления этих событий  .

. как множество элементарных событий.

как множество элементарных событий.  , - по 3-ей аксиоме.

, - по 3-ей аксиоме.  .

. R2 и определяется выражением:

R2 и определяется выражением:  .

. и определяется функцией принадлежности:

и определяется функцией принадлежности: (x,y) = 1 - µR (x,y)

(x,y) = 1 - µR (x,y)

σ – размах колокола

σ – размах колокола