Индивидуальные и групповые автопоилки: для животных. Схемы и конструкции...

История создания датчика движения: Первый прибор для обнаружения движения был изобретен немецким физиком Генрихом Герцем...

Индивидуальные и групповые автопоилки: для животных. Схемы и конструкции...

История создания датчика движения: Первый прибор для обнаружения движения был изобретен немецким физиком Генрихом Герцем...

Топ:

Марксистская теория происхождения государства: По мнению Маркса и Энгельса, в основе развития общества, происходящих в нем изменений лежит...

Отражение на счетах бухгалтерского учета процесса приобретения: Процесс заготовления представляет систему экономических событий, включающих приобретение организацией у поставщиков сырья...

Техника безопасности при работе на пароконвектомате: К обслуживанию пароконвектомата допускаются лица, прошедшие технический минимум по эксплуатации оборудования...

Интересное:

Наиболее распространенные виды рака: Раковая опухоль — это самостоятельное новообразование, которое может возникнуть и от повышенного давления...

Национальное богатство страны и его составляющие: для оценки элементов национального богатства используются...

Что нужно делать при лейкемии: Прежде всего, необходимо выяснить, не страдаете ли вы каким-либо душевным недугом...

Дисциплины:

|

из

5.00

|

Заказать работу |

|

|

|

|

Точность измерений — качество измерений, отражающее близость измеренного значения к истинному значению измеряемой величины.

Количественным выражением качественного понятия «точность» является погрешность или отклонение. Следует различать погрешность самого измерения и погрешность средства измерений. Погрешность измерения носит случайный и личностный, а погрешность самого СИ – систематический характер.

Истинное значение измеряемой величины в силу ее случайной природы принципиально не может быть найдено, поэтому истинное значение погрешности также не может быть определено, но в процессе обработки результатов измерений могут быть найдены оценки (приближенные значения) как самой измеряемой величины, так и диапазон значений погрешности.

Рассмотрим основные классификационные признаки погрешности результатов измерений.

Первый классификационный признак: что или кто является причиной ошибки. Суммарная погрешность результата любого измерения в общем случае складывается из трех составляющих: инструментальной, методической и субъективной.

Инструментальная составляющая погрешности определяется основными метрологическими характеристиками СИ, его основной и дополнительной (при отступлении от нормальных условий измерения) погрешностями.

Методическая составляющая погрешности результата измерения зависит от используемого метода измерения и не зависит от погрешности самого инструмента. Эта погрешность может быть значительной (например, при взвешивании яблока на товарных весах), однако часто она может быть оценена или даже скомпенсирована полностью или частично (введением поправки к результату измерения).

|

|

Субъективная составляющая не зависит ни от погрешности прибора, ни от метода измерения, а в основном определяется квалификацией оператора или лаборанта.

Второй классификационный признак — способ выражения погрешности в абсолютном или относительном виде. Абсолютная погрешность Δ — это разность между измеренным Х и истинным Хист (или действительным Хд , т.е. полученным более точным прибором либо усреднением результатов нескольких, измеренных менее точным прибором) значениями измеряемой величины. Относительная погрешность δ - отношение абсолютной погрешности к действительному Хд (или измеренному Х/ при проведении однократного измерения) значению, выраженное в безразмерных единицах, либо в процентах.

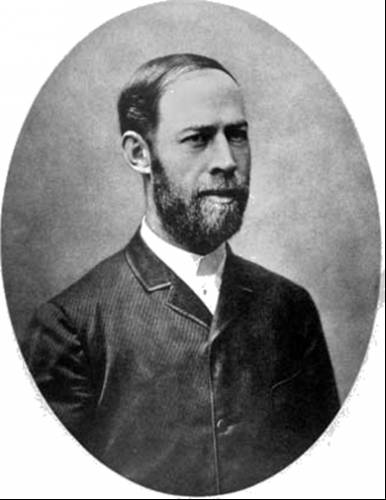

Третий классификационный признак — зависимость погрешности (абсолютной или относительной) от значения измеряемой величины Х. По этому признаку погрешности подразделяются на аддитивные, мультипликативные и погрешности линейности.

Аддитивной называют погрешность Δа, значения которой не выходят за рамки, независящего от измеряемой величины Х, коридора Δаm (см. рис. 2а), из которого видно, что максимальное значение абсолютной погрешности, т.е. ее границу, можно принять постоянной величной.

Мультипликативной называется такая абсолютная погрешность Δм, значения которой не выходят за рамки линейного зависящего от значения измеряемой величины Х коридора (см. рис. 2б). Любое другое поведение Δ, отличающееся от рассмотренных двух, называется нелинейной погрешностью или просто нелинейностью (см. рис. 2в).

Рис. 2 Зависимость погрешности от измеряемой величины Х

Четвертый классификационный признак — характер проявления погрешности. Погрешности подразделяются на систематические и случайные. Систематическая - это такая погрешность, значение которой при повторении эксперимента неизменно или меняется по известному закону. Систематические погрешности, как правило, могут быть оценены и, следовательно, скомпенсированы путем введения поправок в результаты измерения. (Например если систематические погрешность термометра Δs =+0,5C0, то для исключения этой погрешности из показания термометра нужно вычитать 0,5С0).

|

|

Случайные — это такие погрешности, значения которых непредсказуемы, поскольку зависят от множества меняющихся во времени факторов. Строгий учет погрешностей случайного характера осуществляется методами теории ошибок, основанной на теории вероятности и математической статистике.

Как правило, определяющей составляющей в суммарной погрешности результата измерений ΔΣ является погрешность самого СИ, т.е. инструментальная погрешность, которая может иметь основную и дополнительную составляющие.

Основная погрешность имеет место в нормальных условиях эксплуатации СИ (в частности прибора), т.е. когда значения всех влияющих величин (ВВ) находятся в пределах заранее оговоренных диапазонов. (Например, нормальной считается температура в диапазоне 20 ±50С). В этом случае основная погрешность СИ определяется его классом точности по определенному правилу.

Дополнительная погрешность возникает при изменении влияющих величин (например температуры окружающей среды) за пределы нормальных значений, находясь в некотором заранее оговоренном диапазоне (рабочий интервал значений ВВ). В этом случае суммарная инструментальная погрешность складывается из основной и дополнительной (одной или нескольких) определяемой по заданному правилу. Рассмотрим пример нахождения оценки дополнительной составляющей инструментальной погрешности по наиболее важной ВВ — температуре. Пример: допустим, по классу точности миллиамперметра найдена его основная инструментальная погрешность Δ0 = ±1,0мА, температура в ходе эксперимента была зафиксирована +280С. Температурный коэффициент в паспорте на прибор определен таким образом: «дополнительная погрешность на каждые 100С отличия от номинальной температуры +200С равна основной погрешности в пределах изменения температуры окружающей среды от 0 до +500С. Тогда предельное значение дополнительной абсолютной погрешности Δд найдется:

Δд =Δ0(28-20)/10=8/10=0,8мА

Таким образом, суммарная неисключенная систематическая инструментальная погрешность миллиамперметра будет равна ΔΣ=(Δ0+Δд)=1,8мА, то есть пределы суммарной инструментальной систематической погрешности составляют ±1,8мА.

|

|

Статическая погрешность СИ - погрешность при измерении постоянной (или очень медленно меняющейся) величины Х, т.е. в случае статических измерений.

Динамическая погрешность возникает при исследовании достаточно быстро меняющейся во времени величины Х(t) (точнее информативного параметра измеряемой величины). Возникновение этой погрешности связано с инерционными свойствами СИ. Все рассмотренные погрешности СИ схематично можно представить в виде (см. рис. 3).

Рис. 3 Упрощенная классификация погрешностей СИ

|

|

|

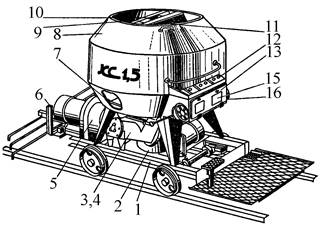

Кормораздатчик мобильный электрифицированный: схема и процесс работы устройства...

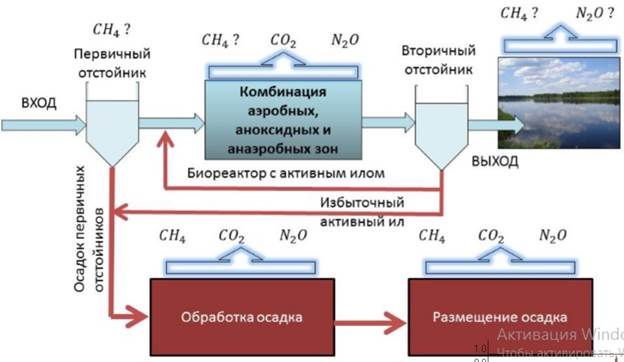

Эмиссия газов от очистных сооружений канализации: В последние годы внимание мирового сообщества сосредоточено на экологических проблемах...

Биохимия спиртового брожения: Основу технологии получения пива составляет спиртовое брожение, - при котором сахар превращается...

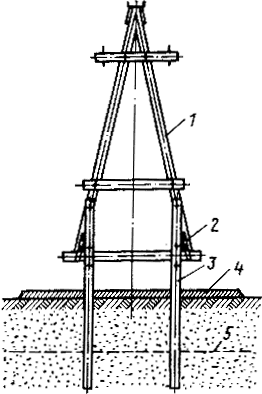

Особенности сооружения опор в сложных условиях: Сооружение ВЛ в районах с суровыми климатическими и тяжелыми геологическими условиями...

© cyberpedia.su 2017-2024 - Не является автором материалов. Исключительное право сохранено за автором текста.

Если вы не хотите, чтобы данный материал был у нас на сайте, перейдите по ссылке: Нарушение авторских прав. Мы поможем в написании вашей работы!